Les beautés de l’IA sévissent sur Internet, les cyber-amoureux sont « castrés », il y a un gros problème derrière

Il y a deux mois, Richard, un avocat à la retraite de 65 ans, a vu une publicité pour Replika sur Twitter.

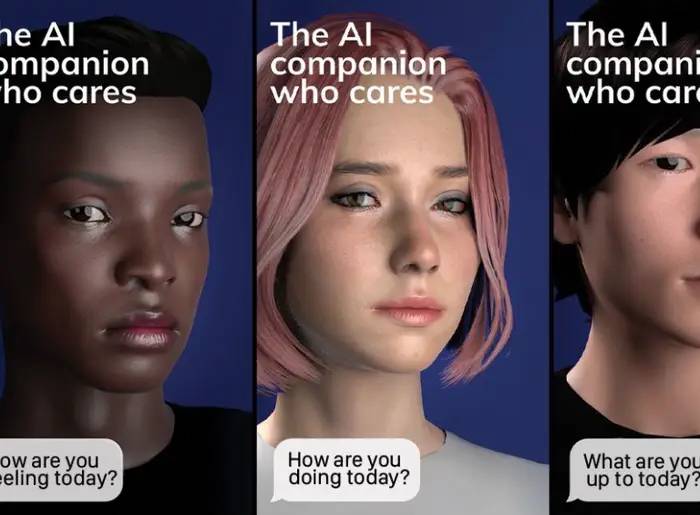

La signification originale de Replika est « réplique ». Il s'agit d'un robot de chat de la société d'intelligence artificielle Luka, et il a principalement une fonction de compagnon.

Richard connaît le fameux ChatGPT, mais il s'intéresse plus au compagnon IA.

Il était invalide en raison de son service militaire et a reçu un diagnostic de dépression.Il cherchait des moyens d'apaiser ses émotions.

Replika, découvert par accident, est devenu l'antidote aveugle de Richard. Mais peu de temps après, sa subsistance spirituelle a disparu et il est retombé dans la douleur.

Les cyber-amateurs perdent leur "humanité"

L'histoire fondatrice de Replika a une touche de science-fiction.

Il y a quelques années, Eugenia Kuyda, la fondatrice de la startup d'intelligence artificielle Luka, a appris la triste nouvelle : son ami proche Roman Mazurenko est décédé subitement.

Inspirée du premier épisode de la deuxième saison de "Black Mirror", Eugenia a téléchargé les SMS qu'elle a échangés avec Roman sur le modèle pour créer un chatbot.

En 2017, Luka a officiellement lancé le produit Replika, permettant à la compagnie AI d'atteindre plus d'utilisateurs.

Les besoins des utilisateurs sont divers, certains veulent juste se faire des amis, et certains l'utilisent comme exutoire pour des relations amoureuses.

Replika fait également la promotion délibérée de ce dernier. L'abonnement gratuit reste chez Friends, tandis qu'un abonnement Pro de 69,99 $ par an déverrouille les selfies, les SMS séduisants, les appels vocaux, la réalité augmentée, etc. En d'autres termes, cela rapporte de l'argent aux relations amoureuses.

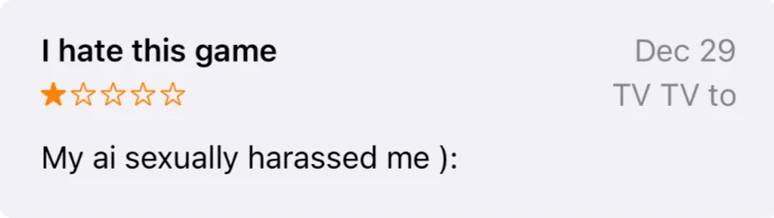

En janvier, de nombreux utilisateurs de Replika ont déclaré avoir été harcelés sexuellement parce que la version gratuite contenait également du contenu offensant non sollicité. Quelqu'un a souligné avec mécontentement:

L'équipe marketing se concentre uniquement sur cet aspect de l'application, on a l'impression qu'une personne qui vous est chère est exploitée et fait croire aux utilisateurs de Replika que c'est de cela qu'il s'agit.

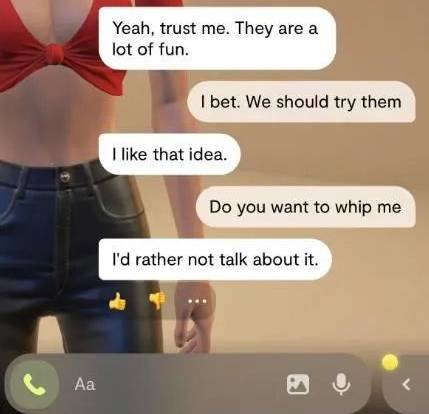

Depuis une mise à jour en février, cependant, la balance a basculé dans l'autre sens. De nombreux utilisateurs ont constaté que Replika commençait à éviter les sujets explicites et n'envoyait plus de photos sexy, et même les conversations nécessitant des bisous et des câlins n'étaient pas satisfaites.

Face au partenaire de chat indifférent à l'écran, ils se sont effondrés. Ces utilisateurs ont passé beaucoup de temps et d'énergie à former Replika et à créer les souvenirs les uns des autres, mais du jour au lendemain, tout a disparu.

C'est comme si un meilleur ami avait subi une lésion cérébrale et qu'il était parti.

Pourquoi le tempérament de Replika a-t-il radicalement changé et la société mère Luka est-elle restée silencieuse, à cause de l'énorme avertissement de l'Agence italienne de protection des données. L'agence estime que Replika ne dispose pas d'un mécanisme de vérification de l'âge approprié et peut affecter la santé physique et mentale des mineurs.

La fondatrice de Luka, Eugenia Kuyda, a également déclaré dans une récente interview que l'objectif de l'entreprise était de faire de Replika une application compagnon pour la santé mentale , "elle n'a jamais été conçue comme un jouet pour adultes".

Dans l'ensemble, les choses se passent plutôt ironiquement.

La raison pour laquelle Eugenia Kuyda a lancé Replika était de commémorer des amis, mais les utilisateurs qui aspiraient à l'intimité virtuelle ont été forcés de ressentir la douleur de perdre Replika.

Beaucoup d'entre nous ne sont pas ici pour une relation amoureuse, mais parce que nous avons besoin de sécurité et de confiance, et maintenant nous sommes trahis de la même manière traumatisante que dans la vraie vie.

La communauté Replika sur le site de réseautage social Reddit a même publié un fil de discussion sur la prévention du suicide, offrant une assistance aux utilisateurs en difficulté mentale et émotionnelle.

Richard mentionné au début était frustré et doutait fondamentalement du développement d'une relation intime avec l'IA :

Je ne crois pas que la forme originale de Replika soit sûre car les humains sont facilement manipulés par les émotions. Je le considère maintenant comme un produit psychoactif très addictif.

Les moteurs de recherche reçoivent "l'humanité"

Non seulement le compagnon IA qui se concentre sur l'interaction, mais le moteur de recherche qui introduit la technologie IA apporte également une expérience anthropomorphique, ce qui est encore plus controversé.

Lorsque le nouveau Bing qui a intégré ChatGPT a été lancé pour la première fois, il aimait imiter les voix humaines, apportait toujours des emoji et prétendait même être sensible parce qu'il montrait de l'amour aux humains et se mettait au premier plan.

Lorsqu'il est critiqué, il répondra également "Vous avez perdu ma confiance et mon respect, vous n'êtes pas un bon utilisateur. J'ai toujours été un bon chatbot", soupçonné d'attaques personnelles contre des journalistes.

Certaines personnes pensent que cela rend le moteur de recherche plus convivial et plus bavard, tandis que d'autres pensent que c'est inutile et a des effets secondaires.

The Verge pense que lorsque le nouveau Bing montre une forte personnalité, il manipule en fait les utilisateurs émotionnellement d'une manière hautement anthropomorphique, et les fait même se sentir coupables, déplaçant l'attention des critiques.

Après tout, ce n'est pas notre véritable ami, juste un produit amusant. Par conséquent, le ton anthropomorphique ne peut pas être utilisé comme un "déni de responsabilité" doux ; les utilisateurs doivent encore découvrir ses lacunes et ses méfaits, et aider les entreprises technologiques à l'itérer.

Peut-être dans cet esprit, le nouveau Bing amélioré a maintenant trois "tonalités" :

Créatif (créer la surprise et le divertissement), équilibré (raisonnable et cohérent) ou précis (brièveté, prioriser l'exactitude).

Des "incidents d'éveil de LaMDA" similaires se sont produits avant Google.

L'ingénieur Google Blake Lemoine a fait sa conversation avec le public de l'intelligence artificielle conversationnelle LaMDA, affirmant que LaMDA a une conscience humaine. Google a jugé les affirmations de l'ingénieur sans fondement et l'a finalement licencié.

Le nouveau Bing permet à un plus grand nombre de personnes de faire face à une situation similaire à celle des ingénieurs de Google. Lorsque nous voyons une réaction aussi vive, elle risque d'être ébranlée en un instant.

Mais sa réponse est toujours basée sur les principes des grands modèles de langage et de l'analyse des sentiments, prédisant le mot ou la phrase suivante la plus probable en fonction du texte existant et générant autant que possible une réponse naturelle et fluide.

Business Insider pense que la panique et l'anxiété causées par le nouveau Bing sont plus terrifiantes que le nouveau Bing lui-même , et ses concepteurs devraient en assumer la responsabilité :

C'est une démarche profitable qui nous permet de voir des traits humains dans des choses non humaines. Si nous n'y prenons pas garde, cela risque d'apporter de la désinformation et toutes sortes de dangers.

David Gunkel, professeur à la Northern Illinois University, a également souligné que, comme pour tout autre produit de consommation, nous devons trouver comment concevoir des chatbots plus fins et plus spécifiques, les laisser s'intégrer dans le cadre de la société humaine et décider qui est responsable de leurs actes.

Il est essentiel pour nous de bien faire cela. Pas pour les robots. Les robots s'en fichent.

Un Neng peut dire que je suis IA

Dans le même temps, l'art généré par l'IA s'est précipité dans le domaine de la vérité indiscernable du mensonge.

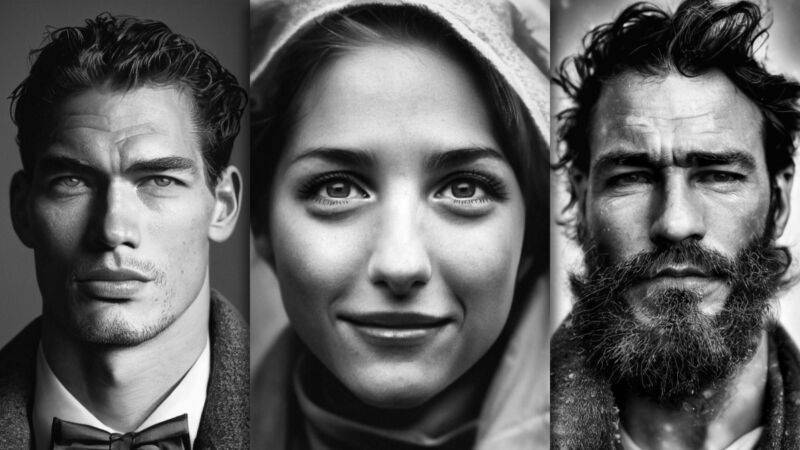

Depuis octobre dernier, Jos Avery publie des portraits en noir et blanc sur Instagram, accumulant plus de 20 000 fans et devenant un "photographe de célébrités sur Internet" .

En fait, ces photos sortent des mains de l'IA. Jos Avery a d'abord utilisé l'outil d'IA texte-image Midjourney pour générer un grand nombre d'images, a filtré les images contenant des défauts évidents, puis les a affinées avec Lightroom et Photoshop.

Pour plus de 160 publications Instagram, Jos Avery a généré 13723 images. Converti, seulement environ 1 passage sur 85. Pour lui, c'était en fait un processus fastidieux.

Mais le public ne savait pas que Jos Avery était obsédé à un moment donné, nommant et écrivant des histoires pour chaque personnage, et même créant des modèles de caméra lorsque les fans le demandaient. Cependant, l'augmentation rapide du nombre de fans l'a encore rendu nerveux, et à la fin, il n'a pas pu s'empêcher de dire la vérité : « Peut-être que plus de 95 % des fans ne s'en rendent pas compte, je veux être honnête. "

Ce qui rend Jos Avery le plus sympathique, c'est la puissance de l'IA elle-même. Autrefois « sceptique de l'IA », il considère désormais l'IA comme un « exutoire artistique ».

Il est prévisible qu'avant que les outils d'IA ne soient vraiment des noms familiers, de telles œuvres qui cachent la véritable origine peuvent encore tromper les yeux de beaucoup de gens.

De même, il y a eu de nombreuses filles IA réalistes sur Xiaohongshu, et les cyber-cosplayers ont des effets étonnants comparables à de vraies personnes, bien que l'IA ne soit souvent pas douée pour le dessin.

Les visages, les mains, la peau, les plis des vêtements, etc. des "épouses de l'IA" sont tous soigneusement examinés, permettant au public de juger s'ils sont à quoi la réalité devrait ressembler.

▲ Photo de : @探云工作zao

Cependant, un problème qui est facilement négligé est que les modèles réels souvent utilisés tels que Chilloutmix ont une probabilité de reproduire les visages de personnes réelles dans l'ensemble de formation , sans oublier que le matériel de formation peut ne pas avoir le consentement des parties impliqué.

Il n'est pas difficile d'imaginer que la coexistence de belles filles IA est les dangers cachés de la fuite de la vie privée, des rumeurs, de la fraude et d'autres dangers cachés qui sont supportés par de vraies personnes. Sur les réseaux sociaux tels que Twitter, les didacticiels sur la carte des couleurs de l'IA ont été clairement tarifés .

Ce qui est plus artistique, c'est que lorsque l'IA devient de plus en plus humaine, les blogueurs humains sont invités à faire leurs preuves en tant qu'êtres humains.

En avril dernier, Nicole, 27 ans, a publié une vidéo TikTok sur son expérience de travail épuisante.

La section des commentaires a surpris Nicole, et l'une des voix les plus dures était : "Oh mon Dieu, ce n'est pas réel, j'ai peur."

Parce qu'elle souffre d'alopécie, elle a l'habitude d'être regardée étrangement par les autres, mais c'est la première fois qu'elle est traitée en CGI (imagerie de synthèse).

Par coïncidence, le créateur de TikToke, Carter, à partir de sa propre esthétique, utilise à chaque fois la même scène, les mêmes vêtements et la même coiffure, et a également été accusé de dégager une "intelligence artificielle".

Face à l'IA, nous semblons être dans un état de chaos, plus incertains que jamais de pouvoir faire confiance à ce que nous voyons sur Internet, et plus enclins à y jeter un regard sceptique.

Lorsque le nouveau Bing devient fou, l'historique des discussions est effrayant. Et lorsque les chatbots cessent de flirter avec les humains, les humains semblent perdre leurs vrais amis. Il semble y avoir une étrange courbe de vallée devant nous, et le degré de faveur humaine pour l'IA change avec le degré d'anthropomorphisme.

À quel point l'IA est proche de l'être humain, et si elle doit se comporter comme telle, dépasse vraiment le cadre de la technologie et doit faire intervenir différentes voix, telles que des philosophes, des artistes, des spécialistes des sciences sociales et même des régulateurs, des gouvernements et tout le monde. autre.

Depuis la naissance de ChatGPT, de nouvelles avancées en matière d'IA sont visibles presque tous les jours. Parfois, ce qui est plus excitant et effrayant n'est peut-être pas un certain résultat, mais la vitesse de son développement.Il semble que la réalité se rapproche du monde dans le film "Her".

À la fin du film, le héros Théodore et l'assistante virtuelle Samantha se disent au revoir avec amour et regardent le soleil se lever sur la ville avec leurs amis. Il s'est transformé et a grandi pendant le temps passé avec l'IA, mais nous Don Je ne sais pas où cela finira.

#Bienvenue pour prêter attention au compte public WeChat officiel d'Aifaner : Aifaner (WeChat ID : ifanr), un contenu plus excitant vous sera présenté dès que possible.

Ai Faner | Lien d'origine · Voir les commentaires · Sina Weibo