Les nouveaux GPU refroidis par liquide de Nvidia se dirigent vers les centres de données

Nvidia prend quelques notes de la part des passionnés de construction de PC dans le but de réduire l'empreinte carbone des centres de données. La société a annoncé deux nouveaux GPU refroidis par liquide lors de son discours d'ouverture Computex 2022 , mais ils ne feront pas leur chemin dans votre prochain PC de jeu.

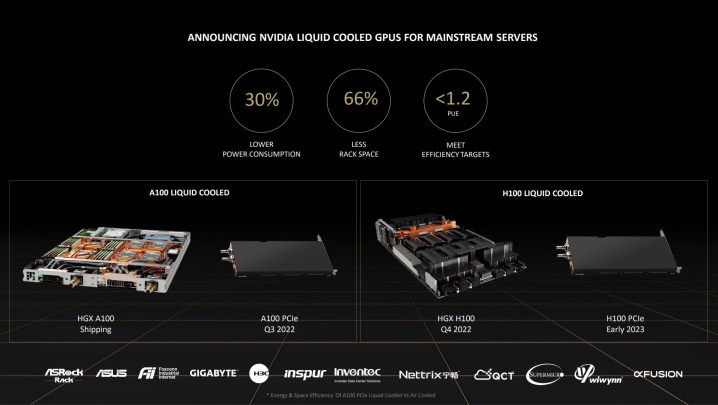

Au lieu de cela, les GPU H100 (annoncés au GTC plus tôt cette année ) et A100 seront livrés dans le cadre des racks de serveurs HGX vers la fin de l'année. Le refroidissement liquide n'est pas nouveau dans le monde des superordinateurs, mais les serveurs de centres de données traditionnels n'ont pas toujours été en mesure d'accéder à cette méthode de refroidissement efficace (pas sans essayer de truquer un GPU de jeu dans un serveur, c'est-à-dire).

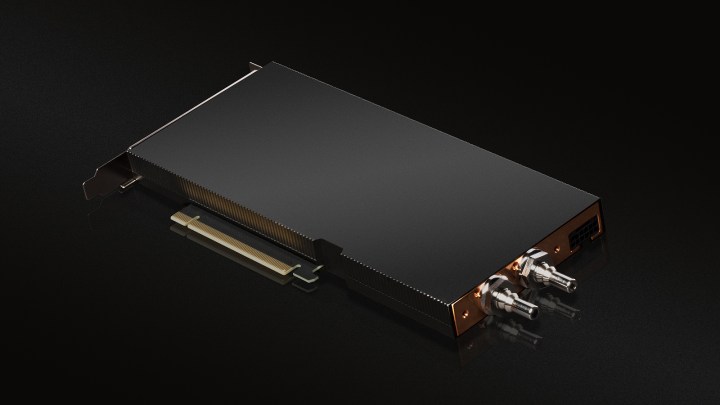

En plus des racks de serveurs HGX, Nvidia proposera les versions refroidies par liquide des H100 et A100 sous forme de cartes PCIe enfichables. L'A100 arrive dans la seconde moitié de 2022 et le H100 arrive au début de 2023. Nvidia dit qu'"au moins une douzaine" de constructeurs de systèmes auront ces GPU disponibles d'ici la fin de l'année, y compris des options d'Asus, ASRock et Gigaoctet.

Les centres de données représentent environ 1 % de la consommation totale d'électricité dans le monde, et près de la moitié de cette électricité est dépensée uniquement pour refroidir tout ce qui se trouve dans le centre de données. Contrairement au refroidissement par air traditionnel, Nvidia affirme que ses nouvelles cartes refroidies par liquide peuvent réduire la consommation d'énergie d'environ 30 % tout en réduisant l'espace du rack de 66 %.

Au lieu d'un système tout-en-un comme vous le trouverez sur un GPU de jeu refroidi par liquide, les A100 et H100 utilisent une connexion liquide directe à l'unité de traitement elle-même. Tout sauf les lignes d'alimentation est caché dans le boîtier GPU, qui lui-même n'occupe qu'un seul emplacement PCIe (contre deux pour les versions refroidies par air).

Les centres de données examinent l'efficacité de l'utilisation de l'énergie (PUE) pour évaluer la consommation d'énergie – essentiellement un rapport entre la quantité d'énergie consommée par un centre de données et la quantité d'énergie utilisée par l'informatique. Avec un datacenter refroidi par air, Equinix avait un PUE d'environ 1,6. Le refroidissement liquide avec les nouveaux GPU de Nvidia a ramené ce chiffre à 1,15, ce qui est remarquablement proche de l'objectif des centres de données 1.0 PUE.

En plus d'une meilleure efficacité énergétique, Nvidia affirme que le refroidissement liquide offre des avantages pour la préservation de l'eau. La société affirme que des millions de gallons d'eau sont évaporés chaque année dans les centres de données pour maintenir le fonctionnement des systèmes refroidis par air. Le refroidissement liquide permet à cette eau de recirculer, transformant "un déchet en un atout", selon le responsable de l'infrastructure de périphérie chez Equinix Zac Smith.

Bien que ces cartes n'apparaissent pas dans les énormes centres de données gérés par Google, Microsoft et Amazon – qui utilisent probablement déjà le refroidissement liquide – cela ne signifie pas qu'elles n'auront pas d'impact. Les banques, les institutions médicales et les fournisseurs de centres de données comme Equinix compromettent une grande partie des centres de données actuels, et ils pourraient tous bénéficier de GPU refroidis par liquide.

Nvidia dit que ce n'est que le début d'un voyage vers des centres de données neutres en carbone. Dans un communiqué de presse, Joe Delaere, directeur principal du marketing produit chez Nvidia, a écrit que la société prévoyait "de prendre en charge le refroidissement par liquide dans nos GPU de centre de données hautes performances et nos plates-formes Nvidia HGX dans un avenir prévisible".