Mon appareil photo iPhone 14 Pro est en ruine, et tout est de la faute d’Apple

Chaque année, Apple vante l' iPhone comme ayant un système de caméra incroyable – et, oui, le matériel est certainement impressionnant. L' iPhone 14 Pro dispose des dernières avancées proposées par Apple en termes de mises à niveau de l'appareil photo, notamment un énorme saut vers un appareil photo principal de 48 MP avec technologie de regroupement de pixels (quatre sous-pixels pour constituer un pixel plus grand), un téléobjectif avec optique 3x zoom, mode nuit plus rapide, et plus encore. Encore une fois, sur le plan matériel, la caméra de l'iPhone 14 Pro est impressionnante. Et c'est!

Mais à quoi sert un excellent matériel photo lorsque le logiciel continue de ruiner les images que vous prenez ? Depuis la gamme iPhone 13 , il semble que toutes les images prises à partir d'un iPhone, à moins qu'elles ne soient prises au format ProRaw, semblent mauvaises par rapport à celles prises sur les anciens iPhones et les meilleurs téléphones Android concurrents. C'est parce qu'Apple a augmenté la vitesse de la photographie informatique et du post-traitement chaque fois que vous capturez une photo. Cela ruine mes images, et Apple doit prendre une pilule de refroidissement et la réduire d'un cran.

Ces fonctionnalités "intelligentes" ne sont pas aussi intelligentes qu'elles le prétendent

Pour prendre des photos, nous avons besoin de capteurs qui aident à capturer la lumière et les détails pour créer ces images. Cependant, comme les smartphones sont beaucoup plus compacts qu'un reflex numérique complet, les capteurs sont assez limités dans ce qu'ils peuvent faire. C'est pourquoi Apple, ainsi que d'autres fabricants de smartphones, peuvent s'appuyer sur des logiciels pour améliorer la qualité d'image des photos que vous capturez sur un téléphone.

Apple a introduit Smart HDR sur l'iPhone en 2018, et cette fonctionnalité logicielle en est maintenant à sa quatrième itération avec la gamme iPhone 14 . Avec Smart HDR 4, l'appareil prendra plusieurs photos avec différents paramètres, puis combinera les "meilleurs" éléments de chaque image en une seule photo. Il y a beaucoup de photographie informatique en cours avec ce processus, et bien que l'intention soit de rendre les images belles, cela fait en fait le contraire.

Vous l'avez peut-être remarqué lorsque vous prenez une photo sur votre iPhone 14 (ou iPhone 13) et que vous appuyez immédiatement sur la vignette dans le coin pour afficher les images que vous venez de prendre. L'image ressemblera à ce que vous avez capturé pendant une seconde rapide, mais elle semblera alors trop nette – avec des couleurs apparaissant plus artificielles, peut-être délavées dans certaines zones et trop saturées dans d'autres. Même le teint de la peau peut sembler un peu différent de ce que vous voyez dans la vraie vie. Alors que j'adorais le mode nuit lors de ses débuts sur la série iPhone 11 , par rapport à la concurrence actuelle, le mode nuit rend les photos trop "lumineuses" à cause du surtraitement, et beaucoup de photos de nuit ne semblent même pas avoir été prises à nuit.

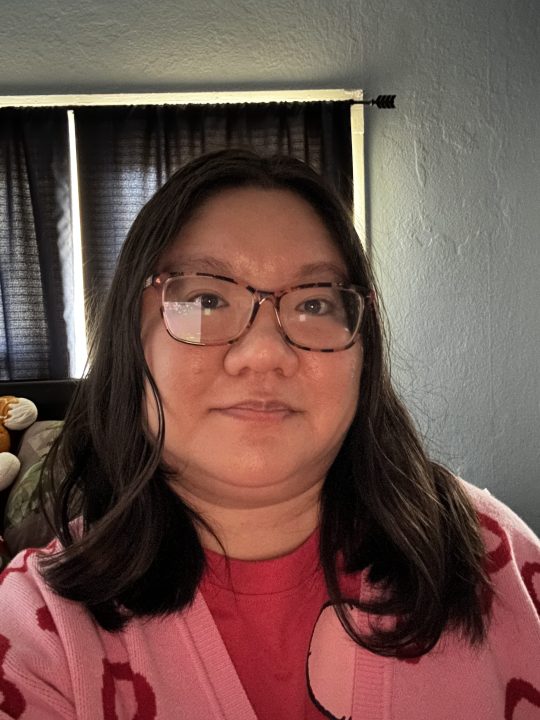

Et avez-vous déjà essayé de prendre un selfie dans des conditions de faible luminosité ? Bien sûr, l'iPhone dispose également d'un mode nuit pour la caméra frontale, mais je ne l'ai pas trouvé très utile. Les selfies en basse lumière ont l'air horribles, peu importe ce que vous faites, car iOS ajoute de nombreux artefacts numériques à l'image pour essayer de la "sauvegarder". Mais au lieu d'enregistrer la photo, elle finit par ressembler à une aquarelle mauvaise et désordonnée. En fait, j'essaie de ne pas prendre de selfies sur mon iPhone 14 Pro lorsque je suis dans un environnement sombre car ils finissent presque toujours par avoir l'air mauvais.

Je ne sais pas quand les photos prises avec un iPhone ont commencé à ressembler à cela, mais j'ai vraiment l'impression que cela est devenu plus important à partir de la série iPhone 13. Je peux me tromper, mais je ne me souviens pas particulièrement des images de mon iPhone 12 Pro aussi exagérées, et surtout pas de mes photos de l'iPhone 11 Pro. L'iPhone avait l'habitude de prendre des photos qui semblaient réalistes et naturelles, mais tout ce post-traitement intelligent HDR et de photographie informatique est devenu incontrôlable, rendant les images pires qu'elles ne devraient l'être.

Apple, éteignons ce truc

Il y a quelques années, il était possible de ne pas utiliser du tout le Smart HDR. Il s'agissait d'un paramètre facultatif que vous pouviez activer ou désactiver à votre guise. Ce paramètre n'était disponible que sur les modèles iPhone XS, iPhone XR, iPhone 11, iPhone SE 2 et iPhone 12. Depuis l'iPhone 13 et les versions ultérieures, l'option d'activation du Smart HDR a été supprimée.

Supprimer cette option était une décision à courte vue, et j'espère qu'Apple la ramènera à un moment donné. Bien que mon iPhone 14 Pro soit mon appareil personnel et principal, en particulier pour la photographie, j'ai parfois besoin de modifier une image avant de la considérer comme pouvant être partagée avec d'autres. Je comprends ce qu'Apple essaie de faire avec Smart HDR, mais l'image résultante semble généralement bien trop artificielle par rapport à ce que vous voyez en réalité.

Par exemple, lorsque je prends des photos à l'extérieur dans des conditions ensoleillées, la photo peut avoir un ciel bleu trop saturé, ce qui la rend fausse. Je pense aussi que, parfois, la modification de la couleur rend mon teint un peu décalé – quelque chose dont YouTuber Marques Brownlee (MKBHD) parle même dans une vidéo récente .

La concurrence Android fait mieux

Encore une fois, Apple a mis du bon matériel photo dans la gamme iPhone 14 Pro, mais il est entaché par le surtraitement du logiciel. Comme j'ai acheté quelques appareils Android différents au cours de mon séjour chez Digital Trends, j'en suis venu à apprécier la façon dont certains téléphones Android concurrents gèrent la photographie sur l'iPhone.

Par exemple, le Google Pixel 7 prend de superbes photos avec l'appareil photo principal sans effort supplémentaire. Il vous suffit de viser et de déclencher, et les résultats sont fidèles à ce que vos yeux voient, voire meilleurs. Google utilise toujours une grande partie de son propre traitement d'image, mais il ne rend pas les photos non naturelles comme le fait Apple. Le seul problème, d'après ce que j'ai remarqué, ce sont les selfies. Il n'obtient pas tout à fait le teint de la peau avec précision, mais sinon, l'appareil photo principal est génial. Les couleurs sont équilibrées, non délavées, et le logiciel n'essaie pas trop de le rendre "beau", car il l'est déjà. Et avec des outils amusants comme Magic Eraser , je préfère utiliser mon Google Pixel 7 pour retoucher les clichés.

J'ai également testé l'ancien Samsung Galaxy S21 pour quelques-unes de ces comparaisons de photos, et bien que je ne pense pas qu'il gère aussi bien le teint et la couleur de la peau, il semble bien fonctionner pour les selfies à faible luminosité, ce qui me surprend. Il a également très bien géré les images en mode nuit, les rendant naturelles et réalistes au lieu d'être soufflées avec les couleurs comme l'iPhone 14 Pro.

Ainsi, alors qu'Apple peut dire qu'il dispose du "meilleur" matériel photo, iOS et la dépendance excessive à l'égard de la photographie informatique ruinent l'apparence des images. Bien sûr, certaines personnes peuvent aimer cette esthétique, mais personnellement, je ne supporte pas à quel point beaucoup de mes photos finissent par paraître non naturelles. Apple doit atténuer les éléments Smart HDR, ou au moins ramener l'option de le désactiver s'il nous plaît. Parce qu'en ce moment, les choses ne vont pas très bien.