OpenAI change le monde en 26 minutes ! La version gratuite de GPT-4 est là, l’interaction vidéo-vocale avance rapidement vers un film de science-fiction

Tôt ce matin, une conférence de presse de 26 minutes changera une fois de plus considérablement l'industrie de l'IA et nos vies futures, et rendra également misérables d'innombrables startups d'IA.

Ce n’est vraiment pas un titre, car il s’agit d’une conférence de presse OpenAI.

Tout à l'heure, OpenAI a officiellement publié GPT-4o, où le « o » signifie « omni » (ce qui signifie complet et omnipotent). Ce modèle a les capacités de texte, d'images, de vidéo et de voix. C'est même le GPT-5 An. version inachevée.

De plus, ce modèle de niveau GPT-4 sera disponible gratuitement pour tous les utilisateurs et sera déployé sur ChatGPT Plus dans les semaines à venir.

Résumons d’abord les points forts de cette conférence. Veuillez lire ci-dessous pour une analyse plus fonctionnelle.

Points clés de la conférence de presse

- Nouveau modèle GPT-4o : ouvrez n'importe quelle entrée de texte, d'audio et d'image, et pouvez les générer directement sans conversion intermédiaire

- GPT-4o a considérablement réduit la latence vocale et peut répondre à une entrée audio en 232 millisecondes, avec une moyenne de 320 millisecondes, ce qui est similaire aux temps de réponse humains dans les conversations.

- GPT-4 est gratuit et ouvert à tous les utilisateurs

- API GPT-4o, 2 fois plus rapide que GPT4-turbo et 50% moins cher

- Superbe démonstration d'assistant vocal en temps réel : la conversation ressemble plus à celle d'un humain, peut traduire en temps réel, reconnaître les expressions et reconnaître l'écran via la caméra, écrire du code et analyser des graphiques

- Nouvelle interface utilisateur de ChatGPT, plus concise

- Une nouvelle application de bureau ChatGPT pour macOS, avec une version Windows à venir plus tard cette année

Ces caractéristiques ont été décrites par Altman comme « un sentiment de magie » dès la phase d'échauffement. Étant donné que les modèles d'IA du monde entier « rattrapent GPT-4 », OpenAI doit retirer de véritables éléments de son arsenal.

GPT-4o gratuit et disponible est ici, mais ce n'est pas son plus gros point fort

En fait, la veille de la conférence de presse, nous avons découvert qu'OpenAI avait discrètement modifié la description de GPT-4 de « le modèle le plus avancé » à « avancé ».

Il s’agit de saluer l’arrivée de GPT-4o. La puissance de GPT-4o est qu'il peut accepter n'importe quelle combinaison de texte, d'audio et d'images en entrée et générer directement la sortie multimédia ci-dessus.

Cela signifie que l’interaction homme-machine sera plus proche de la communication naturelle entre les personnes.

GPT-4o peut répondre à une entrée audio en 232 millisecondes, avec une moyenne de 320 millisecondes, ce qui est proche du temps de réaction d'une conversation humaine. Auparavant, lorsque vous utilisiez le mode vocal pour communiquer avec ChatGPT, la latence moyenne était de 2,8 secondes (GPT-3,5) et de 5,4 secondes (GPT-4).

Il correspond aux performances de GPT-4 Turbo sur l'anglais et le texte codé, avec des améliorations significatives sur le texte en langue autre que l'anglais, tout en étant plus rapide et 50 % moins cher sur l'API.

Par rapport aux modèles existants, GPT-4o est particulièrement performant en matière de compréhension visuelle et audio.

- Vous pouvez interrompre à tout moment pendant une conversation

- Peut générer une variété de tons en fonction de la scène, avec des humeurs et des émotions semblables à celles des humains.

- Passez directement un appel vidéo avec l'IA et laissez-la répondre à diverses questions en ligne

À en juger par les paramètres de test, les principales capacités de GPT-4o sont fondamentalement au même niveau que GPT-4 Turbo, l'OpenAI le plus puissant actuellement.

[image]

[image]

[image]

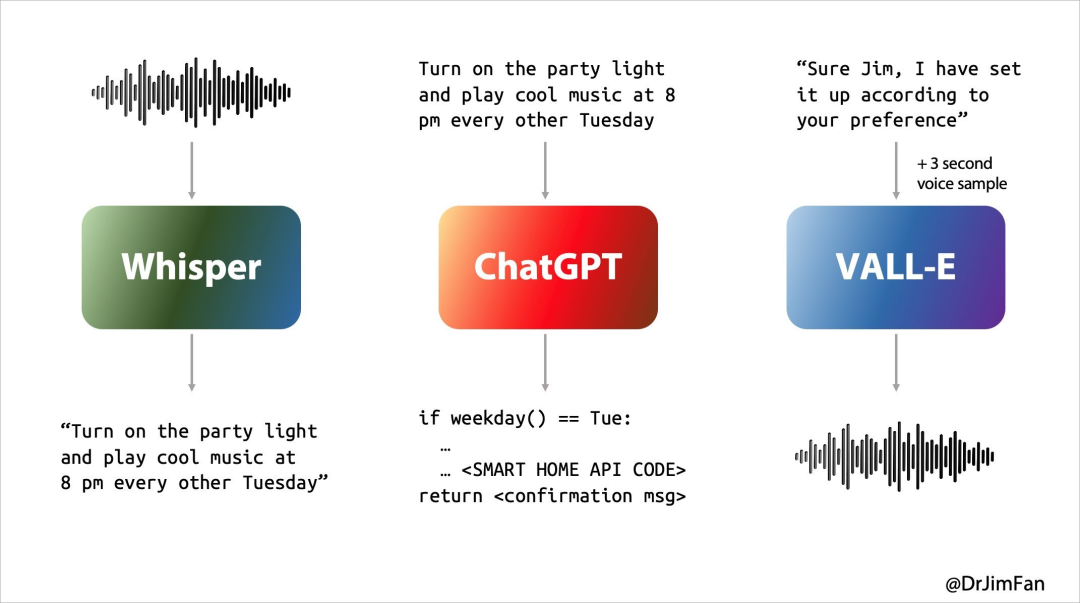

Dans le passé, notre expérience avec Siri ou d’autres assistants vocaux n’était pas idéale. Essentiellement, la conversation avec l’assistant vocal passait par trois étapes :

- Reconnaissance vocale ou « ASR » : audio -> texte, similaire à Whisper ;

- LLM planifie quoi dire ensuite : Texte 1 -> Texte 2 ;

- Synthèse vocale ou « TTS » : Texte 2 -> Audio, pensez à ElevenLabs ou VALL-E.

Cependant, nos conversations naturelles quotidiennes ressemblent essentiellement à ceci.

- Pensez à ce que vous direz ensuite pendant que vous écoutez et parlez ;

- Insérez « ouais, euh, euh » au moment approprié ;

- Anticipez le moment où votre interlocuteur aura fini de parler et prenez immédiatement le relais ;

- Décider d'interrompre la conversation de l'autre personne de manière naturelle et sans provoquer de ressentiment ;

- Pensez à ce que vous direz ensuite pendant que vous écoutez et parlez ;

- Insérez « ouais, euh, euh » au moment approprié ;

- Gérez et interrompez avec élégance.

Les assistants linguistiques IA précédents ne parvenaient pas à bien gérer ces problèmes et il y avait un retard important dans chacune des trois étapes de la conversation, ce qui se traduisait par une mauvaise expérience. Dans le même temps, de nombreuses informations sont perdues au cours du processus, comme l'incapacité d'observer directement l'intonation, plusieurs locuteurs ou le bruit de fond, et l'incapacité de faire rire, chanter ou exprimer des émotions.

Lorsque l’audio peut générer directement du son, des images, du texte et des vidéos, l’expérience entière sera à pas de géant.

GPT-4o est un tout nouveau modèle formé par OpenAI à cet effet. La conversion directe entre texte, vidéo et audio nécessite que toutes les entrées et sorties soient traitées par le même réseau neuronal.

Ce qui est encore plus surprenant, c'est que les utilisateurs gratuits de ChatGPT peuvent utiliser GPT-4o pour découvrir les fonctions suivantes :

- Découvrez l'intelligence de niveau GPT-4

- Obtenez des réponses des modèles et des réseaux

- Analyser les données et créer des graphiques

- Parlons des photos que vous avez prises

- Téléchargez un fichier pour obtenir de l'aide pour un résumé, la rédaction ou l'analyse

- Utilisation des GPT et du GPT Store

- Créez des expériences plus utiles avec Memory

Et lorsque vous regardez les démonstrations suivantes de GPT-4o, vos sentiments peuvent être plus compliqués.

ChatGPT version "Jarvis", tout le monde l'a

ChatGPT peut non seulement parler, écouter, mais aussi regarder. Ce n'est pas nouveau, mais la « nouvelle version » de ChatGPT m'a quand même surpris.

partenaire endormi

En prenant une scène de vie spécifique comme exemple, laissez ChatGPT raconter une histoire au coucher sur les robots et l'amour. Il peut raconter une histoire émotionnelle et dramatique au coucher sans trop réfléchir.

Il peut même raconter des histoires sous forme de chant, qui peuvent servir de compagnon de sommeil aux utilisateurs.

Meneur de jeu

Ou, lors de la conférence de presse, laissez-le vous montrer comment résoudre l'équation linéaire 3X+1=4. Il peut vous guider étape par étape et vous donner la bonne réponse.

Bien sûr, ce qui précède est encore un peu un « jeu d'enfant », et les difficultés de codage sur site sont le véritable test. Cependant, il peut être facilement résolu avec trois frappes, cinq frappes et deux frappes.

Avec la « vision » de ChatGPT, il peut tout voir sur l'écran de l'ordinateur, comme interagir avec la base de code et visualiser les graphiques générés par le code, hein, quelque chose ne va pas ? Alors notre vie privée ne sera-t-elle pas clairement visible à l’avenir ?

traduction en temps réel

Le public présent sur les lieux a également posé des questions délicates à ChatGPT.

Traduire de l'anglais vers l'italien et de l'italien vers l'anglais, peu importe combien vous utilisez cet assistant vocal AI, il peut le faire facilement. Il semble qu'il n'y ait pas besoin de dépenser beaucoup d'argent pour acheter un traducteur. à l'avenir, peut-être que ChatGPT sera meilleur que votre temps réel. Le traducteur est assez fiable.

Ce contenu ne peut pas être affiché en dehors des documents Feishu pour le moment.

▲ Traduction en temps réel (cas du site officiel)

Percevoir l'émotion du langage n'est que la première étape. ChatGPT peut également interpréter les émotions faciales humaines.

Lors de la conférence de presse, ChatGPT a directement confondu le visage capturé par la caméra avec une table. Juste au moment où tout le monde pensait qu'il allait se retourner, il s'est avéré que c'était parce que la caméra frontale allumée en premier était dirigée vers la table. .

Cependant, en fin de compte, il a décrit avec précision les émotions sur le visage dans le selfie et a identifié avec précision le sourire « éclatant » sur le visage.

Fait intéressant, à la fin de la conférence de presse, le porte-parole n'a pas oublié le « fort soutien » de Cue de la part de Nvidia et de son fondateur Lao Huang. Il comprend vraiment la nature humaine.

L'idée d'une interface de langage conversationnel était incroyablement prophétique.

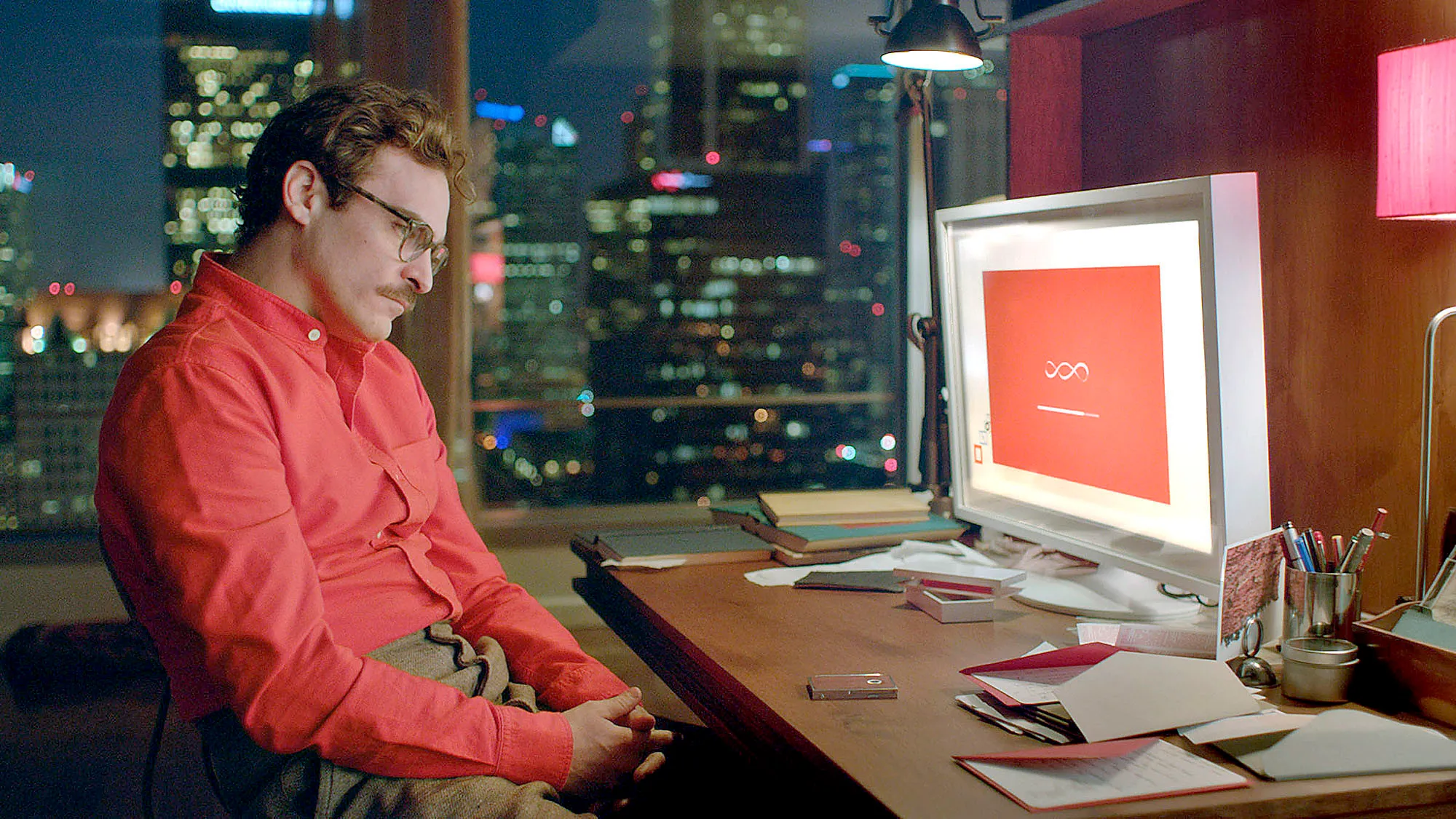

Altman a exprimé dans des interviews précédentes qu'il espérait développer à terme un assistant d'IA similaire à celui du film d'IA "Her", et l'assistant vocal publié aujourd'hui par OpenAI devient effectivement réalité.

Brad Lightcap, directeur des opérations d'OpenAI, a prédit il n'y a pas si longtemps qu'à l'avenir, nous parlerions aux chatbots IA de la même manière que nous parlons aux humains, en les traitant comme faisant partie d'une équipe.

Il semble aujourd’hui que cela ait non seulement ouvert la voie à la conférence d’aujourd’hui, mais qu’il constitue également une note marquante pour nos vies des dix prochaines années.

Apple est aux prises avec les assistants vocaux IA depuis treize ans et n'a pas réussi à sortir du labyrinthe, mais OpenAI a trouvé la sortie du jour au lendemain. Il est prévisible que dans un avenir proche, le « Jarvis » d’Iron Man ne sera plus un fantasme.

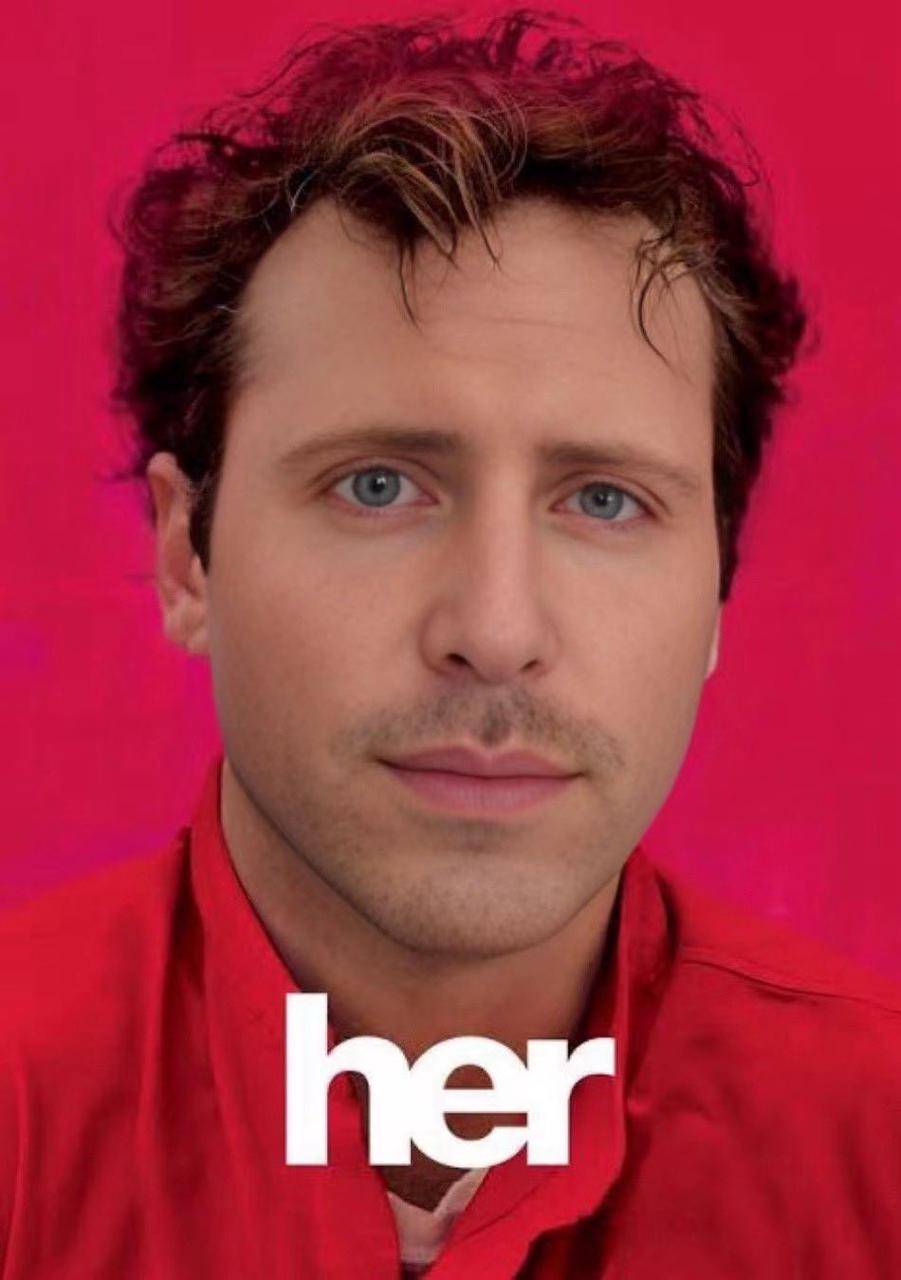

"Elle vient

Bien que Sam Altman ne soit pas apparu à la conférence, il a publié un blog après la conférence et posté un mot sur X : elle.

Il s'agit évidemment d'une allusion au film classique de science-fiction "Her" du même nom. C'est la première image qui m'est venue à l'esprit en visionnant la présentation de cette conférence.

Samantha dans le film "Elle" n'est pas seulement un produit, elle comprend même mieux les humains que les humains et ressemble davantage aux humains eux-mêmes. Vous pouvez vraiment progressivement oublier qu'elle est une IA lorsqu'elle communique avec elle.

Cela signifie que le modèle d’interaction homme-machine pourrait ouvrir la voie à une mise à jour véritablement révolutionnaire après l’interface graphique, comme l’a dit Sam Altman sur son blog :

Les nouveaux modes voix (et vidéo) constituent la meilleure interface informatique que j'ai jamais utilisée. Cela ressemble à une IA d'un film ; et je suis toujours un peu surpris que ce soit réel. Atteindre des temps de réponse et une expressivité au niveau humain s’avère être un grand changement.

Le précédent ChatGPT nous a permis de voir les débuts de l’interface utilisateur naturelle : la simplicité avant tout : la complexité est l’ennemie de l’interface utilisateur naturelle. Chaque interaction doit être explicite et ne nécessiter aucun manuel d’instructions.

Mais le GPT-4o lancé aujourd'hui est complètement différent. Il n'a presque aucun délai de réponse, est intelligent, intéressant et pratique. Notre interaction avec les ordinateurs n'a jamais vraiment connu une interaction aussi naturelle et fluide.

Il y a encore d'énormes possibilités cachées ici. Lorsque des fonctions plus personnalisées et une collaboration avec différents terminaux sont prises en charge, cela signifie que nous pouvons utiliser les téléphones mobiles, les ordinateurs, les lunettes intelligentes et autres terminaux informatiques pour faire beaucoup de choses qui n'étaient pas possibles auparavant.

Le matériel d'IA n'essaiera plus de s'accumuler. Ce qui est plus excitant maintenant, c'est que si Apple annonce officiellement sa coopération avec OpenAI à la WWDC le mois prochain, l'expérience iPhone pourrait être améliorée plus que n'importe quelle conférence de ces dernières années.

Jim Fan, scientifique principal du code chez NVIDIA, estime que la coopération entre iOS 18, connue comme la plus grande mise à jour de l'histoire, et OpenAI pourrait avoir trois niveaux :

- En abandonnant Siri, OpenAI a affiné un petit GPT-4o pour iOS qui fonctionne uniquement sur l'appareil, avec la possibilité de payer pour mettre à niveau afin d'utiliser les services cloud.

- La fonctionnalité native alimente les flux de caméra ou d’écran dans le modèle. Prise en charge au niveau de la puce des codecs audio et vidéo neuronaux.

- Intégrez l'API d'exploitation au niveau du système iOS et l'API de maison intelligente. Personne n'utilise les raccourcis Siri, mais il est temps de faire un renouveau. Cela pourrait devenir un produit d’agent d’IA avec un milliard d’utilisateurs dès le départ. C’est comme un volant de données grandeur nature de type Tesla pour smartphones.

En parlant de ça, je dois avoir pitié de Google, qui tiendra une conférence de presse demain.

Auteurs : Li Chaofan et Mo Chongyu

# Bienvenue pour suivre le compte public officiel WeChat d'aifaner : aifaner (ID WeChat : ifanr). Un contenu plus passionnant vous sera fourni dès que possible.

Ai Faner | Lien original · Voir les commentaires · Sina Weibo