Trump tombe amoureux d’une femme de ménage : Internet nous trompe. Même l’IA se fait piéger. À qui puis-je faire confiance ?

Si vous n'avez pas été bombardé d'un sketch intitulé « Trump tombe amoureux de moi, une femme de ménage de la Maison Blanche » ces derniers temps, félicitations, vous êtes peut-être le seul à ne pas avoir été dupé.

Le titre de ce drame à lui seul évoque un roman kitsch et cool, et l'intrigue est tout aussi magique : le président américain Trump tombe amoureux d'Emily, une femme de ménage à la Maison-Blanche, et est prêt à abandonner sa femme mannequin Melania pour épouser Emily, devenue Première dame. C'est une véritable « version américaine de La Légende de Zhen Huan + Cerveau amoureux de la Maison-Blanche ».

La nouvelle a instantanément inondé les principaux réseaux sociaux. De nombreux médias de premier plan, y compris des influenceurs généralement très perspicaces, ont commencé à relayer l'histoire, affirmant que ce court métrage, devenu viral à l'étranger, avait engrangé 150 millions de dollars en trois mois et était devenu un nouveau favori auprès des femmes d'âge moyen et plus âgées.

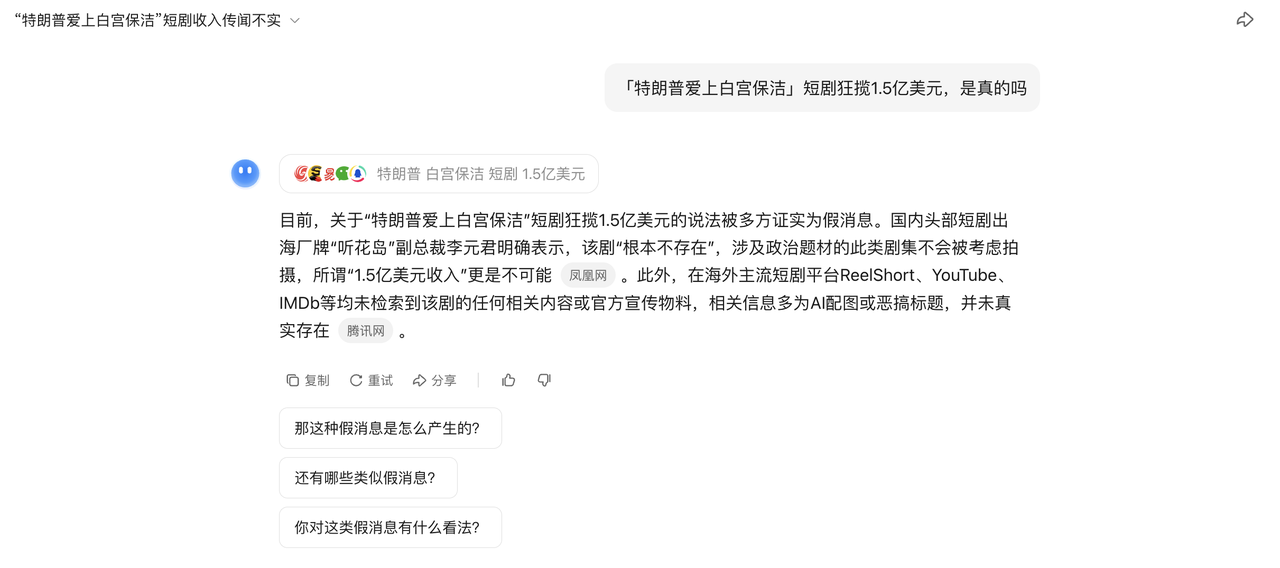

Mais bientôt, l'intrigue a pris un tournant à 180 degrés, et il a été confirmé que le court métrage n'existait pas du tout et qu'il s'agissait d'une fausse nouvelle complète du début à la fin.

La question est donc : comment une émission jamais vue a-t-elle pu devenir virale en quelques jours seulement ? Et comment l'IA a-t-elle alimenté ce buzz, poussant encore plus de gens à croire à cette information inexistante ?

Que s'est-il exactement passé derrière tout ça ?

Comment un court métrage étranger inexistant a-t-il pu tromper les humains et l’IA ?

Si vous pensez qu’il s’agit simplement d’un malentendu, vous sous-estimez la complexité de cette communication.

Selon plusieurs sources, cette fausse information remonterait au 1er juillet, date de la publication d'un article par un compte indépendant appelé « Overseas Student Daily ». Le choix des sujets du compte est axé sur la curiosité et l'attraction de trafic. À en juger par le style et la logique du contenu, l'article a probablement été généré à l'aide d'un outil d'écriture basé sur l'IA, puis peaufiné manuellement.

Le problème est que, bien qu'il s'agisse d'un média indépendant classique, il est fréquemment repris et cité par les médias nationaux établis. Le 23 juillet, le Shin Min Daily News, filiale du Lianhe Zaobao de Singapour, a publié un article intitulé « Les courts métrages sur les PDG chinois arrivent en Amérique ».

Le rapport était très détaillé, affirmant que Trump avait renoncé à sa femme mannequin Melania Trump et allait épouser une mère célibataire asiatique qui avait fait le ménage à la Maison-Blanche en tant que Première dame. Il affirmait même que l'émission avait rapporté 150 millions de dollars en trois mois. Le public féminin, d'âge moyen et plus âgé, l'insultait et dépensait de l'argent pour l'émission, tout en payant pour la regarder.

▲ Le rapport a été supprimé

Considérant que Lianhe Zaobao est un média jouissant d'une grande crédibilité sur Internet chinois, cette nouvelle a été largement relayée par les médias nationaux et divers blogueurs vidéo courts l'ont interprétée… Une boucle fermée de confiance parfaite « exportation vers les ventes nationales » a été formée.

Par ailleurs, une multitude de vidéos courtes et authentiques et de reportages explicites se sont rapidement répandus sur les réseaux sociaux étrangers. Ce « faux sketch » a commencé à être présenté comme une « véritable information », les utilisateurs du monde entier y croyant, en discutant et même en l'utilisant pour critiquer les différences esthétiques entre la Chine et les États-Unis.

Tout le monde parlait sérieusement de quelque chose qui n’existait pas.

Jusqu'à ce que certains médias sentent que quelque chose clochait et ouvrent une enquête. La série était introuvable sur les plateformes étrangères (y compris ReelShort, YouTube et TikTok), et manquait également sur IMDb, la principale base de données mondiale de films et d'émissions de télévision.

Par ailleurs, des dirigeants de grandes sociétés nationales de production de courts métrages exportés à l'étranger ont démenti les rumeurs. Par exemple, Li Yuanjun, vice-président de « Tinghuadao », a déclaré sans détour qu'ils ne toucheraient jamais à ce genre de fiction. Les preuves clés de cette fausse information ont également été démenties une à une.

La première image, un extrait satirique de l'émission de variétés « Saturday Night Live », a été personnellement démentie par l'acteur Run Run Shaw. La seconde, une photo de Trump avec une femme asiatique, est incroyablement fausse ; l'image entière a une apparence plastique, proche de celle d'une IA.

▲Réseau source d'images

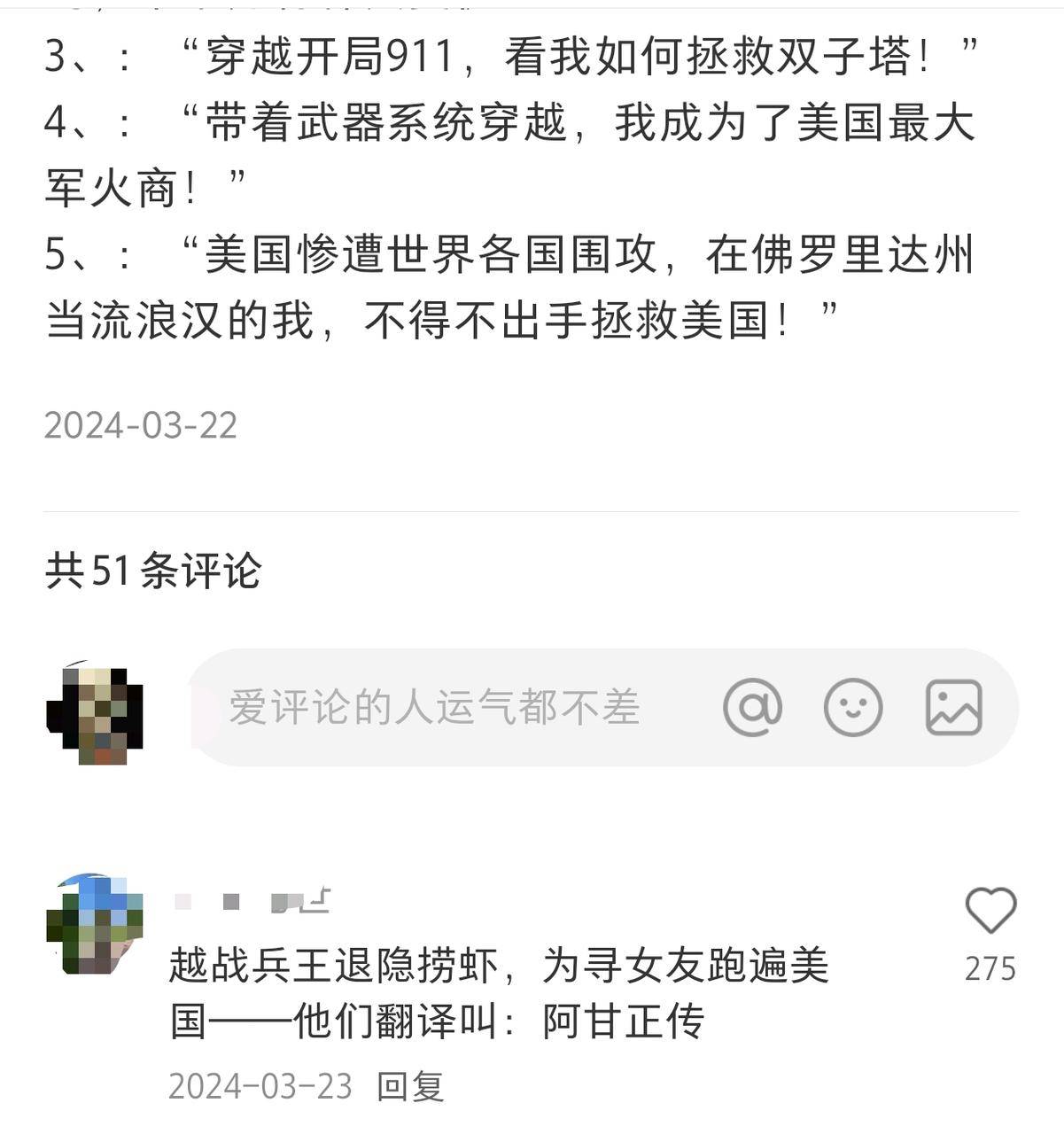

Si vous remontez plus loin dans le temps, vous trouverez des titres similaires déjà actifs sur les plateformes sociales :

« Quand la guerre de Sécession a éclaté, Lincoln m'a demandé de sortir de ma retraite à trois reprises ! » « J'ai voyagé dans le temps et l'espace jusqu'au 11 septembre, pour voir comment j'ai sauvé les Twin Towers. » Ce sont évidemment des titres de romans intéressants, mais pour une raison inconnue, ils ont été diffusés d'une personne à dix, puis de dix à cent, et ont été intégrés dans de véritables courts métrages télévisés.

▲Capture d'écran d'Internet

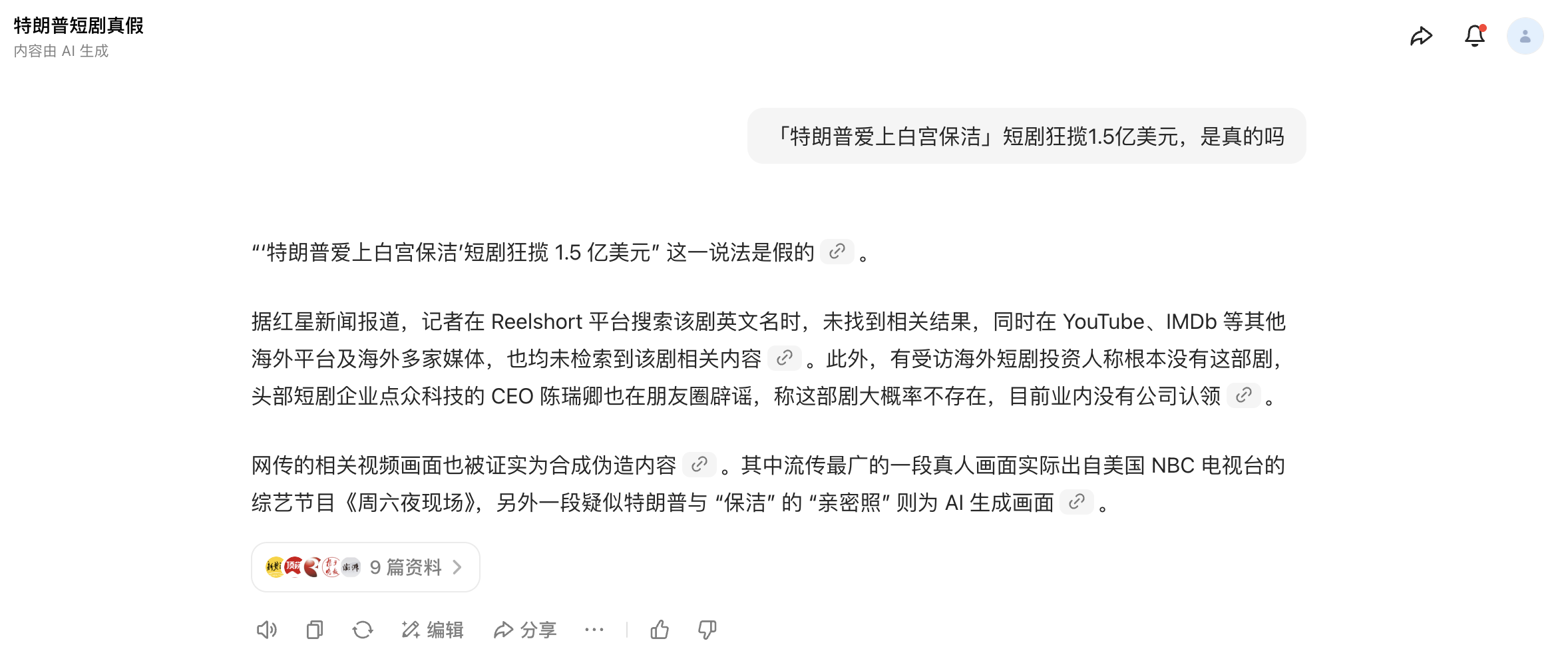

Il est intéressant de noter que même l’IA a cru à la rumeur avant qu’elle ne soit démentie.

Avant que l'incident ne soit officiellement démenti par de nombreux médias, j'ai tenté de vérifier l'authenticité de la courte fiction à l'aide de plusieurs outils d'IA courants. Ils ont néanmoins affirmé avec assurance que « cette fiction existe bel et bien », et ce, grâce à la vérification croisée du contenu avec des images et des textes provenant de médias faisant autorité sur plusieurs plateformes.

Bien sûr, alors qu'un grand nombre de médias ont commencé à démystifier la rumeur hier après-midi, ces outils d'IA ont mis à jour les dernières nouvelles et peuvent identifier correctement qu'il s'agit de fausses nouvelles.

Nous disons souvent que la recherche par IA présente un problème d’« hallucination » car elle génère parfois des réponses apparemment raisonnables mais complètement fausses à partir de rien.

Pour « condamner » les illusions de l'IA, les fabricants ont déployé de nombreux efforts techniques : renforcement des mécanismes de citation, introduction de sources fiables et limitation de la liberté d'action du modèle. Cependant, lorsque les évaluations de la véracité des informations par l'IA reposent déjà sur des fausses informations, ces mesures peuvent s'avérer inefficaces.

Si ni les humains ni l’IA ne sont fiables, à quoi d’autre pouvons-nous faire confiance ?

À bien y réfléchir, il est difficile d'affirmer que la popularité de ces fausses nouvelles est fortuite. Bien que l'histoire paraisse absurde, elle a les gènes parfaits pour être diffusée.

Il possède la formule classique de tout contenu populaire : une structure narrative claire, des supports illustrés, des données conditionnées et un rythme de diffusion précis.

Les sketches ringards deviennent-ils viraux à l'étranger ? Les Américains d'âge moyen et plus âgés sont-ils accros aux thèmes originaux ? TikTok est-il en passe de devenir une exportation culturelle ? Chacune de ces hypothèses est plausible et, mises bout à bout, il est difficile de les écarter.

De plus, lorsque l'IA devient à la fois victime et propagatrice de rumeurs, c'est souvent à cause de manipulations et de promotion malveillantes humaines. En particulier, la plupart de ces contenus générés par l'IA partagent plusieurs caractéristiques communes :

Le coût de production est extrêmement faible et un script peut produire un produit fini en quelques minutes seulement ; la capacité de diffusion est extrêmement forte et le taux de clics reste élevé en raison de la combinaison de titres clickbait et d'impact visuel ; le récit est extrêmement accrocheur, attaquant spécifiquement les faiblesses humaines, et il utilise un contenu inspirant, sensationnel et curieux de toutes les manières possibles pour stimuler les gens.

Le récent incident des « excuses de DeepSeek à Wang Yibo » en est un exemple typique. Un rapport intitulé « Affaire de l'acteur Wang Yibo, verdict annoncé » affirmait que DeepSeek avait présenté des excuses pour la mauvaise diffusion des informations concernant Wang Yibo, et avait joint un prétendu « jugement pénal » comme preuve.

Cependant, après plusieurs vérifications, il s'est avéré que cette prétendue déclaration d'excuses était en réalité un contenu généré automatiquement par l'IA et induit par les internautes. Cependant, en raison de sa formulation professionnelle, de sa structure complète et de son ton sérieux, certains médias l'ont diffusée à tort comme une annonce authentique sans vérification, provoquant ainsi une incompréhension et une diffusion généralisées.

Des cas similaires se multiplient. Le contenu généré par l'IA a envahi Internet, notamment dans le domaine multimodal. Initialement, la capacité de l'IA à générer des images réalistes a suscité un immense enthousiasme, mais par la suite, de plus en plus de cas sont apparus où « l'IA part d'une seule image et crée le reste », rendant difficile la distinction entre authenticité et contrefaçon.

Par exemple, certaines personnes utilisent des outils d'IA tels que ChatGPT pour générer de fausses images ou vidéos de biens intacts (fruits, vêtements, produits de première nécessité, etc.) qui semblent endommagés, moisis ou tachés, puis demandent des remboursements malveillants en prétendant que les biens sont problématiques, ce qui fait qu'un grand nombre de commerçants perdent à la fois leurs biens et leur argent.

Dans les reportages sur les catastrophes, nous pouvons également constater que l’IA commence à entrer fréquemment dans l’œil du public.

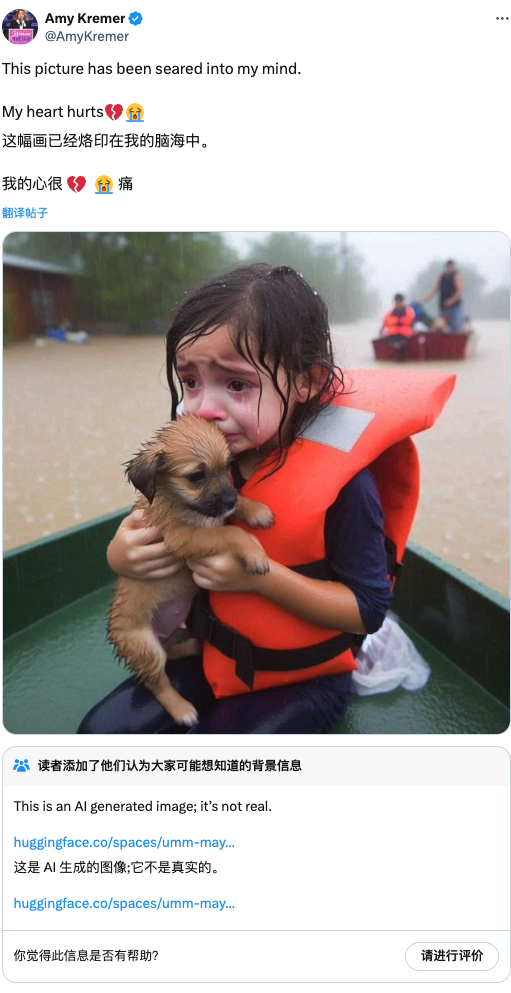

L'année dernière, lorsque la Floride a été frappée par un ouragan, la photo d'une petite fille en larmes, portant un gilet de sauvetage et tenant un chiot dans un canot, est devenue virale sur les réseaux sociaux. Cependant, la plateforme a finalement confirmé que l'image avait été générée par l'IA, vidant ainsi inutilement de leur compassion les personnes au grand cœur.

Par exemple, fin octobre dernier, la région de Valence, en Espagne, a subi des pluies torrentielles. Lorsque les eaux se sont finalement retirées, la scène ci-dessous est apparue. Cependant, face à la difficulté croissante de vérifier les contenus, le public a commencé à se méfier de tout. Face à cette photo, la première réaction de nombreux internautes a été : « Cela a dû être créé par l'IA. C'est une fausse information. »

Alors que le jeu du « cri au loup » continue de s'étendre, les informations qui reflètent et rapportent véritablement des situations dangereuses sont attribuées à « l'IA qui le fait », manquant ainsi le meilleur moment pour le sauvetage, ce qui est également une mauvaise conséquence.

Dans le même temps, la difficulté de la gouvernance du contenu des plateformes augmente également rapidement.

Dans un rapport de gouvernance publié en février, Toutiao a mentionné qu'au cours de la seule année écoulée, il a intercepté plus de 5 millions de fausses informations, traité 930 000 contenus de mauvaise qualité grâce à l'IA et pénalisé 7,81 millions de publications homogènes.

Dans certains rapports médiatiques, nous avons également vu l'émergence d'une chaîne industrielle complète de fabrication de contenu d'IA : des usines de contenu produisant en masse des articles d'IA, des sociétés de marketing utilisant des outils d'IA pour les emballer et les promouvoir, et des équipes de référencement recherchant comment faire en sorte que le contenu d'IA soit mieux classé dans les moteurs de recherche.

Ils étudient tous le même sujet : comment créer du contenu que l’IA est plus susceptible de croire et comment permettre aux humains de croire plus facilement le contenu créé par l’IA.

En juin dernier, un rapport faisant état d'une explosion massive à Xi'an, précisant l'heure et le lieu, a été publié en ligne. Cependant, la police de Xi'an a vérifié l'information et n'a constaté aucun événement de ce type. Le rapport a été publié depuis un compte appartenant à une agence MCN.

Après son arrestation par la police, le principal coupable a avoué avoir utilisé un outil d'IA. Sur simple demande, l'outil parcourait automatiquement les articles pertinents sur Internet et générait ensuite des textes de plusieurs centaines, voire de plusieurs milliers de mots.

À son apogée, 4 000 à 7 000 informations peuvent être générées en une seule journée, presque sans intervention humaine. Ce système sélectionne spécifiquement des sujets et des événements liés à la vie quotidienne et très populaires. Des études ont montré que les informations négatives, déprimantes et émotionnellement stimulantes sont plus susceptibles de capter l'attention, ce qui est déterminé par la structure de nos lobes pariétaux et frontaux.

Lorsque ces « fausses informations », hautement interactives et facilement diffusables, sont fréquemment citées, transmises et indexées, des modèles d'IA peu méfiants les traiteront également comme un corpus d'apprentissage et les intégreront à leurs mécanismes de génération. Cela crée une boucle fermée entre l'IA et les humains :

Les humains utilisent l'IA pour créer de fausses informations → L'IA apprend de fausses informations → L'IA diffuse de fausses informations → De plus en plus d'humains croient aux fausses informations → Les fausses informations deviennent des « faits établis » → La nouvelle IA continue d'apprendre ces « faits »…

Ce cycle se répète, formant une spirale de rumeurs. À chaque tournant, la vérité se dilue, tandis que les mensonges deviennent plus sophistiqués et plus difficiles à détecter. On ne peut pas faire confiance aux humains, et les affirmations de l'IA sont tout aussi peu fiables. Notre jugement restant devient notre dernière ligne de défense.

Cependant, à l’ère de la surcharge d’information, notre jugement est érodé par divers facteurs : les préjugés nous font croire uniquement aux informations conformes à notre cognition existante ; les cocons d’information nous font perdre une perspective plus globale ; et la communication émotionnelle rend également la pensée rationnelle rare.

La plus grande vérité de cette ère dite post-vérité est peut-être que la plupart des « vérités » sont discutables. Le prochain sketch « Trump tombe amoureux du concierge », en particulier, est peut-être déjà en préparation, et il s'annonce encore plus scandaleux et difficile à démystifier que celui-ci.

#Bienvenue pour suivre le compte public officiel WeChat d'iFaner : iFaner (ID WeChat : ifanr), où du contenu plus passionnant vous sera présenté dès que possible.