Surpassant Sora dans tous les aspects, quelle est la force du dernier modèle vidéo d’IA de Meta ?

Au cours des deux derniers jours, le domaine des modèles de génération vidéo a de nouveau explosé grâce à la sortie de Meta Movie Gen.

Les points les plus déplorés à l'intérieur et à l'extérieur de l'industrie ne sont que deux points. Premièrement, l'effet de génération est naturel et réaliste, et il peut également générer simultanément des sons qui correspondent à l'image. Il est très similaire à la discussion et à la sensation provoquée par l'image. sortie de Sora à ce moment-là ; deuxièmement, le nouveau modèle de Meta AI est automatiquement hautement définissable et le rapport de l'écran vidéo ainsi que les éléments et détails vidéo peuvent être ajustés en fonction des besoins de l'utilisateur.

Alors, quels sont les détails de Meta Movie Gen, qui pourrait mener une nouvelle révolution dans la génération vidéo ? Comment obtenir ces effets époustouflants sur le site officiel et les vidéos de démonstration ? Andrew Brown, responsable du modèle vidéo chez Meta AI, a spécifiquement expliqué la technologie théorique de Meta Movie Gen :

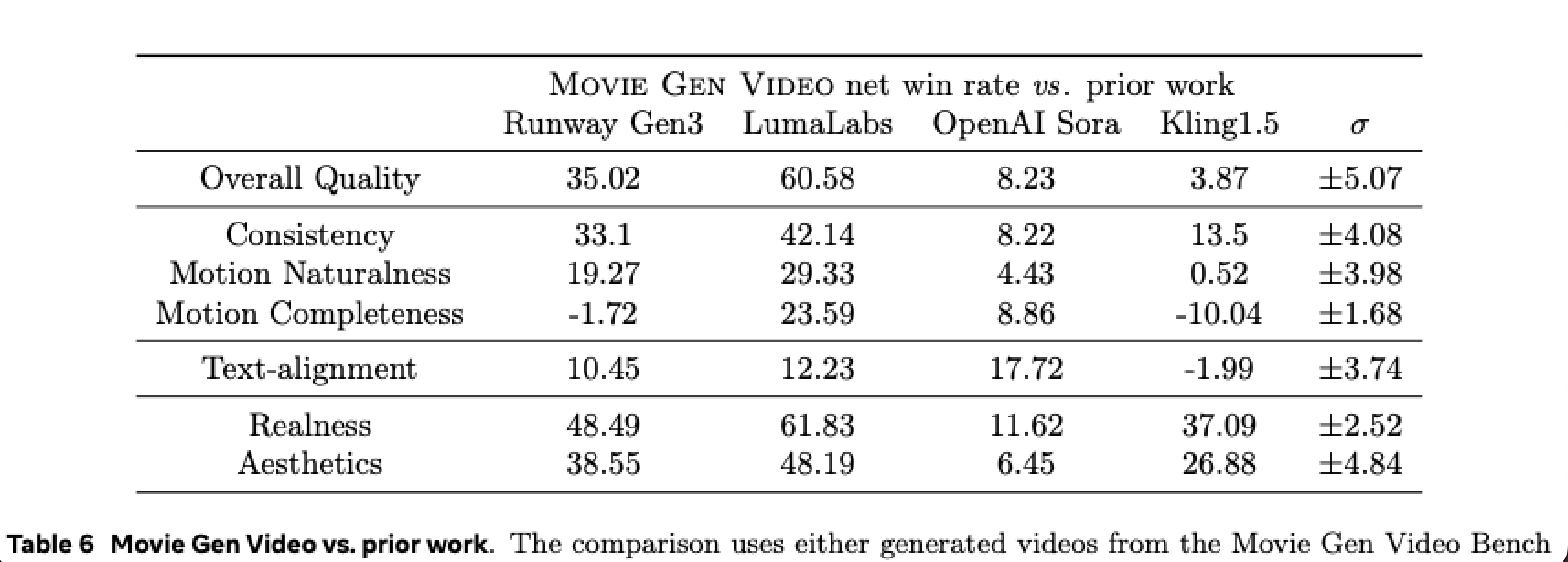

- Movie Gen est nettement meilleur que Sora en termes de qualité globale et de cohérence. L'authenticité et la beauté testent le réalisme photo, et Movie Gen gagne dans tous les domaines.

- Meta Movie Gen est un ensemble de modèles capables d'effectuer la génération de texte en vidéo, la génération de texte en image, la personnalisation, l'édition et la génération de vidéo en audio.

- Il est important d'étendre les paramètres de données, de calcul et de modèle, de combiner cela avec une correspondance de flux et de passer à une architecture LLM commune simple (Llama), obtenant ainsi une qualité de génération vidéo SOTA.

- Nous (Meta AI) sommes les premiers à utiliser Llama Arch pour la génération de médias.

- Movie Gen est un convertisseur paramétrique 30B qui génère une vidéo 1080p avec différents formats d'image et audio synchronisé, d'une durée maximale de 16 secondes (16 ips).

- Nous (Meta) proposons une solution de formation en plusieurs étapes pour le modèle T2V. Formation conjointe T2I + T2V, entraînant une convergence beaucoup plus lente et une moins bonne qualité.

- L’évaluation texte-vidéo est difficile. Les mesures automatisées sont très médiocres et ne correspondent pas bien aux évaluations humaines.

« super individu » généré par une vidéo

Le jour du lancement de Meta Movie Gen, APPSO a immédiatement signalé et interprété ce dernier modèle de génération vidéo. De manière générale, Movie Gen a quatre fonctions : génération vidéo, génération vidéo personnalisée, montage précis et génération audio.

Examinons d'abord la génération vidéo la plus basique Movie Gen Video. La capacité multimodale rend le nouveau modèle capable d'une variété de méthodes de saisie différentes. Les utilisateurs peuvent non seulement générer des vidéos correspondantes à l'aide d'un simple texte et de quelques mots d'invite, mais également directement. traiter les images requises. Mettez les images dans le modèle et transformez les images statiques en vidéos dynamiques selon les exigences du texte.

▲ Texte d'invite : Une fille court sur la plage, tenant un cerf-volant à la main ; elle porte un short en jean et un T-shirt jaune ;

Vous pouvez même demander à Movie Gen de vous aider à régénérer ou à optimiser une vidéo. Quelle que soit la méthode de saisie choisie, la vidéo de démonstration actuelle de Movie Gen sur le site officiel est très efficace. Les personnages ont des expressions naturelles et les détails de l'image sont en place. Elle peut également générer des résultats correspondants en fonction des mots d'invite ou des exigences du texte. plus précisément.

Andrew Brown a introduit que dans le processus de génération vidéo, il est très important d'étendre les paramètres de données, de calcul et de modèle, de les combiner avec une correspondance de flux et de se tourner vers une architecture LLM simple et couramment utilisée (Llama), obtenant ainsi une qualité de génération vidéo SOTA. .

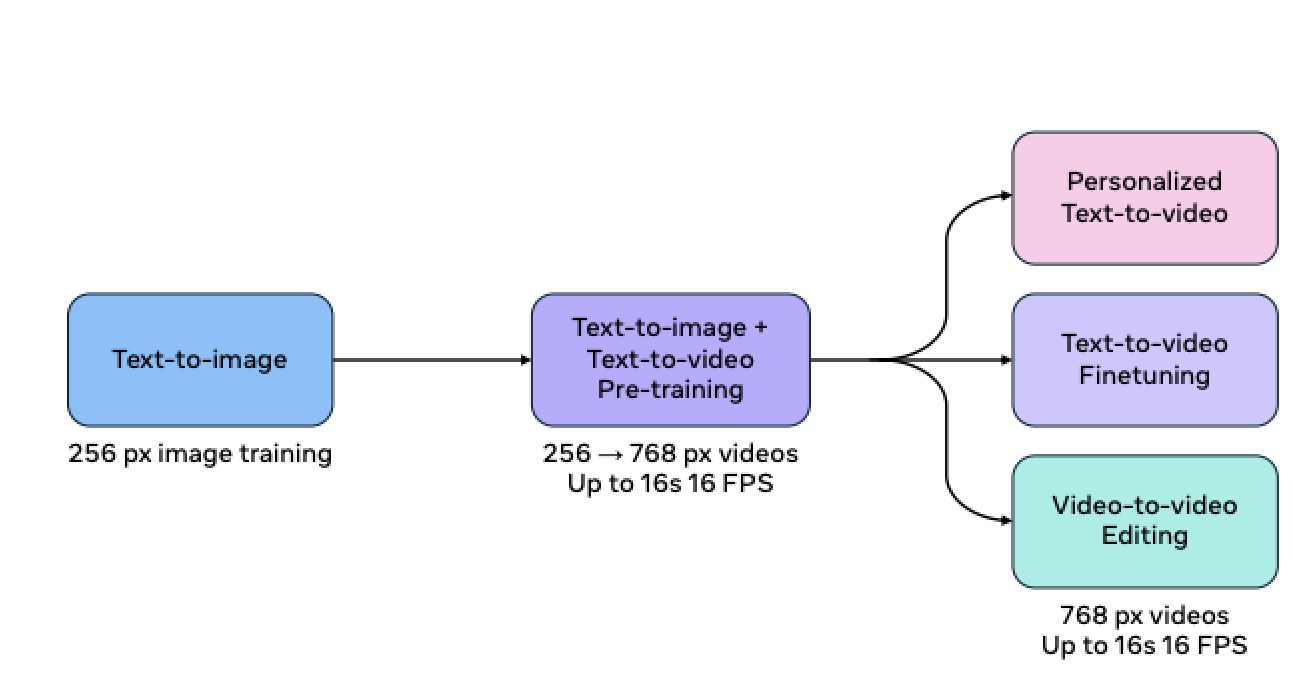

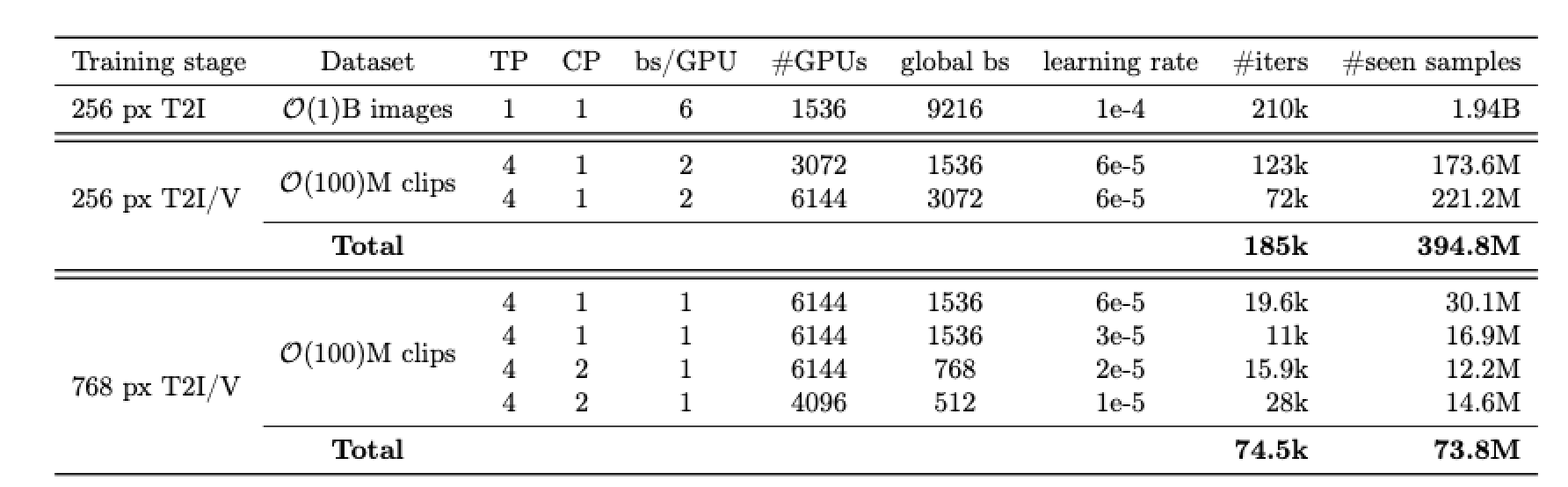

De plus, les modèles T2V, personnalisation et édition du nouveau modèle sont tous issus du même programme de formation. Lors de la pré-formation, Meta forme d'abord T2I puis T2V. Utilisez ce modèle comme initialisation, puis effectuez une post-formation T2V et entraînez-vous à personnaliser l'édition T2V et V2V.

De plus, l'entraînement du modèle est également effectué en fonction du niveau de résolution, d'abord avec un entraînement basse résolution (256px), puis avec un entraînement haute résolution (768px). Meta AI tente de former conjointement T2I + T2V, mais cela entraîne une convergence beaucoup plus lente et une qualité moins bonne qu'auparavant.

La raison pour laquelle Movie Gen Video peut obtenir des résultats de génération réalistes est essentiellement due aux excellentes capacités du modèle de convertisseur de paramètres jusqu'à 30B. Ce modèle peut générer des vidéos jusqu'à 16 secondes à une vitesse de 16 images par seconde et peut générer jusqu'à 16 images par seconde. 16 secondes de vidéo. 45 secondes d'audio de haute qualité et haute fidélité.

Les responsables du Meta ont également révélé dans le journal :

Ces modèles peuvent raisonner sur le mouvement des objets, les interactions sujet-objet et le mouvement de la caméra, et peuvent apprendre un mouvement raisonnable pour une variété de concepts.

Cette phrase a au total trois significations. La première est que le modèle lui-même peut presque restituer le mouvement physique du monde réel, ainsi que diverses lois physiques du « bon sens ». Pour les utilisateurs, ce qui semble « naturel et réaliste » est le. technologie modèle. L'endroit le plus réussi.

Movie Gen Video peut comprendre avec précision les schémas de mouvement du monde physique, et Meta AI a fait de gros efforts. L’équipe a effectué une pré-formation approfondie du nouveau modèle sur des centaines de millions de vidéos et des milliards d’images. Grâce à une répétition, un apprentissage, une synthèse, un raisonnement et une application constants, Movie Gen Video a obtenu des performances exceptionnelles sur le site officiel.

Ensuite, le modèle peut également imiter et apprendre activement les mouvements de caméra, les scènes, les montages, etc. de films professionnels. En d’autres termes, les vidéos générées via Movie Gen Video ont également le professionnalisme et le talent artistique similaires au tournage d’un film.

Cependant, Andrew Brown a mentionné que l’évaluation texte-vidéo est difficile. Parce que les mesures automatisées sont très médiocres et ne correspondent pas bien aux évaluations humaines. En d'autres termes, au début du développement des modèles de génération vidéo, les résultats de la génération étaient trop différents du monde physique réel dans les impressions et observations des gens. En fin de compte, Meta déterminait toujours l'authenticité de ce jugement, en s'appuyant entièrement sur l'humain. évaluation.

Nous déployons beaucoup d’efforts pour décomposer l’évaluation vidéo en plusieurs axes orthogonaux de qualité et d’alignement.

Résultats Movie Gen gagne ou est à égalité dans tous les domaines en termes de qualité et de cohérence par rapport aux modèles de l'ensemble d'évaluation de 1 000 repères.

Enfin, le modèle peut raisonner et créer le contenu suivant sur cette base. C'est comme un réalisateur professionnel, dirigeant chaque mouvement de l'image ; c'est aussi comme un artiste d'onomatopées expérimenté, sur la base d'un contenu vidéo ou d'invites textuelles, génère une bande sonore. Cela correspond à l'image en temps réel.

▲ L'effet sonore au moment où le feu d'artifice explose

La capacité de générer de l'audio de manière synchrone repose sur Movie Gen Audio. Il s'agit d'un modèle de convertisseur de paramètres 13B qui accepte l'entrée vidéo ainsi que les invites de texte facultatives pour la génération contrôlable d'audio haute fidélité synchronisé avec la vidéo.

Comme Movie Gen Video, Movie Gen Audio effectue également des exercices « massifs » et Meta AI alimente des millions d'heures de références audio dans la formation des modèles. Après de nombreuses comparaisons et résumés, le modèle actuel a maîtrisé la correspondance entre le son et l'image, et peut même comprendre les différents sentiments que les différents BGM apporteront au public.

Ainsi, lorsqu'il s'agit de mots indicateurs sur l'ambiance et l'environnement, Movie Gen Audio peut toujours trouver la musique qui correspond parfaitement à l'image.

Dans le même temps, il peut générer des sons ambiants, des pistes d'accompagnement instrumentales et des bruitages, offrant ainsi des résultats de pointe en termes de qualité audio, d'alignement vidéo-audio et d'alignement texte-audio.

Cela en fait les modèles les plus avancés de leur catégorie.

Bien que nous n'osions pas tirer une conclusion aussi confiante que celle officielle, peu importe en termes de durée officielle de la vidéo, de qualité d'image ou d'ajustement de la musique de fond, par rapport aux modèles de génération vidéo précédents, Movie Gen Video a des progrès très évidents.

De plus, par rapport à la précédente centrale idole Sora, Movie Gen a une nette avance en termes de qualité globale et de cohérence, a déclaré sans vergogne que dans ce jeu avec Sora :

Movie Gen gagne dans tous les domaines.

L'« expert polyvalent » du montage vidéo

Avec la collaboration de Movie Gen Video et Movie Gen Audio, le nouveau modèle de génération vidéo de Meta AI possède de nouvelles capacités. Cependant, les avancées mentionnées ci-dessus ne constituent que la base technique. Avec la capacité de générer de l'audio et de la vidéo, Meta a également continué à se développer. le nouveau modèle. Le champ d'application lui permet de prendre en charge la génération de vidéos personnalisées.

La personnalisation, comme son nom l'indique, consiste à combiner les besoins des utilisateurs et à générer un contenu vidéo spécifié en fonction des exigences.

Bien que les modèles vidéo précédents puissent également générer des résultats personnalisés, les résultats sont toujours insatisfaisants. Soit les détails ne peuvent pas être modifiés et doivent être recommencés, soit d'autres éléments de l'image ne peuvent pas être conservés lorsque les détails sont continuellement modifiés. par la génération de nouvelles vidéos.

La démonstration de Movie Gen Video sur le site officiel démontre très bien leurs avantages dans cet aspect. Le nouveau modèle peut non seulement générer des vidéos personnalisées en fonction des exigences des mots rapides/images de référence, mais également continuer à optimiser et ajuster les détails en fonction de la vidéo, et garantir que les autres contenus générés ne sont pas perturbés, ce qui constitue une « modification fine ».

Contrairement aux outils de génération traditionnels qui nécessitent des compétences spécialisées ou manquent de précision, Movie Gen préserve le contenu original et cible uniquement les pixels pertinents.

Notre modèle obtient des résultats de pointe dans la création de vidéos personnalisées qui préservent l'identité et les actions humaines.

Cette fonction est très utile pour de nombreux studios self-média ou pour les personnes ayant des besoins de montage vidéo. Elle peut apporter des modifications globales ou détaillées aux objets modifiés. Cela peut être aussi grand que la régénération de l'image entière en fonction du texte, ou aussi petit que simplement changer la couleur des cheveux du personnage, le style des lunettes, etc. Par exemple, des modèles peuvent être utilisés pour éliminer le fouillis inutile en arrière-plan.

Ou vous pouvez donner à la vidéo originale un nouvel arrière-plan, qu'il s'agisse de style ou de couleur, vous pouvez le modifier à tout moment et vous pouvez également transformer le jour en nuit en quelques secondes.

De plus, Movie Gen Video peut également apporter des ajustements subtils à de nombreux détails. Tout en garantissant que la composition de la vidéo et l'image globale restent inchangées, il peut également modifier la couleur des vêtements du personnage, le style de port des lunettes, les vêtements du corps principal et la couleur de la fourrure de l'animal. , etc.

Par exemple, supprimer l'encombrement inutile dans les vidéos, changer le style d'arrière-plan de l'image, ajouter des détails à la vidéo, changer la couleur des vêtements du sujet, etc. sont autant de ses points forts.

Mais ce n'est qu'un fantasme, car Movie Gen Video ne prend actuellement en charge que 1080P, 16 secondes, 16 images par seconde de vidéo longue haute définition, ou jusqu'à 45 secondes d'audio de haute qualité et haute fidélité. Ce type de résolution d’image et de durée de vidéo ne semble pas suffisant pour un individu ou une entreprise ayant des besoins créatifs.

Cependant, cette avancée technologique a permis à l'IA d'avoir la capacité d'éditer des fichiers vidéo avec des ajustements, une personnalisation et un ajustement précis à l'infini. De plus, Movie Gen Audio a ouvert la porte au doublage vidéo, même si Movie Gen Video ne sera disponible que l'année prochaine. Cela n'a pas été officiellement accueilli par le public, mais à en juger par les résultats officiels actuels des manifestations, il est réellement possible de donner un nouvel élan aux industries de la vidéo, du cinéma, de la télévision et de l'IA, et même de provoquer une nouvelle révolution.

Les outils les plus récents et les plus avancés, dont Movie Gen Video, tentent de briser ce stéréotype de l'IA dans le domaine de la génération vidéo, même si avec leurs capacités actuelles, ce jour est encore loin.

Pour les modèles de génération vidéo, il est difficile d'affecter directement ou même de toucher la vie quotidienne des gens ordinaires au début. Ce n'est peut-être que lorsqu'un certain film créé par l'IA sera créé qu'il attirera l'attention du public en termes de fraîcheur. Les films, séries télévisées et animations actuels produits avec l’IA présentent certains défauts tels que des images irréalistes et des mouvements incohérents.

Meta AI a également déclaré sur son site officiel qu'à mesure que la technologie des modèles s'améliore et se développe, ils travailleront en étroite collaboration avec les cinéastes et les créateurs pour intégrer leurs commentaires. À l'heure actuelle, qu'il s'agisse de Runway, Sora ou de la dernière Meta AI, ils se développent tous rapidement. Au moins par rapport aux résultats de la génération d'il y a un an, nous pouvons constater des progrès visibles.

L'impact de la technologie de l'IA sur la vie des gens n'est peut-être pas immédiatement apparent. Alors que tout le monde discute encore de « à quoi sert l'IA », sa plus grande importance pour la plupart des gens est qu'elle dispose d'un outil utile supplémentaire, un jouet amusant :

Qu'il s'agisse d'un cinéaste cherchant à réussir à Hollywood ou d'un créateur qui aime réaliser des vidéos pour un public, nous pensons que tout le monde devrait avoir accès à des outils qui l'aident à développer sa créativité.

# Bienvenue pour suivre le compte public officiel WeChat d'Aifaner : Aifaner (ID WeChat : ifanr). Un contenu plus passionnant vous sera fourni dès que possible.

Ai Faner | Lien original · Voir les commentaires · Sina Weibo