Une fois que ChatGPT pourra parler le langage humain, la pollution d’Internet par l’IA deviendra encore plus grave

Ce que les humains craignent le plus est arrivé.

Je lis au hasard quelques articles de presse sur Internet, mais je ne peux pas dire s'ils sont créés par l'IA ou par des humains. Lorsque je joue à des jeux pendant mon temps libre, je ne peux pas dire si mes coéquipiers sont des humains IA ou de vraies personnes.

Dans la salle de diffusion en direct, les célébrités numériques ont sucé elles-mêmes des pattes de poulet, créant une scène séparée des assistants réels qui criaient…

Selon le média étranger 404 media, Wordfreq, un projet initialement utilisé pour suivre et analyser la popularité et la fréquence d'utilisation de différents mots et vocabulaires dans plusieurs langues, est devenu la dernière victime.

Là où le soleil brille, il y a toujours une ombre qui se cache, et il est clair que Wordfreq n'est pas la première victime, ni la dernière.

En d’autres termes, ce sont peut-être les humains eux-mêmes qui en fin de compte en paient le prix.

Le GPT pollue le langage et les humains doivent en payer le prix

« L’IA générative a pollué les données, et je pense que personne ne dispose d’informations fiables sur l’utilisation du langage humain après 2021. »

Ce cri du cœur de Robin Spear, le fondateur du projet Wordfreq, révèle un peu d'impuissance et de ressentiment.

Pour explorer la raison derrière cela, nous devons commencer par l’origine de Wordfreq.

En analysant le contenu de Wikipédia, les sous-titres de films et de séries télévisées, les reportages et les sites Web tels que Reddit, Wordfreq tente de suivre l'évolution de plus de 40 langues, puis d'étudier l'évolution des habitudes linguistiques à mesure que l'argot et la culture pop changent.

Wordfreq est un trésor pour les linguistes, les écrivains et les traducteurs. Mais voilà, une énorme déclaration sur l'adresse GitHub "Ce projet ne sera plus mis à jour" a malheureusement sonné le glas de ce projet.

Dans le passé, l’extraction de données publiques sur le Web était l’élément vital de la source de données du projet, mais l’essor de l’IA générative a rendu le texte IA populaire.

Spear a donné un exemple typique : dans le passé, les gens utilisaient rarement le mot « fouiller ». Cependant, à mesure que ChatGPT a transformé ce mot en mantra, Li Gui est devenu plus susceptible de se faire passer pour Li Kui, ce qui a parfois influencé les statistiques de fréquence des mots. analyse précise des habitudes de langage humain.

Comme si cela n’était pas assez intuitif, la multiplication des clichés comme « en résumé » et « pour résumer » sont les avertissements les plus frappants.

Cette tendance pénètre progressivement dans l’écriture académique et même dans la création littéraire.

Un rapport de l'Université de Stanford a souligné que ChatGPT est devenu un « artefact d'écriture » pour de nombreux experts et universitaires en seulement cinq mois. Parmi eux, dans le domaine de l'informatique, presque tous les six résumés et toutes les sept introductions sont rédigés par lui.

Ce qui s’ensuit est « l’invasion massive » du style d’écriture humain par l’IA générative.

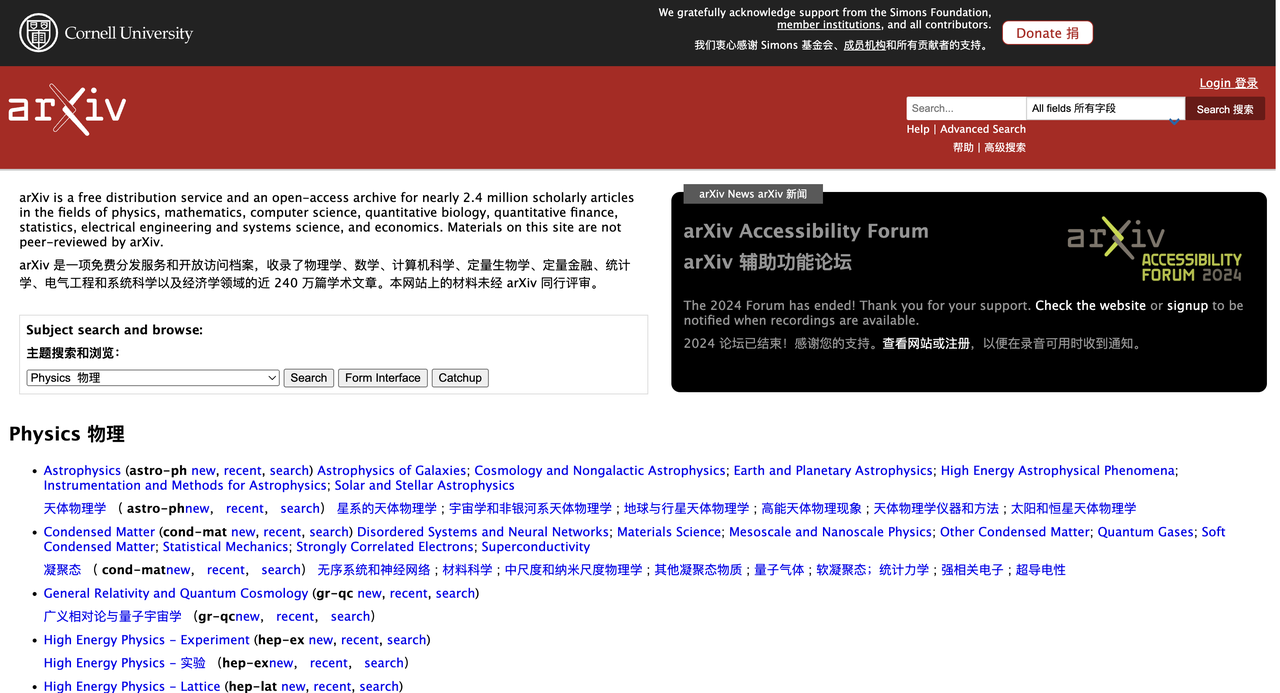

Les résultats de la recherche de Geng Mingmeng, doctorant à l'Institut italien d'études avancées internationales, sont comme un miroir, reflétant davantage les préférences verbales de ChatGPT et confirmant pleinement son influence dans la rédaction d'articles universitaires.

Après avoir analysé les résumés de plus d'un million d'articles sur arXiv, Geng Mingmeng a constaté que la fréquence des mots dans les articles a considérablement changé après la popularité de ChatGPT. Parmi eux, la fréquence d'utilisation de mots tels que « important » a considérablement augmenté, tandis que la fréquence d'utilisation de mots tels que « est » et « sont » a diminué d'environ 10 %.

Dans la plupart des cas, l'IA générative peut transformer une personne avec un score de créativité de 60 en un score de 70 ou plus. Cependant, dans la création de textes, bien que la créativité personnelle et la qualité de l'écriture se soient améliorées, elle est devenue invisiblement ennuyeuse et homogène. .

Deux universitaires de l'UCL et de l'Université d'Exeter ont publié une étude dans Science dans laquelle 500 participants ont été chargés d'utiliser l'IA pour écrire environ 8 lignes d'histoires sur des sujets aléatoires et analyser le public cible.

Les résultats ont montré que les histoires sont devenues plus « créatives » grâce à l’inspiration de l’IA, mais que les histoires générées par ces IA étaient également étonnamment similaires les unes aux autres.

Par conséquent, lorsque le texte de l’IA générative inonde Internet comme un polluant omniprésent, pour Wordfreq et les humains, les avantages dépassent de loin les inconvénients.

La guerre anti-crawler commence, Wordfreq souffre

L’arrêt du projet Wordfreq peut être considéré comme une victime prise dans la guerre des robots géants.

Le développement de l’IA est indissociable du support des algorithmes, de la puissance de calcul et des données. Bien qu'il existe encore un écart entre le texte généré par l'IA et le langage humain réel, il devient de plus en plus décent en termes de grammaire et de logique.

Sous cette eau calme, une guerre silencieuse entre l’IA rampante et l’anti-crawling se prépare.

Dans l'environnement actuel de l'opinion publique, l'exploration des données des pages Web semble être devenue un tabou pour le monde. De nombreuses zones de commentaires sur les reportages sont remplies de voix méprisantes de la part des internautes, et Wordfreq est essentiellement construit en explorant des textes dans différentes langues. .

Lorsque l’IA générative n’était pas encore populaire, Wordfreq a également passé une période de lune de miel.

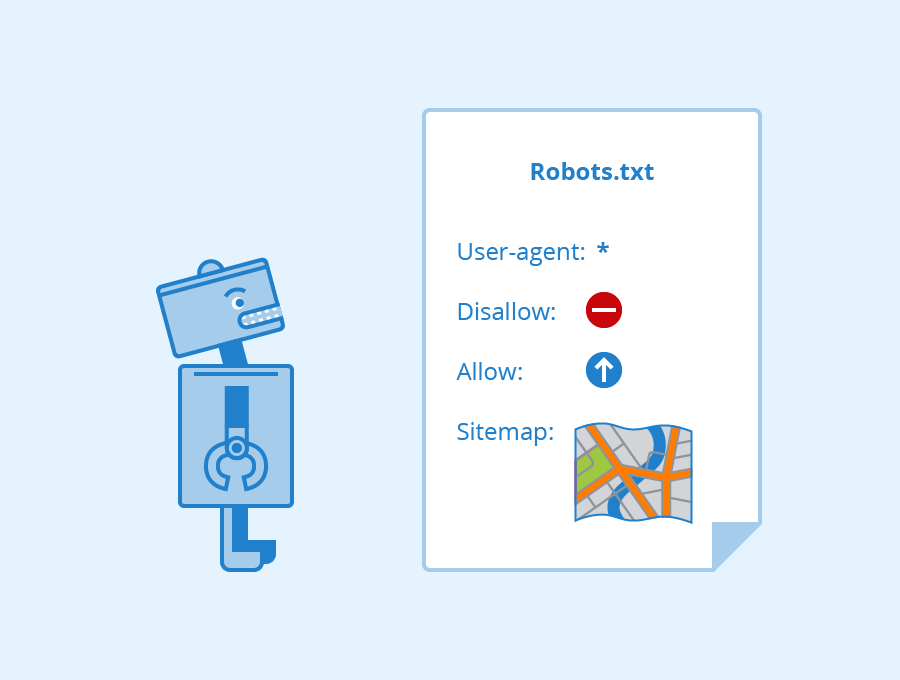

Dans le passé, d'une manière générale, il semblait raisonnable d'explorer les données publiques tant que les réglementations relatives aux fichiers robots.txt du site Web étaient respectées. Il s'agit d'un accord tacite entre le site Web et le robot d'exploration, qui est utilisé pour indiquer au robot d'exploration quel contenu peut être exploré et quel contenu ne peut pas l'être.

Lorsqu'un site Web définit un accord de restriction robots.txt, c'est comme installer un panneau d'interdiction d'entrée. Si le robot d'exploration viole l'accord robots.txt ou utilise une méthode qui brise la technologie anti-crawler du site Web pour obtenir des données, cela peut constituer une concurrence déloyale ou une violation du droit d'auteur et d'autres actes illégaux.

Cependant, à mesure que la demande du modèle pour des données de haute qualité augmente, la bataille entre l'exploration et l'anti-exploration devient de plus en plus féroce.

En regardant le passé, les différends abondent sur les données génératives des robots géants et anti-crawler de l’IA. Les plus importants sont naturellement OpenAI et Google.

L'année dernière, OpenAI a lancé l'outil d'exploration de sites Web GPTBot, prétendant être utilisé pour explorer les données de pages Web afin de former des modèles d'IA. Mais évidemment, aucun média ne veut être secrètement exploité par des robots d’exploration.

Les médias conscients de l’importance des données et du droit d’auteur suivent la logique commerciale consistant à remettre l’argent d’une main et les données de l’autre.

Une étude menée par l’Institut Reuters montre qu’à la fin de 2023, près de la moitié des sites Web d’information populaires dans 10 pays à travers le monde avaient bloqué le robot d’exploration d’OpenAI (Crawler), et près d’un quart des sites Web avaient également bloqué Google. le robot effectue la même action.

Tout le monde devrait être familier avec l'histoire qui a suivi. OpenAI a été poursuivi en justice par les médias traditionnels tous les quelques jours, et sans exception, il s'agissait d'une action en justice pour droits d'auteur. Ce n’est que cette année qu’OpenAI, en proie à un procès, a établi des partenariats avec des éditeurs de presse.

Cependant, les stratégies précédentes telles que les murs élevés et les frais de données ont également fait de Wordfreq une victime de cette « pénurie de données ».

Spear souligne que depuis que Twitter et Reddit (un site inclus dans Wordfreq) ont commencé à facturer leurs API, cela a rendu plus difficile le scraping du Web.

"Les informations qui étaient gratuites sont devenues coûteuses", écrit Spear. "Je ne veux pas être impliqué dans un travail qui pourrait être confondu avec l'IA générative ou qui pourrait bénéficier de l'IA générative."

Même si vous pouvez échanger de l’argent contre des données, celles-ci finiront par être utilisées.

Le cabinet de recherche Epoch AI prédit que les données textuelles de haute qualité disponibles sur Internet pourraient être épuisées d'ici 2028. Ce phénomène est appelé « mur de données » dans l'industrie et pourrait devenir le plus grand obstacle au ralentissement du développement de l'IA.

En conséquence, de nombreux grands fabricants de modèles ont commencé à tourner leur attention vers les données synthétiques, en se concentrant sur l’utilisation de l’IA pour entraîner l’IA.

Utiliser l’IA pour entraîner l’IA peut la rendre « stupide » à mesure que vous la pratiquez.

Mon intuition est que le texte sur Internet est de la connerie, et s'entraîner sur ces données est un gaspillage de puissance de calcul.

Lorsque Llama 3.1-405B a balayé de nombreux grands modèles open source grâce à sa puissance révolutionnaire, Thomas Scialom, le chercheur Meta AI qui dirige la série Llama, a fait les remarques ci-dessus dans une interview.

Selon lui, le processus de formation de Llama 3 ne repose sur aucune réponse écrite par l'homme, mais est entièrement basé sur des données synthétiques générées par Llama 2.

La déclaration de Scialom est peut-être trop grossière, mais elle contient une part de vérité.

Un flux constant de données apparaît chaque jour sur Internet, mais la formation de l'IA a toujours été une question à choix multiples. Si les données sont pleines d'erreurs et de bruit, le modèle apprendra naturellement ces « défauts » et l'exactitude des prédictions. et la classification peut être imaginée et connue.

De plus, les données de mauvaise qualité sont souvent truffées de biais et ne peuvent pas véritablement représenter la distribution globale des données, ce qui amène le modèle à produire des réponses biaisées. Le Directeur général de l'UNESCO, Azoulay, a également mis en garde :

« Les nouveaux outils d’IA ont le pouvoir de changer sans le savoir les perceptions de millions de personnes, de sorte que même un minimum de préjugés sexistes dans le contenu généré peut exacerber considérablement les inégalités dans le monde réel. »

Cependant, les données synthétiques ne constituent peut-être pas une panacée pour résoudre le problème du « mur de données ».

Récemment, des chercheurs d'Oxford et de Cambridge ont découvert que lorsqu'un modèle utilise des ensembles de données générés par l'IA, la qualité du résultat diminue progressivement, produisant finalement un contenu dénué de sens, communément appelé effondrement du modèle.

Le directeur de recherche Ilia Shumailov a utilisé la métaphore de la prise de photo pour décrire le processus :

Si vous prenez une photo, la numérisez, l'imprimez, la prenez en photo, puis répétez le processus au fil du temps, l'ensemble du processus sera essentiellement noyé par le « bruit ». A la fin, vous obtiendrez un carré sombre.

Lorsque de plus en plus de pages Web de spam générées par l’IA commenceront à inonder Internet, les matières premières nécessaires à la formation des modèles d’IA seront également contaminées.

Par exemple, Stack Overflow, une communauté de questions-réponses pour les programmeurs, a été profondément affectée par l'IA.

Lorsque ChatGPT est devenu populaire pour la première fois, Stack Overflow a annoncé une « interdiction temporaire ». "La proportion moyenne de réponses correctes obtenues sur ChatGPT est trop faible", s'est plaint le responsable dans le communiqué.

Après tout, le nombre d'utilisateurs professionnels est limité, et il est impossible de vérifier toutes les réponses une par une, et le taux d'erreur de ChatGPT est évident. Lorsque l’IA pollue l’environnement communautaire, les humains qui n’ont rien à faire à ce moment-là ne peuvent que l’interdire.

Dans le domaine des images, les modèles d’IA ont tendance à reproduire les données les plus courantes et, après de nombreuses itérations, ils peuvent finir par oublier même l’original.

Tout cela indique un cercle vicieux : l’IA génère des informations de mauvaise qualité, voire erronées, qui sont mélangées à des données humaines. Ces données généralement de mauvaise qualité sont alimentées à plusieurs reprises par l’IA, ce qui finit par conduire l’IA rampante à se retourner contre elle-même.

Et si les humains réalisent que les empreintes de données du passé deviendront leur propre nourriture, peut-être serons-nous plus prudents à l’égard de chaque mot que nous laissons sur Internet.

# Bienvenue pour suivre le compte public officiel WeChat d'aifaner : aifaner (ID WeChat : ifanr). Un contenu plus passionnant vous sera fourni dès que possible.

Ai Faner | Lien original · Voir les commentaires · Sina Weibo