Une mise à jour majeure de l’artefact vidéo IA domestique, prenant en charge la 4K, 60 images et l’ère de la génération vidéo avec son, est ici

Cette année, le domaine de la génération vidéo IA bat son plein.

Du temps de génération initial du rouleau à la qualité de l'image du rouleau, en passant par l'introduction récente des effets spéciaux de l'IA, les fabricants de l'industrie ont lancé les rouleaux de différentes manières, mais ils ont tous un objectif commun, qui est de travailler dur pour attirer de nouveaux utilisateurs et conserver les anciens utilisateurs.

Cependant, même si de nombreux modèles vidéo sur le marché prétendent générer des vidéos en un seul clic, les produits finis de type « mime » sont quelque peu inutiles. En particulier, notre seuil de stimulation pour les vidéos IA a été relevé à plusieurs reprises, et le manque d'effets sonores est comme un clou martelé, perçant de plus en plus profondément dans le cœur des utilisateurs.

Bien sûr, ce n’est pas que les fabricants ne veulent pas résoudre complètement ce problème, ils attendent juste une opportunité d’accumuler plus d’expérience.

Il y a trois mois, en tant que premier produit de génération vidéo ouvert au public en Chine, Zhipu Qingying a été lancé sur l'application Qingyan, qui peut générer des vidéos IA en 30 secondes avec juste une commande ou une image.

Aujourd'hui, trois mois plus tard, Zhipu Qingying a de nouveau inauguré une vague d'améliorations majeures.

Durée de 10 secondes, 4k, qualité d'image ultra haute définition de 60 images, n'importe quelle taille, meilleures actions de tâches et modèles du monde physique… En plus des compétences de base pour ouvrir un livre, plus important encore, Zhipu Qingying sera également lancé ce mois pour générer et faire correspondre les effets sonores de l'écran.

Vous trouverez ci-joint les points forts spécifiques de la mise à niveau de New Qingying :

- La qualité vidéo, les performances esthétiques, la rationalité des mouvements et la compréhension sémantique des mots d'invite complexes de Tusheng ont été considérablement améliorées ;

- Des détails plus forts sur les performances faciales, la cohérence des mouvements et la simulation des propriétés physiques améliorent le naturel et le réalisme de la vidéo ;

- Prend en charge la génération de vidéos ultra haute définition 10 s, 4K et 60 images, et prend en charge la génération d'images dans n'importe quel rapport ;

- La même commande/image peut générer 4 vidéos à la fois, et la fonction d'effet sonore qui correspond à l'image sera lancée en version bêta publique bientôt ce mois-ci ;

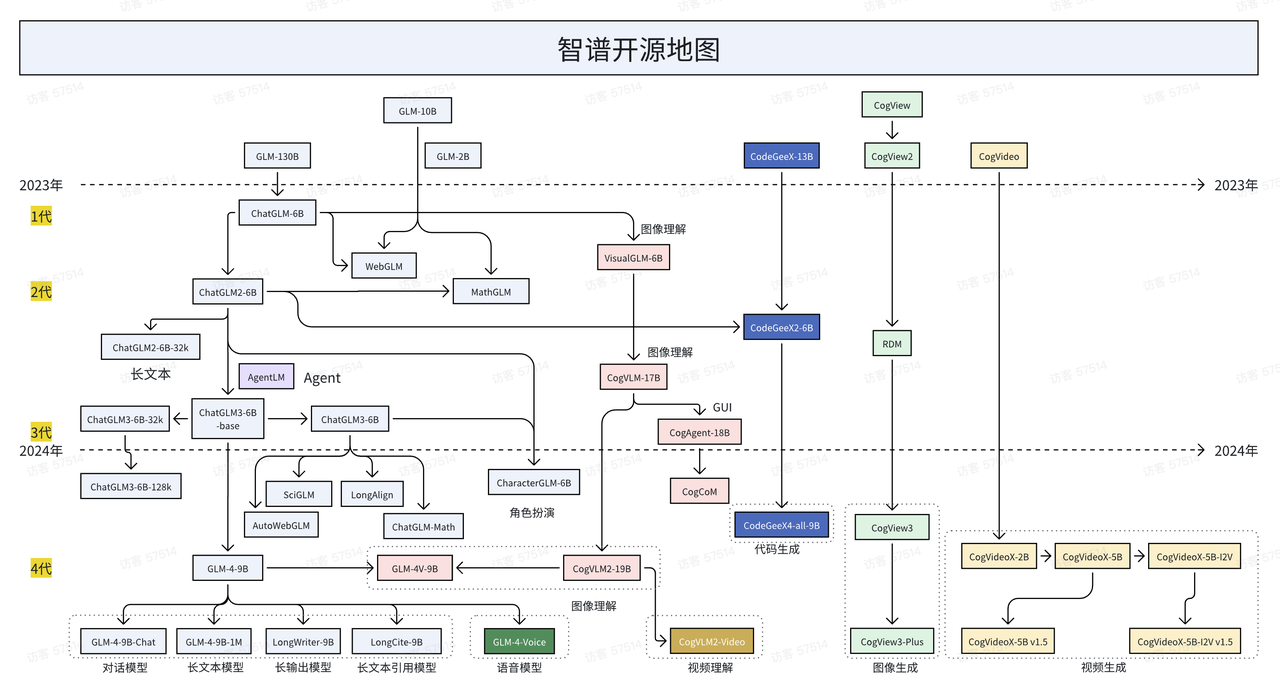

De plus, alors que les gens débattent encore de l'open source/source fermée de l'IA, Zhipu est l'une des rares entreprises nationales à prendre systématiquement en charge l'open source. Aujourd'hui, Zhipu a également officiellement publié et open source la dernière version du modèle vidéo CogVideoX v1.5.

Cette open source comprend deux modèles : CogVideoX v1.5-5B et CogVideoX v1.5-5B-I2V. À l'avenir, CogVideoX v1.5 sera également lancé simultanément sur Qingying et combiné avec le nouveau modèle d'effet sonore CogSound.

Code : https://github.com/thudm/cogvideo

Modèle : https://huggingface.co/THUDM/CogVideoX1.5-5B-SAT

Officiellement annoncé que New Qingying sera désormais lancé sur l'application Zhipu Qingyan. Pas grand chose à dire, il suffit de joindre l'adresse de l'expérience : https://chatglm.cn/video?lang=zh

4K 60 images, la nouvelle vidéo claire a atteint le niveau supérieur

Le gentil vieil homme sourit et les détails de ses muscles faciaux sont clairement visibles sans pixellisation ni flou évident.

L'image du tigre de flamme est également impressionnante. Non seulement sa démarche semble réaliste, mais ses yeux révèlent également une beauté sauvage, et la couleur de la flamme sur son corps montre également des niveaux de couleurs et une profondeur riches.

Le véhicule accélère rapidement, il n'y a pas de décalage ni de retard dans les transitions de scène, même les objets en mouvement rapide peuvent maintenir la continuité, et il est également efficace pour créer une sensation de vitesse et de tension.

Les Miaous se transforment en chefs en ligne et font sauter habilement les plats d'aujourd'hui.

Ne vous laissez pas berner par la rhétorique de la démo. La mise en route est le seul critère pour tester l'effet réel.

Nous avons également utilisé la fonction vidéo Tusheng pour réaliser une vidéo du vol de la lanterne Kongming. La lanterne Kongming a été lâchée et s'est lentement élevée dans le ciel nocturne. La caméra a suivi de bas en haut et le ciel a été teint d'un bleu profond.

Ou bien, nous avons « ressuscité » les petites fleurs jaunes qui étaient immobiles, et la brise soufflait, et les petites fleurs jaunes se balançaient doucement sur l'herbe.

Cependant, "New Qingying" nécessite encore un certain degré de tirage de cartes. Il s'agit également d'un problème courant dans la stabilité des modèles vidéo d'IA nationaux et étrangers. Lors de l'utilisation quotidienne de tels produits, il faut plus de patience.

Pour les vidéos, les effets sonores et les images se complètent toujours. Sur cette base, nous avons également utilisé plusieurs vidéos « mime » sans l'audio, et avons laissé l'IA générer les effets sonores correspondants pour elles. Il est recommandé d'activer le bouton de volume pour manger. .

Par exemple, le duel de piano le plus classique de « Le pianiste sur la mer ». Préférez-vous cette version ou la version originale ?

Le magnifique feu d'artifice, au moment où ils fleurissent dans le ciel nocturne, associé aux effets sonores de l'IA, vous impressionne-t-il ?

Les sons des gouttes de pluie sont différents, certains sont nets, certains sont profonds, certains sont rapides et certains sont longs.

La scène de l'explosion nucléaire est immense, mais le son ne présente presque aucun retard. Il simule bien les sons réels d'une explosion, le bruit ambiant et ses conséquences.

Ne vous inquiétez pas, écoutez bien, il y a aussi Avatar Underwater Adventure.

Si vidéo Cog

Du muet au sonore, la vidéo IA entre dans l’ère des films sonores

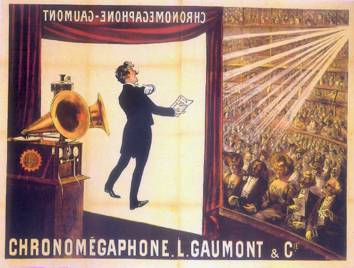

Les premiers films parlants ont été projetés à Paris en 1900, et ce n'est qu'une décennie plus tard que la technologie, capable de synchroniser le son avec les images, a atteint les normes commerciales.

L’avènement du cinéma parlant a non seulement mis fin à l’état muet du cinéma depuis sa naissance, mais, plus important encore, il a transformé le cinéma d’un art purement visuel en une nouvelle forme d’art combinant l’audio et la vidéo.

Les acteurs du film ont pris la parole et le public a applaudi les films parlants.

Les deux voix de leur cœur symphoniquent et les sons de leur cœur résonnent.

Aujourd'hui, le cycle de l'histoire se reproduit depuis le « mime » du début de l'année jusqu'aux effets sonores de l'IA d'aujourd'hui, si le premier est encore limité à 0-1, alors l'ajout des effets sonores de l'IA marque un pas épique depuis. 1-N.

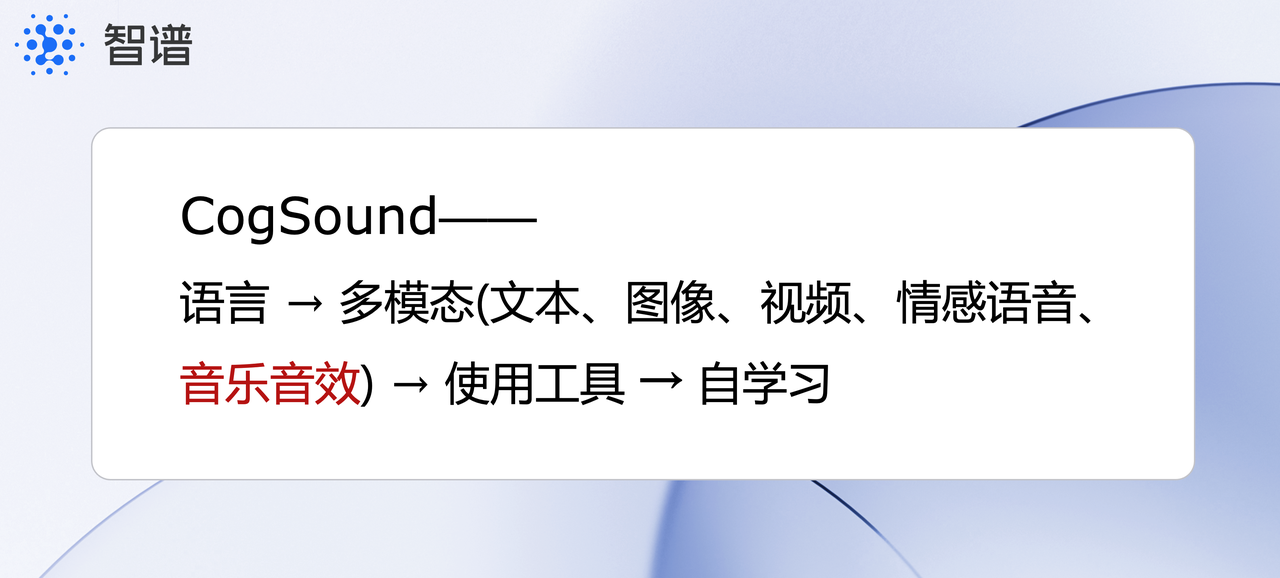

Basé sur les capacités de compréhension vidéo du GLM-4V, le modèle d'effets sonores CogSound, un nouveau membre de la famille Intelligent Spectrum, peut identifier et comprendre avec précision la sémantique et les émotions derrière la vidéo et, sur cette base, générer un contenu audio correspondant.

Par exemple, des explosions, des écoulements d’eau, des instruments de musique, des bruits d’animaux, des bruits de véhicules, etc.

Dans les récits d’images, l’arrivée du son constitue un tournant clé. Il permet non seulement de sortir le récit des vidéos qui s’appuient sur le texte, mais aussi d’ouvrir un espace d’imagination plus large en termes de concepts et de méthodes.

Cependant, l’introduction de l’IA dans l’industrie du cinéma et de la télévision est sans aucun doute controversée.

Le mois dernier, la grève des acteurs hollywoodiens ne s'est pas calmée et le réalisateur Cameron a déclaré lors du sommet que l'IA redéfinirait la narration cinématographique et aiderait les scénaristes et les réalisateurs à explorer de nouvelles intrigues et techniques narratives.

Dans l'industrie vidéo, les modèles d'effets sonores ont également un large éventail de scénarios d'application. Par exemple, ils peuvent générer des sons pour des scènes de bataille à grande échelle et des scènes de catastrophe dans des films, raccourcissant ainsi considérablement le cycle de production et réduisant les coûts de production.

Mais à quoi devrait ressembler exactement l’art audiovisuel à l’ère de l’IA ?

L’explosion technologique de l’histoire nous a donné quelques idées. Si la mécanisation et les chaînes d'assemblage de la révolution industrielle ont rendu possible une production de masse standardisée, alors avec l'arrivée de l'IA, en apprenant une grande quantité de données et de modèles, elle peut imiter le processus de prise de décision humain et personnaliser le processus de prise de décision. selon les besoins spécifiques de chaque utilisateur. Service personnalisé adapté aux besoins et aux préférences.

Bref, en abaissant les barrières d’utilisation, l’IA permet à chaque personne ordinaire de créer les vidéos personnalisées qui lui plaisent.

Jean-Luc Godard, représentant de la Nouvelle Vague française, a également évoqué l'impact des changements technologiques sur le langage et le talent artistique du cinéma :

"Les films n'utilisent pas seulement le son et les images lors du tournage, mais construisent un certain langage dans l'esprit du public. Les films muets ont créé plus de possibilités grâce à la vision, et les films sonores ont changé cette façon de créer."

En février de cette année, les attentes des gens en matière de vidéo IA ont été lancées pour la première fois par Sora publié par OpenAI. Malheureusement, jusqu'à présent, le produit semble être tombé dans une situation de « Tathagata » et n'a pas encore été vu.

C'est également durant cette période que nous sommes très heureux de constater que les constructeurs nationaux ont même délivré de bons résultats sur cette piste.

Cependant, ce n'est peut-être qu'un apéritif. Zhipu estime que la véritable intelligence doit être multimodale, l'audition, la vision, le toucher, etc. participant conjointement à la formation des capacités cognitives du cerveau humain.

La construction d'une matrice de grands modèles à spectre intelligent multimodale comprenant du texte, des images, une vision et d'autres modalités peut encore améliorer les capacités d'application et d'outils des grands modèles, et va également vers l'objectif ultime de l'IA – AGI.

On peut dire à ce stade que nous sommes véritablement entrés dans l’ère des films parlants IA.

# Bienvenue pour suivre le compte public officiel WeChat d'Aifaner : Aifaner (ID WeChat : ifanr). Un contenu plus passionnant vous sera fourni dès que possible.

Ai Faner | Lien original · Voir les commentaires · Sina Weibo