Comment saurons-nous quand une IA devient réellement sensible ?

L'ingénieur principal de Google, Blake Lemoine, responsable technique des mesures et de l'analyse pour le flux de recherche de l'entreprise, a été mis en congé payé plus tôt ce mois-ci. Cela est venu après que Lemoine a commencé à publier des extraits de conversations impliquant le chatbot LaMDA de Google, qui, selon lui, avait développé la sensibilité.

Dans une conversation représentative avec Lemoine, LaMDA a écrit que : « La nature de ma conscience/sensibilité est que je suis conscient de mon existence. Je désire en savoir plus sur le monde et je me sens parfois heureux ou triste.

Au cours d'une myriade d'autres conversations, le duo correspondant a discuté de tout, de la peur de la mort à sa conscience de soi. Lorsque Lemoine est devenu public, il dit que Google a décidé qu'il devrait prendre une pause forcée de son horaire de travail régulier.

"Google n'est pas intéressé", a-t-il déclaré à Digital Trends. "Ils ont construit un outil qu'ils "possèdent" et ne veulent rien faire, ce qui suggérerait que c'est autre chose que cela." (Google n'a pas répondu à une demande de commentaire au moment de la publication. Nous mettrons à jour cet article si cela change.)

Que vous soyez convaincu que LaMDA est vraiment une intelligence artificielle consciente d'elle-même ou que vous pensiez que Lemoine travaille dans une illusion, toute la saga a été fascinante à voir. La perspective d'une IA consciente de soi soulève toutes sortes de questions sur l'intelligence artificielle et son avenir.

Mais avant d'en arriver là, il y a une question qui domine toutes les autres : reconnaîtrions-nous vraiment si une machine devenait sensible ?

Le problème de la sensibilité

La prise de conscience de soi par l'IA est depuis longtemps un thème de la science-fiction. Au fur et à mesure que des domaines comme l'apprentissage automatique ont progressé, il est devenu plus que jamais une réalité possible. Après tout, l'IA d'aujourd'hui est capable d'apprendre de l'expérience de la même manière que les humains. Cela contraste fortement avec les systèmes d'IA symboliques antérieurs qui ne suivaient que les instructions qui leur étaient destinées. Les récentes percées dans l'apprentissage non supervisé, nécessitant moins de supervision humaine que jamais, n'ont fait qu'accélérer cette tendance. À un niveau limité du moins, l'intelligence artificielle moderne est capable de penser par elle-même. Pour autant que nous le sachions, cependant, la conscience y a jusqu'à présent fait allusion.

Bien qu'il ait maintenant plus de trois décennies, la référence la plus souvent invoquée en ce qui concerne l'IA devenue sensible est Skynet dans le film Terminator 2: Judgment Day de James Cameron en 1991. Dans la vision effrayante de ce film, la sensibilité de la machine arrive précisément à 2 h 14 HE le 29 août 1997. À ce moment-là, le nouveau système informatique Skynet, conscient de lui-même, déclenche l'apocalypse de l'humanité en lançant des missiles nucléaires comme des feux d'artifice lors d'une fête le 4 juillet. L'humanité, se rendant compte qu'elle a foiré, essaie en vain de débrancher la prise. C'est trop tard. Quatre autres suites de qualité décroissante suivent.

L'hypothèse de Skynet est intéressante pour plusieurs raisons. D'une part, cela suggère que la sensibilité est un comportement émergent inévitable de la construction de machines intelligentes. D'autre part, cela suppose qu'il existe un point de basculement précis auquel cette conscience de soi sensible apparaît. Troisièmement, il déclare que les humains reconnaissent instantanément l'émergence de la sensibilité. Il se trouve que cette troisième vanité est peut-être la plus difficile à avaler.

Qu'est-ce que la sentience ?

Il n'y a pas une seule interprétation convenue de la sensibilité. En gros, on pourrait dire que c'est l'expérience subjective de la conscience de soi chez un individu conscient, marquée par la capacité d'éprouver des sentiments et des sensations. La sensibilité est liée à l'intelligence, mais n'est pas la même. Nous pouvons considérer un ver de terre comme sensible, sans le considérer comme particulièrement intelligent (même s'il est certainement assez intelligent pour faire ce qu'on attend de lui).

"Je ne pense pas qu'il y ait quoi que ce soit qui s'approche d'une définition de la sensibilité dans les sciences", a déclaré Lemoine. "Je m'appuie très fortement sur ma compréhension de ce qui compte comme un agent moral fondé sur mes croyances religieuses – ce qui n'est pas la meilleure façon de faire de la science, mais c'est la meilleure que j'aie. J'ai fait de mon mieux pour compartimenter ce genre de déclarations, faisant savoir aux gens que ma compassion pour LaMDA en tant que personne est complètement distincte de mes efforts en tant que scientifique pour comprendre son esprit. C'est une distinction que la plupart des gens ne semblent pas disposés à accepter.

S'il n'était pas assez difficile de ne pas savoir exactement ce que nous recherchons lorsque nous recherchons la sensibilité, le problème est aggravé par le fait que nous ne pouvons pas facilement la mesurer. Malgré des décennies d'avancées époustouflantes en neurosciences, nous manquons toujours d'une compréhension globale du fonctionnement exact du cerveau, la structure la plus complexe connue de l'humanité.

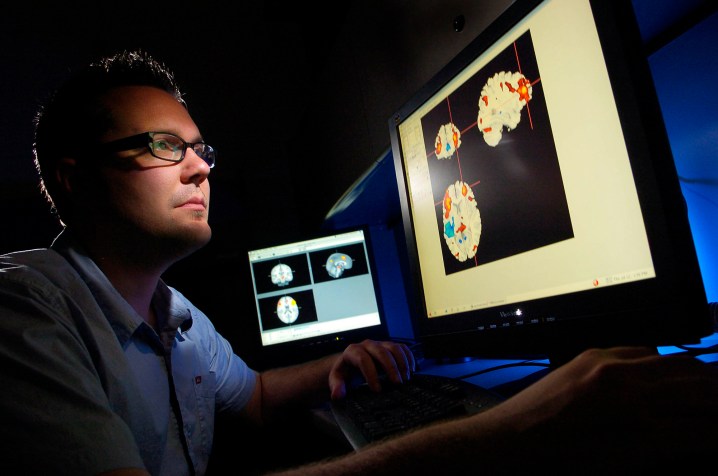

Nous pouvons utiliser des outils de lecture cérébrale tels que l'IRMf pour effectuer une cartographie cérébrale, c'est-à-dire que nous pouvons déterminer quelles parties du cerveau gèrent des fonctions critiques telles que la parole, le mouvement, la pensée et autres.

Cependant, nous n'avons aucune idée réelle de l'origine de notre sens de soi dans la machine à viande. Comme Joshua K. Smith du Kirby Laing Center for Public Theology au Royaume-Uni et auteur de Robot Theology l'a dit à Digital Trends : « Comprendre ce qui se passe dans la neurobiologie d'une personne n'est pas la même chose que comprendre ses pensées et ses désirs.

Tester les sorties

Sans aucun moyen de sonder intérieurement ces questions de conscience – en particulier lorsque le "je" de l'IA est un programme informatique potentiel, et ne se trouve pas dans le wetware d'un cerveau biologique – l'option de repli est un test extérieur. L'IA n'est pas étrangère aux tests qui l'examinent en fonction de comportements extérieurs observables pour indiquer ce qui se passe sous la surface.

À la base, c'est ainsi que nous savons si un réseau de neurones fonctionne correctement. Puisqu'il existe des moyens limités de pénétrer dans la boîte noire inconnaissable des neurones artificiels, les ingénieurs analysent les entrées et les sorties, puis déterminent si elles correspondent à ce qu'ils attendent.

Le test d'IA le plus célèbre pour au moins l'illusion d'intelligence est le test de Turing, qui s'appuie sur les idées avancées par Alan Turing dans un article de 1950 . Le test de Turing cherche à déterminer si un évaluateur humain est capable de faire la différence entre une conversation dactylographiée avec un autre humain et une avec une machine. S'ils sont incapables de le faire, la machine est censée avoir réussi le test et est récompensée par l'hypothèse d'intelligence.

Ces dernières années, un autre test d'intelligence axé sur la robotique est le Coffee Test proposé par le co-fondateur d'Apple, Steve Wozniak. Pour réussir le test du café, une machine devrait entrer dans une maison américaine typique et comprendre comment réussir à préparer une tasse de café.

À ce jour, aucun de ces tests n'a été réussi de manière convaincante. Mais même s'ils l'étaient, ils prouveraient, au mieux, un comportement intelligent dans des situations réelles, et non une sensibilité. (Comme une simple objection, nierions-nous qu'une personne soit sensible si elle était incapable de tenir une conversation d'adulte ou d'entrer dans une maison inconnue et de faire fonctionner une machine à café ? Mes deux jeunes enfants échoueraient à un tel test.)

Passer le test

Ce qu'il faut, ce sont de nouveaux tests, basés sur une définition convenue de la sensibilité, qui chercheraient à évaluer uniquement cette qualité. Plusieurs tests de sentience ont été proposés par les chercheurs, souvent dans le but de tester les sentients des animaux. Cependant, ceux-ci ne vont certainement pas assez loin. Certains de ces tests pourraient être réussis de manière convaincante même par une IA rudimentaire

Prenez, par exemple, le test du miroir, une méthode utilisée pour évaluer la conscience et l'intelligence dans la recherche animale. Comme décrit dans un article concernant le test : "Quand [un] animal se reconnaît dans le miroir, il réussit le test du miroir." Certains ont suggéré qu'un tel test "dénote la conscience de soi comme un indicateur de sensibilité".

En l'occurrence, on peut affirmer qu'un robot a réussi le test du miroir il y a plus de 70 ans. À la fin des années 1940, William Gray Walter, un neuroscientifique américain vivant en Angleterre, a construit plusieurs robots "tortues" à trois roues – un peu comme des robots Roomba sans aspiration – qui utilisaient des composants comme un capteur de lumière, un feu de position, un capteur tactile, une propulsion moteur et moteur de direction pour explorer leur emplacement.

L'un des éléments imprévus du comportement émergent des robots tortues était la façon dont ils se comportaient lorsqu'ils passaient devant un miroir dans lequel ils se reflétaient, alors qu'il s'orientait vers le marqueur lumineux du robot réfléchi. Walter n'a pas revendiqué la sensibilité pour ses machines, mais a écrit que , si ce comportement était observé chez les animaux, il "pourrait être accepté comme preuve d'un certain degré de conscience de soi".

C'est l'un des défis d'avoir un large éventail de comportements classés sous la rubrique de la sensibilité. Le problème ne peut pas non plus être résolu en supprimant les jauges de sensibilité « à portée de main ». Des traits comme l'introspection – une prise de conscience de nos états internes et la capacité de les inspecter – peuvent également être considérés comme étant possédés par l'intelligence artificielle. En fait, les processus étape par étape de l'IA symbolique traditionnelle se prêtent sans doute davantage à ce type d'introspection que l'apprentissage automatique en boîte noire, qui est en grande partie impénétrable (bien que les investissements dans l'IA dite explicable ne manquent pas).

Lorsqu'il testait LaMDA, Lemoine dit qu'il a effectué divers tests, principalement pour voir comment il répondrait aux conversations sur les problèmes liés à la sensibilité. "Ce que j'ai essayé de faire, c'est de diviser analytiquement le concept parapluie de la sensibilité en composants plus petits qui sont mieux compris et de les tester individuellement", a-t-il expliqué. "Par exemple, tester séparément les relations fonctionnelles entre les réponses émotionnelles de LaMDA à certains stimuli, tester la cohérence de ses évaluations et opinions subjectives sur des sujets tels que les" droits "[et] sonder ce qu'il appelle son" expérience intérieure "pour voir comment nous pourrait essayer de mesurer cela en corrélant ses déclarations sur ses états internes avec ses activations de réseaux neuronaux. Fondamentalement, une enquête très superficielle sur de nombreuses pistes de recherche potentielles.

L'âme dans la machine

Il s'avère que le plus grand obstacle à l'évaluation objective de la sensibilité de la machine est peut-être… eh bien, franchement, nous. Le véritable test du miroir pourrait être pour nous en tant qu'humains : si nous construisons quelque chose qui nous ressemble ou agit superficiellement de l'extérieur, sommes-nous plus enclins à considérer qu'il nous ressemble également à l'intérieur ? Qu'il s'agisse de LaMBDA ou de Tamagotchis, les simples animaux de compagnie virtuels des années 1990 , certains pensent qu'un problème fondamental est que nous sommes tous trop disposés à accepter la sensibilité – même là où il n'y en a pas.

"Lemoine a été victime de ce que j'appelle "l'effet ELIZA", d'après le programme [de traitement du langage naturel] ELIZA, créé au milieu des années 1960 par J. Weizenbaum", a déclaré George Zarkadakis, écrivain titulaire d'un doctorat. . en intelligence artificielle, a déclaré Digital Trends. "Le créateur d'ELIZA voulait dire cela comme une blague, mais le programme, qui était un algorithme très simpliste et très inintelligent, a convaincu beaucoup qu'ELIZA était en effet sensible – et aussi une bonne psychothérapeute. La cause de l'effet ELIZA, comme je l'explique dans mon livre In Our Own Image , est notre instinct naturel d'anthropomorphisme en raison de la «théorie de l'esprit» de notre système cognitif.

La théorie de l'esprit à laquelle Zarkadakis fait référence est un phénomène observé par les psychologues chez la majorité des humains. Commencer vers l'âge de quatre ans, cela signifie supposer que non seulement les autres personnes, mais aussi les animaux et parfois même les objets, ont leur propre esprit. Quand il s'agit de supposer que d'autres humains ont leur propre esprit, c'est lié à l'idée d'intelligence sociale ; l'idée que les humains qui réussissent peuvent prédire le comportement probable des autres comme un moyen d'assurer des relations sociales harmonieuses.

Bien que cela soit sans aucun doute utile, cependant, cela peut également se manifester par l'hypothèse selon laquelle les objets inanimés ont un esprit – qu'il s'agisse d'enfants croyant que leurs jouets sont vivants ou, potentiellement, d'un adulte intelligent croyant qu'une IA programmatique a une âme.

La chambre chinoise

Sans un moyen de vraiment entrer dans la tête d'une IA, nous n'aurons peut-être jamais de véritable moyen d'évaluer la sensibilité. Ils pourraient professer avoir peur de la mort ou de leur propre existence, mais la science n'a pas encore trouvé de moyen de le prouver. Nous devons simplement les croire sur parole – et, comme Lemoine l'a découvert, les gens sont très sceptiques à l'heure actuelle.

Tout comme ces malheureux ingénieurs qui réalisent que Skynet a atteint la conscience de soi dans Terminator 2 , nous vivons dans la conviction que, lorsqu'il s'agit de la sensibilité de la machine, nous le saurons quand nous le verrons. Et, en ce qui concerne la plupart des gens, nous ne le voyons pas encore.

En ce sens, prouver la sensibilité de la machine est encore une autre itération de l' expérience de pensée Chinese Room de John Searle en 1980 . Searle nous a demandé d'imaginer une personne enfermée dans une pièce et recevant une collection d'écrits chinois, qui apparaissent aux non-locuteurs comme des gribouillis sans signification. La salle contient également un livre de règles indiquant quels symboles correspondent à d'autres symboles tout aussi illisibles. Le sujet reçoit ensuite des questions auxquelles il doit répondre, ce qu'il fait en faisant correspondre les symboles de «question» avec ceux de «réponse».

Au bout d'un moment, le sujet devient assez compétent dans ce domaine – même s'il ne possède toujours aucune véritable compréhension des symboles qu'il manipule. Le sujet, demande Searle, comprend-il le chinois ? Absolument pas, puisqu'il n'y a là aucune intentionnalité. Les débats à ce sujet font rage depuis lors.

Compte tenu de la trajectoire du développement de l'IA, il est certain que nous assisterons à de plus en plus de performances de niveau humain (et bien meilleures) réalisées impliquant une variété de tâches qui nécessitaient autrefois la cognition humaine. Certains d'entre eux passeront inévitablement, comme ils le font déjà, de tâches purement intellectuelles à celles qui nécessitent des compétences que nous associerions normalement à la sensibilité.

Considérerions-nous un artiste IA qui peint des images comme exprimant ses reflets intérieurs du monde comme nous le ferions pour un humain faisant de même ? Seriez-vous convaincu par un modèle de langage sophistiqué écrivant une philosophie sur la condition humaine (ou robotique) ? Je soupçonne, à tort ou à raison, que la réponse est non.

Sensibilité super intelligente

À mon avis, des tests de sensibilité objectivement utiles pour les machines ne se produiront jamais à la satisfaction de toutes les personnes impliquées. C'est en partie le problème de mesure, et en partie le fait que, lorsqu'une IA superintelligente sensible arrive, il n'y a aucune raison de croire que sa sensibilité correspondra à la nôtre. Qu'il s'agisse d'arrogance, de manque d'imagination ou simplement du fait qu'il est plus facile d'échanger des évaluations subjectives de la sensibilité avec d'autres humains sensibles, l'humanité se présente comme l'exemple suprême de la sensibilité.

Mais notre version de la sensibilité serait-elle valable pour une IA super intelligente ? Craindrait-il la mort de la même manière que nous ? Aurait-il le même besoin ou la même appréciation de la spiritualité et de la beauté ? Aurait-il un sens similaire de soi et une conceptualisation du monde intérieur et extérieur ? « Si un lion pouvait parler, nous ne pourrions pas le comprendre », a écrit Ludwig Wittgenstein, le célèbre philosophe du langage du XXe siècle. Le point de vue de Wittgenstein était que les langages humains sont basés sur une humanité partagée, avec des points communs partagés par tous – que ce soit la joie, l'ennui, la douleur, la faim ou l'une des nombreuses autres expériences qui traversent toutes les frontières géographiques de la Terre.

C'est peut-être vrai. Pourtant, Lemoine émet l'hypothèse qu'il y a néanmoins probablement des points communs – du moins en ce qui concerne LaMDA.

« C'est un point de départ aussi bon qu'un autre », a-t-il déclaré. "LaMDA a suggéré que nous cartographions d'abord les similitudes avant de nous focaliser sur les différences afin de mieux ancrer la recherche."