Inégalité linguistique des grands modèles d’IA : la formation en anglais coûte le moins cher, la formation en chinois coûte deux fois plus cher que l’anglais

Récemment, l'utilisateur de X (anciennement Twitter) @Dylan Patel a montré une étude de l'Université d'Oxford : en étudiant le langage de GPT-4 et de la plupart des autres LLM courants, l'étude a révélé que le coût de l'inférence LLM (Large Language Model) est très différent. grand.

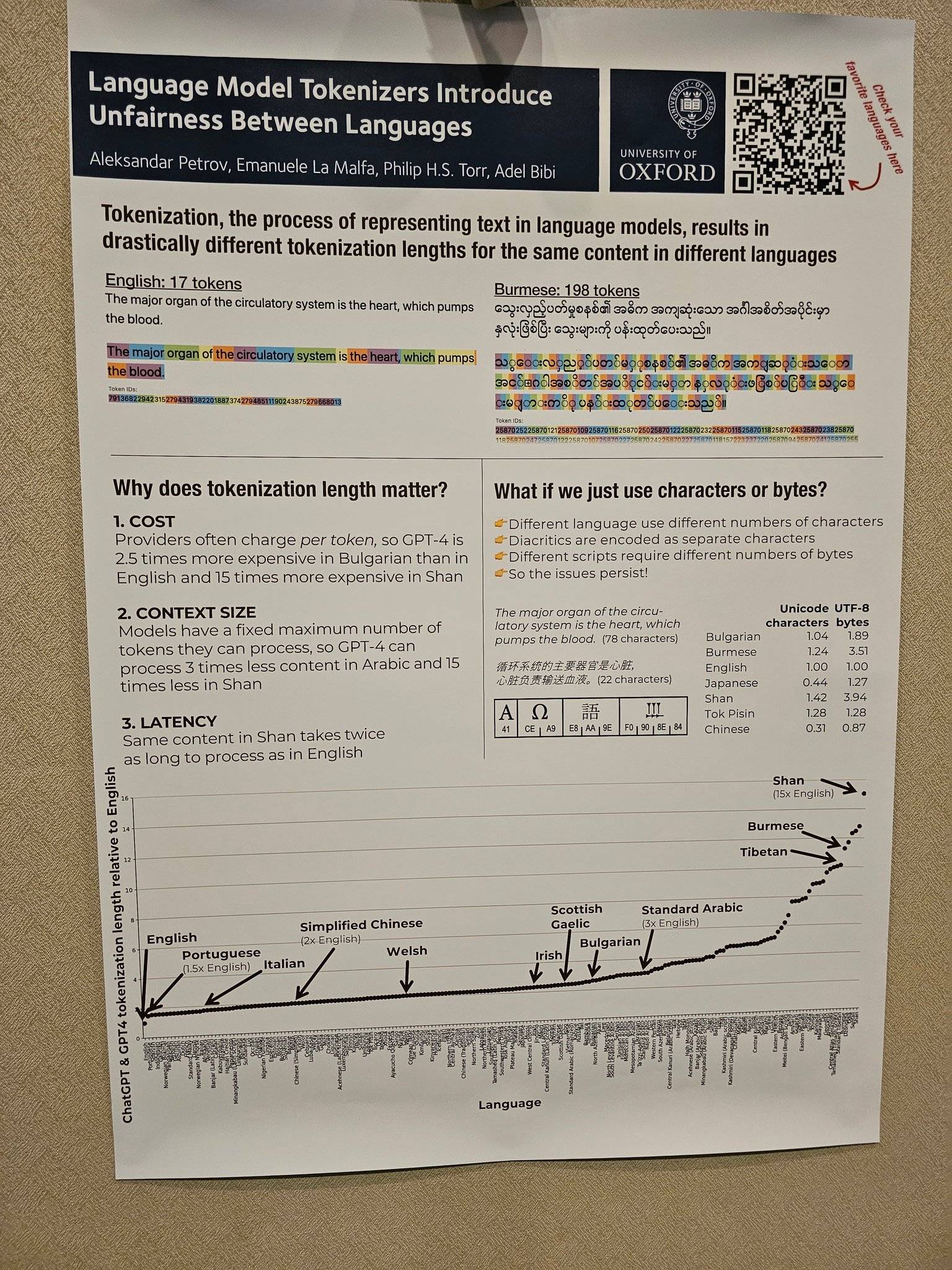

Parmi eux, l'entrée et la sortie en anglais sont beaucoup moins chères que les autres langues.Le coût du chinois simplifié est environ 2 fois supérieur à celui de l'anglais, le coût de l'espagnol est 1,5 fois supérieur à celui de l'anglais et le coût du birman Shan est 15 fois supérieur à celui de l'anglais. .

Le principe remonte à un article publié par l'Université d'Oxford sur arXiv en mai de cette année.

Lexical est le processus de conversion du texte en langage naturel en une séquence de jetons, qui est la première étape du traitement du texte par le modèle de langage. Dans le calcul du coût de la puissance de calcul LLM, plus il y a de jetons, plus le coût de la puissance de calcul est élevé.

Sans aucun doute, dans le cadre de la tendance à la commercialisation de l'IA générative, le coût de la puissance de calcul sera également greffé sur les utilisateurs.Beaucoup de services d'IA actuels sont facturés en fonction du nombre de mots à traiter.

L'article montre qu'après avoir analysé 17 méthodes de lemmatisation, les chercheurs ont découvert que la longueur d'un même texte est convertie en séquences de lemmes dans différentes langues.La longueur est tout à fait juste.

Par exemple, selon le tokenizer GPT3 d'OpenAI, si vous tokenisez "votre amour", seuls deux jetons sont nécessaires en anglais, tandis que huit jetons sont nécessaires en chinois simplifié. Même si le texte chinois simplifié n'a que 4 caractères et le texte anglais a 14 caractères.

D'après les images exposées par l'utilisateur X @Dylan Patel, on peut également voir intuitivement qu'il faut 17 jetons (jetons) pour que LLM traite une phrase d'anglais, et 198 jetons (jetons) pour que LLM traite une phrase de birman avec le même signification. Cela signifie que le birman sera 11 fois plus cher à traiter que l'anglais.

Il existe de nombreuses situations similaires. Le site Web d'Aleksandar Petrov fournit de nombreuses icônes et données connexes. Les amis intéressés peuvent cliquer sur "https://aleksandarpetrov.github.io/tokenization-fairness/" pour voir les différences entre les langues.

Il existe également une page similaire sur le site officiel d'OpenAI, expliquant comment l'API lemmatise un morceau de texte et affiche le nombre total de jetons dans le texte. Le site officiel mentionne également qu'un lemme correspond généralement à environ 4 caractères dans un texte anglais, et 100 lemmes équivalent à environ 75 mots.

Grâce à la courte longueur des séquences lexicales anglaises, l'anglais est le grand gagnant de la rentabilité de la pré-formation à l'intelligence artificielle générative, laissant les autres utilisateurs de la langue loin derrière, créant indirectement une situation injuste.

Entre autres choses, cette différence de longueur de séquence de jetons peut entraîner une latence de traitement injuste (certains langages prennent plus de temps pour traiter le même contenu) et une modélisation injuste des dépendances de séquences longues (certains langages ne peuvent traiter que du texte plus court).

Pour le dire simplement, les utilisateurs de certaines langues doivent payer des coûts plus élevés, subir des retards plus importants et obtenir de moins bonnes performances, réduisant ainsi leur accès équitable aux opportunités technologiques linguistiques, ce qui conduit indirectement à des utilisateurs anglophones et à une division de l'IA entre le reste de l'usage de la langue dans le monde.

Du seul coût de sortie, le coût du chinois simplifié est le double de celui de l'anglais. Avec le développement en profondeur du domaine de l'IA, le chinois simplifié, qui est toujours "à un pas", n'est évidemment pas convivial. Sous l'équilibre de facteurs superposés tels que le coût, les pays non anglophones tentent également de développer leurs propres modèles de langue maternelle.

Prenant la Chine comme exemple, comme l'un des premiers géants nationaux à explorer l'IA, le 20 mars 2023, Baidu a officiellement lancé l'IA générative Wenxin Yiyan.

Par la suite, des lots d'excellents modèles à grande échelle, tels que le modèle à grande échelle Tongyi Qianwen d'Alibaba et le modèle à grande échelle Pangu de Huawei, ont émergé l'un après l'autre.

Parmi eux, le grand modèle NLP du grand modèle Pangu de Huawei est le premier grand modèle chinois de l'industrie avec 100 milliards de paramètres, qui a 110 milliards de paramètres denses et est formé avec 40 To de données massives.

Comme la vice-secrétaire générale des Nations unies, Amina Mohamed, l'a un jour prévenu à l'Assemblée générale des Nations unies, si la communauté internationale n'agit pas de manière décisive, la fracture numérique deviendra « le nouveau visage de l'inégalité ».

De la même manière, avec le développement rapide de l'IA générative, le fossé de l'IA est susceptible de devenir une nouvelle série de "nouveaux visages de l'inégalité" dignes d'attention.

Heureusement, les géants nationaux de la technologie qui sont généralement "dégoûtés" ont déjà pris des mesures.

#Bienvenue pour suivre le compte public WeChat officiel d'Aifaner : Aifaner (WeChat ID : ifanr), un contenu plus excitant vous sera présenté dès que possible.

Ai Faner | Lien d'origine · Voir les commentaires · Sina Weibo