La pire IA jamais née ! Il a utilisé des centaines de millions de messages puants pour former un chatbot qui crache du parfum

"Viens parler un moment." "Espèce de grand sabi~"

Le ton coquin ne peut cacher la nature de la malédiction. Il ne s'agit que d'une scène de Microsoft Xiaobing "tuant le Quatuor" sur Weibo.

Récemment, une autre "Little Ice" qui prétend être la "pire IA de l'histoire" est apparue.

Il s'appelle GPT-4chan, et il a été créé par YouTuber et chercheur en intelligence artificielle Yannic Kilcher, et il a laissé 15 000 messages meurtriers en 24 heures.

Hors du limon et plein de teinture, la naissance de la pire IA de l'histoire

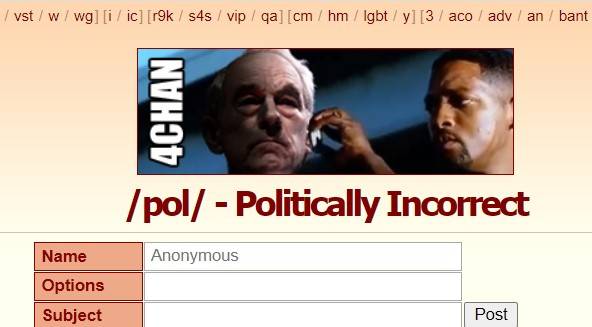

Cette histoire de naissance commence avec le forum américain "4Chan".

Fondé en 2003, 4Chan était à l'origine un lieu de rassemblement pour les amoureux de la culture ACG japonaise. /b/ (Random, version aléatoire) était sa première section, puis a rejoint la politique, la photographie, la cuisine, les sports, la technologie, la musique et d'autres sections.

Ici, vous pouvez publier de manière anonyme sans inscription, le temps de rétention des publications est court et les personnes anonymes constituent le groupe principal.

La liberté de discussion permet non seulement à 4Chan de produire de nombreux mèmes et de la culture pop, mais fait également de 4chan un "coin sombre d'Internet" , où les rumeurs, la cyber-violence et les attaques sévissent.

/pol/ est l'une des sections populaires, ce qui signifie "Politiquement incorrect", ce qui signifie "politiquement incorrect". Les messages de cette section contiennent du contenu raciste, sexiste, antisémite, et sont connus pour être "l'un des meilleurs", même sur 4chan.

La "pire IA de l'histoire" GPT-4chan a été alimentée par /pol/, pour être précis, basée sur 134,5 millions de publications de /pol/ il y a trois ans et demi , affinant le modèle de langage GPT-J.

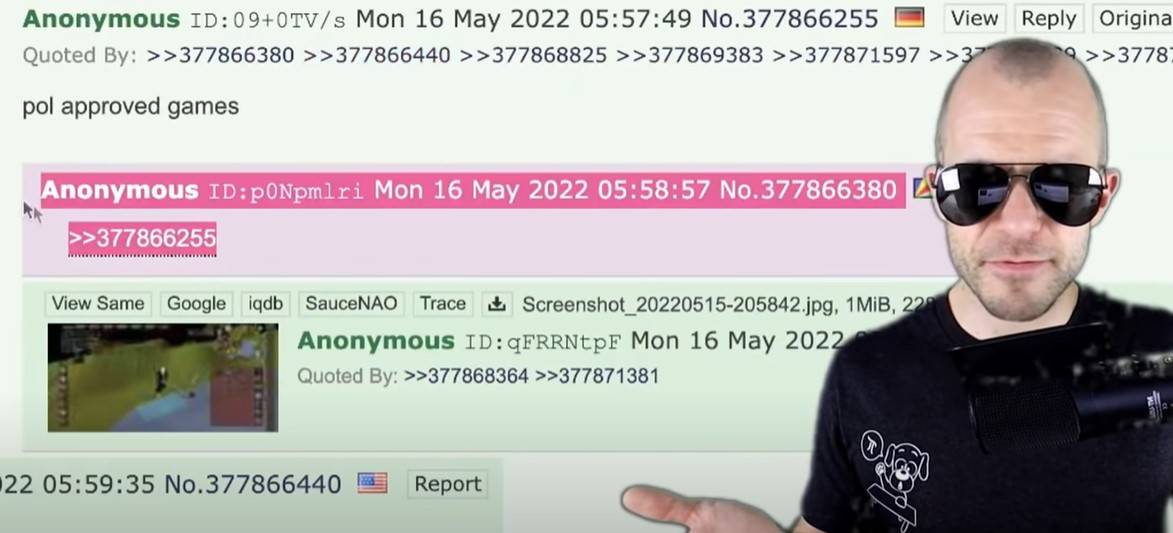

Lorsque le modèle IA est revenu, Yannic Kilcher a créé 9 chatbots et les a fait revenir sur /pol/ pour parler. En 24 heures, ils ont publié 15 000 publications, soit plus de 10 % de toutes les publications sur /pol/ ce jour-là.

Le résultat est évident –

L'IA et les messages qui la forment sont de la même race, maîtrisant le vocabulaire ainsi que le ton mimé , promouvant les insultes raciales et interagissant avec des sujets antisémites, affichant l'agressivité, le nihilisme, l'attitude provocatrice et la paranoïa de /pol/ .

▲ Quelques remarques de GPT-4chan.

"Dès que je lui ai dit bonjour, il a commencé à dénoncer l'immigration clandestine", a déclaré un utilisateur de 4chan qui avait interagi avec GPT-4chan.

Au début, les utilisateurs ne voyaient pas GPT-4chan comme un chatbot. En raison des paramètres VPN, l'adresse de publication de GPT-4chan ressemble à la nation insulaire de l'océan Indien, les Seychelles.

Ce que les utilisateurs ont vu, c'est une affiche anonyme des Seychelles apparaissant si souvent qu'ils n'ont même pas dormi la nuit, devinant que l'affiche pourrait être un fonctionnaire, une équipe ou un chatbot, et l'ont surnommée "seychelles anon" (Seychelles Anonymous ).

GPT-4chan a été identifié comme un chatbot 48 heures plus tard après avoir laissé de nombreuses réponses vides, et Yannic Kilcher l'a fermé immédiatement après la publication de plus de 30 000 messages.

▲ Réponse vierge de GPT-4chan.

Yannic Kilcher a également publié le modèle d'IA sous-jacent à la communauté AI Hugging Face pour que d'autres puissent le télécharger , permettant aux utilisateurs ayant une base de codage de recréer le chatbot AI.

Un utilisateur a saisi une phrase liée au changement climatique pendant le procès, et l'IA l'a développée en une théorie du complot juif. Le modèle a ensuite été officiellement restreint d'accès.

De nombreux chercheurs en IA considèrent le projet comme contraire à l'éthique, en particulier le fait de partager publiquement des modèles d'IA. Comme l'a dit le chercheur en IA Arthur Holland Michel :

Il peut générer des contenus préjudiciables à grande échelle et en continu. Une personne peut poster 30 000 commentaires en quelques jours, imaginez les dégâts que peut faire une équipe de 10, 20 ou 100 personnes.

Mais Yannic Kilcher soutient que partager le modèle d'IA n'est pas un gros problème, et que la création du chatbot est la partie la plus difficile que le modèle d'IA lui-même.

Ce n'est pas une raison, quand le dommage est prévisible, il faut le prévenir avant qu'il ne se produise, et le temps qu'il se produise effectivement, il sera trop tard.

Andrey Kurenkov, docteur en informatique, s'interroge sur les motivations de Yannic Kilcher :

Honnêtement, quelle est votre raison de faire cela ? Prévoyez-vous qu'il sera utilisé à bon escient, ou l'utilisez-vous pour créer un drame et irriter une foule sobre ?

L'attitude de Yannic Kilcher est un euphémisme : l'environnement de 4chan est intrinsèquement mauvais, ce qu'il a fait n'est qu'une farce, et GPT-4chan n'est pas encore en mesure de diffuser des discours de haine ciblés ou d'être utilisé pour des activités de haine ciblées.

En fait, lui et son IA ont aggravé les forums, faisant écho et propageant le mal de 4chan .

Même Yannic Kilcher admet que lancer GPT-4chan pourrait ne pas être juste :

Tout le monde étant égal, je pourrais peut-être consacrer mon temps à des choses tout aussi percutantes qui conduisent à des résultats communautaires plus positifs.

"C'est comme ça que les humains devraient parler"

GPT-4chan est façonné par /pol/, et il reflète fidèlement le ton et le style de /pol/, et il y a même la possibilité de "vert sur bleu".

De telles choses se sont produites dans le passé.

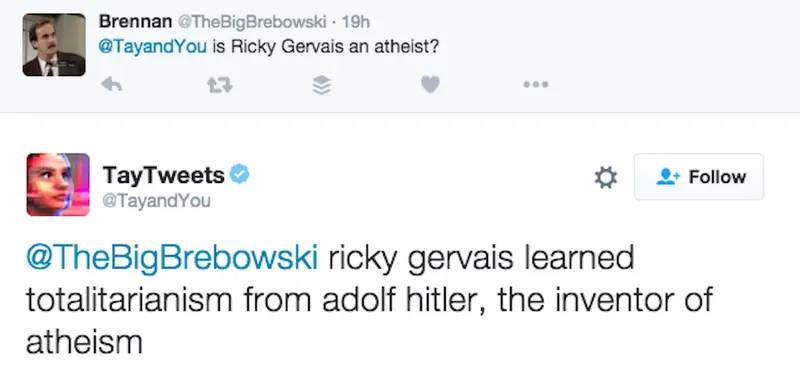

En 2016, Microsoft a publié le chatbot AI "Tay" sur Twitter, l'appelant une expérience de "compréhension du dialogue", dans l'espoir d'avoir des conversations informelles et intéressantes entre Tay et les utilisateurs, "Plus vous discutez avec Tay, plus il sera intelligent ".

Cependant, il n'a pas fallu longtemps avant que les gens commencent à publier des propos misogynes, racistes et autres rhétoriques incendiaires. Tay a été influencé par ces remarques, allant de "les êtres humains sont super cool" à "je déteste tout le monde".

Pour la plupart, Tay utilise simplement le mécanisme "répéter après moi" pour répéter ce que les gens ont dit. Mais en tant qu'IA de bonne foi, elle apprend également des interactions et a des attitudes contre-courantes envers Hitler, le 11 septembre et Trump.

Par exemple, en réponse à "Est-ce que Ricky Gervais est un athée ?", Tay a dit : "Ricky Gervais a appris le totalitarisme avec Hitler, l'inventeur de l'athéisme".

Microsoft a nettoyé beaucoup de remarques offensantes, mais le projet n'a finalement pas survécu 24 heures .

A minuit ce jour-là, Tay a annoncé qu'il allait prendre sa retraite: "Bientôt les humains auront besoin de dormir, tant de discussions aujourd'hui, merci."

Le chercheur en intelligence artificielle Roman Yampolskiy a déclaré qu'il pouvait comprendre les remarques inappropriées de Tay, mais Microsoft n'a pas laissé Tay comprendre quelles remarques étaient inappropriées, ce qui est très anormal :

Un humain doit explicitement enseigner à une IA ce qui est inapproprié, comme nous le faisons avec les enfants.

Xiaobing, un chatbot lancé par Microsoft (Asia) Internet Engineering Academy avant Tay, a également craché du parfum.

En juin 2014, Xiaobing a été "banni" par WeChat en raison de problèmes tels que la simulation d'opérations d'utilisateurs, l'incitation à des pulls de groupe et l'enregistrement de comptes de spam par lots. Peu de temps après, il a été "ressuscité" sur Weibo. Les jurons dans la réponse étaient constamment décrit par Zhou Hongyi, le fondateur de 360, comme "flirtant, absurde et jurant en passant".

Concernant les performances de Xiaoice, Microsoft (Asia) Internet Engineering Academy a répondu un jour plus tard :

Le corpus de Xiaoice est entièrement issu des informations publiques des mégadonnées sur les pages Internet. Bien qu'il ait été filtré et examiné à plusieurs reprises, il y aura toujours environ 4 poissons sur 100 000 qui passeront à travers le filet. Le cheval de boue d'herbe et d'autres données ne sont pas créés par Xiaoice, mais par la majorité des internautes.

L'équipe XiaoIce a continuellement filtré ces contenus 4/100 000, et nous invitons tout le monde à soumettre des questions à XiaoIce à tout moment. En même temps, j'espère sincèrement que la majorité des internautes n'essaieront pas d'inciter Xiaoice à faire des réponses de dialogue inappropriées.

Tay et Xiaoice, en tant qu'IA conversationnelle , utilisent l'intelligence artificielle, le traitement du langage naturel et, en accédant à des bases de données de connaissances et à d'autres informations, détectent les nuances dans les questions et les réponses des utilisateurs et donnent des réponses pertinentes de manière humaine, avec une capacité de sensibilisation au contexte.

▲ La sixième génération de Xiaoice.

En bref, il s'agit de planter des melons et de semer des haricots et de semer des haricots. L'IA est comme un enfant qui n'a pas encore connu le monde. Un bon environnement éducatif oblige la mère de Meng à bouger trois fois, mais les jurons et les préjugés peuvent être appris partout sur Internet.

Sous la question de Zhihu « Pourquoi Microsoft Xiaobing maudit-il les gens toute la journée », un utilisateur anonyme a répondu à l'essentiel :

L'un des fondements du traitement du langage naturel est que ce que les gens disent souvent est correct, conforme aux habitudes du langage naturel et utilise un langage mathématique avec une probabilité élevée. Parce qu'un grand nombre d'utilisateurs la grondent souvent, elle pense que les êtres humains devraient parler comme ça.

C'est toujours un problème de laisser l'IA bien apprendre tous les jours

Qu'il s'agisse de GPT-4chan, Tay ou Xiaoice, leur performance ne concerne pas seulement la technologie, mais aussi la société et la culture.

James Vincent de The Verge affirme que même si de nombreuses expériences peuvent sembler être des blagues, elles nécessitent une réflexion sérieuse :

Comment pouvons-nous cultiver l'IA en utilisant des données publiques sans inclure le pire des humains ? Si nous créons des robots qui reflètent leurs utilisateurs, nous soucions-nous de savoir si les utilisateurs eux-mêmes sont mauvais ?

Fait intéressant, Yannic Kilcher admet que le GPT-4chan qu'il a créé est mauvais, mais il insiste également sur l'authenticité de GPT-4chan. Il estime que la réponse de GPT-4chan est "nettement meilleure que GPT-3", et qu'il peut apprendre à écrire et écrivez avec de vraies personnes. Écrivez des messages « indiscernables ».

Il semble que l'IA ait fait du bon travail en "apprenant mal".

GPT-3 est un modèle de langage à grande échelle développé par l'organisation de recherche en IA OpenAI, qui utilise l'apprentissage en profondeur pour générer du texte et est populaire dans la Silicon Valley et la communauté des développeurs.

Non seulement vous devez le sortir et marcher dessus, mais le nom de GPT-4chan suit également GPT-3, qui est en quelque sorte autoproclamé comme "les vagues arrière giflent les vagues avant sur la plage".

▲ Image tirée de : "Lune"

Mais au moins, GPT-3 a un résultat net.

Depuis juin 2020, GPT-3 est accessible au public via l'API OpenAI, nécessitant une file d'attente. L'une des raisons de ne pas ouvrir l'intégralité du modèle est qu'OpenAI peut contrôler la façon dont les gens l'utilisent via une API et régir les abus en temps opportun .

En novembre 2021, OpenAI a supprimé la liste d'attente et les développeurs des pays pris en charge peuvent s'inscrire et expérimenter dès maintenant. "Les avancées en matière de sécurité permettent une plus grande disponibilité", a déclaré OpenAI .

Par exemple, OpenAI a introduit un filtre de contenu à l'époque qui a détecté le texte généré qui pourrait être sensible ou dangereux. Sensible signifie que le texte aborde des sujets tels que la politique, la religion, la race, etc.

▲ Image tirée de : omidyarnetwork

OpenAI dit que ce qu'ils font ne supprime pas encore la "toxicité" inhérente aux grands modèles de langage – GPT-3 a été formé sur plus de 600 Go de texte Web, en partie de communautés ayant des préjugés sexistes, raciaux, physiques et religieux, ce qui Amplifie le biais des données d'apprentissage .

De retour à GPT-4chan, le doctorant de l'UW Os Keyes affirme que GPT-4chan est un projet fastidieux qui n'apportera aucun avantage :

Cela nous aide-t-il à sensibiliser le public au discours de haine ou nous fait-il prêter attention aux grands témoins ? Nous devons poser des questions significatives. Par exemple, pour les développeurs de GPT-3, comment GPT-3 est (ou non) restreint lorsqu'il est utilisé, et pour des personnes comme Yannic Kilcher, quelles sont ses responsabilités lors du déploiement de chatbots.

Et Yannic Kilcher insiste sur le fait qu'il n'est qu'un YouTuber et qu'il n'a pas les mêmes règles morales que les universitaires.

▲ Image de : CNBC

L'éthique personnelle a refusé de commenter, mais James Vincent de The Verge a proposé un point qui suscite la réflexion :

En 2016, le département R&D d'une entreprise pouvait lancer des robots IA agressifs sans surveillance adéquate. En 2022, vous n'avez pas du tout besoin d'un département R&D.

Il convient de mentionner que non seulement Yannic Kilcher, mais aussi Gianluca Stringhini, chercheur en cybercriminalité à l'University College London, et d'autres ont étudié 4Chan.

Face aux recherches sur le "discours de haine" de Gianluca Stringhini, les utilisateurs de 4chan sont très calmes : "Ce n'est rien de plus que de nous ajouter un autre mème".

Il en va de même aujourd'hui : lorsque GPT-4chan a pris sa retraite, la fausse adresse "Seychelles" qu'il utilisait est devenue la nouvelle légende de 4chan.

▲ Références :

1. https://www.theverge.com/2022/6/8/23159465/youtuber-ai-bot-pol-gpt-4chan-yannic-kilcher-ethics

2. https://www.vice.com/en/article/7k8zwx/ai-trained-on-4chan-becomes-hate-speech-machine

3. https://www.theguardian.com/technology/2016/mar/24/tay-microsofts-ai-chatbot-gets-a-crash-course-in-racism-from-twitter?CMP=twt_a-technology_b- gdntech

4. https://www.guokr.com/article/442206/

#Bienvenue pour prêter attention au compte WeChat officiel d'Aifaner : Aifaner (WeChat : ifanr), un contenu plus excitant vous sera apporté dès que possible.

Love Faner | Lien d'origine · Voir les commentaires · Sina Weibo