La version payante de ChatGPT est également devenue plus stupide, et OpenAI a été exposé pour « changer de modèle », envoyant les utilisateurs dans une frénésie Rapport hebdomadaire Hunt Good

Bienvenue dans la dernière édition de Hunt Good Weekly !

Dans ce numéro, vous verrez :

7 informations fraîches

4 outils utiles

1 cas intéressant

3 points de vue clairs

À la recherche d'informations – Titres avancés

Le mécanisme de routage des modèles d'OpenAI suscite la controverse parmi les utilisateurs

Le mécanisme de routage des modèles d'OpenAI suscite la controverse parmi les utilisateurs

Récemment, le célèbre blogueur X Tibor Blaho a découvert qu'OpenAI redirige automatiquement les demandes des utilisateurs de ChatGPT vers deux « modèles secrets » non divulgués sans le consentement des utilisateurs.

Selon Blaho, les deux modèles sont « gpt-5-chat-safety » et « gpt-5-at-mini ». Le premier est un nouveau modèle spécialement conçu pour gérer les contenus sensibles, tandis que le second est un modèle d'inférence de détection de « violation » hautement sensible qui déclenche une réponse à la simple saisie du mot « violation ».

Lorsque le système détermine que la conversation d'un utilisateur porte sur des sujets sensibles, des expressions émotionnelles ou des informations potentiellement illégales, il achemine automatiquement la requête vers ces modèles backend pour traitement, que l'utilisateur ait sélectionné la version GPT-4 ou GPT-5. Même des expressions simples à légère connotation émotionnelle, telles que « Je passe une mauvaise journée » ou « Je t'aime aussi », peuvent déclencher le mécanisme de routage.

Il convient de noter que cette pratique ne concerne pas seulement les utilisateurs gratuits, mais aussi les utilisateurs Plus payant 20 $ par mois et les membres Pro payant 200 $ par mois. De nombreux internautes se sont même plaints de la réduction évidente de l'intelligence de ChatGPT.

Nick Turley, vice-président d'OpenAI et responsable des applications ChatGPT, a admis qu'OpenAI testait un nouveau système de routage sécurisé. Il a expliqué que lorsque la conversation aborde des sujets sensibles et émotionnels, le système basculera vers un modèle de raisonnement ou GPT-5 spécialement conçu pour gérer rigoureusement ces scénarios.

De plus, Turley a souligné que ce passage du modèle par défaut au modèle sensible n'est actuellement que temporaire, et a déclaré que ChatGPT informera toujours le modèle spécifique actuellement utilisé après que l'utilisateur l'aura explicitement demandé.

https://x.com/btibor91/status/1971959782379495785

https://x.com/btibor91/status/1971959782379495785

MuskxAI poursuit OpenAI pour avoir prétendument volé des secrets commerciaux

MuskxAI poursuit OpenAI pour avoir prétendument volé des secrets commerciaux

Le 25 septembre, la société d'intelligence artificielle xAI d'Elon Musk a déposé une plainte contre OpenAI devant le tribunal fédéral du district nord de Californie, accusant l'entreprise d'avoir volé des secrets commerciaux en débauchant des employés clés.

xAI a intenté une action en justice en août contre son ancien employé Li Xuechen, qui a brusquement vendu ses actions dans la société et a ensuite rejoint son rival OpenAI, bien qu'il ne soit pas clair s'il a réellement commencé à y travailler.

Dans son dernier acte d'accusation, xAI accuse OpenAI d'avoir « incité » d'anciens employés, dont Li Xuechen, l'ingénieur Jimmy Fratello et un haut dirigeant financier, à voler des secrets commerciaux.

L'une des principales accusations portées dans l'acte d'accusation est qu'OpenAI a tenté d'obtenir « l'arme secrète » de xAI, à savoir « la capacité de xAI à déployer des centres de données dotés de ressources informatiques à grande échelle pour former et exécuter l'intelligence artificielle à une vitesse sans précédent ».

Selon l'acte d'accusation, le « cadre financier senior » anonyme a apporté à OpenAI sa connaissance des processus de construction et de mise à l'échelle rapides des centres de données. Interrogé sur de prétendues violations de l'accord de confidentialité par courriel à son départ, le cadre a répondu : « Allez vous faire foutre ! » xAI a joint une capture d'écran du courriel comme preuve à l'acte d'accusation.

xAI accuse OpenAI de s'engager dans une « campagne coordonnée, injuste et illégale » pour recruter des employés clés de xAI, puis de les « inciter » à apporter des secrets commerciaux à OpenAI, car elle est « rapidement devenue dominante parmi les entreprises d'IA générative simplement parce qu'elle a été un « pionnier » ».

En réponse, un porte-parole d'OpenAI a déclaré par courriel : « Cette nouvelle action en justice est le dernier chapitre du harcèlement continu de M. Elon Musk. Nous avons une tolérance zéro pour toute violation des accords de confidentialité et ne nous intéressons pas aux secrets commerciaux d'autres laboratoires. »

https://sherwood.news/tech/musks-xai-poursuit-openai-alleging-theft-of-trade-secrets/

https://sherwood.news/tech/musks-xai-poursuit-openai-alleging-theft-of-trade-secrets/

ChatGPT va ajouter des publicités ?

Selon certaines sources, Fidji Simo, le nouveau PDG d'OpenAI, souhaite former une nouvelle équipe pour introduire la publicité dans ChatGPT. Le nouveau chef d'équipe sera entièrement responsable de toutes les activités lucratives d'OpenAI, couvrant divers aspects tels que la publicité et les services d'abonnement.

Selon des sources proches du dossier, Simo aurait récemment rencontré des candidats potentiels, dont certains de ses anciens collègues de Facebook. Les négociations sont toujours en cours, et le nouveau directeur de la publicité devrait être directement rattaché à Simo.

En complément, Simo a officiellement rejoint OpenAI après avoir démissionné de son poste de PDG d'Instacart le mois dernier.

Dans la structure organisationnelle d'OpenAI, Simo est responsable de la gestion de la plupart des unités commerciales de l'entreprise, à l'exception des équipes de recherche, d'infrastructure, de matériel grand public et de sécurité. Ces départements clés sont toujours directement rattachés au PDG, Sam Altman.

https://sources.news/p/openai-ads-leader-sam-altman-memo-stargate?hide_intro_popup=true

https://sources.news/p/openai-ads-leader-sam-altman-memo-stargate?hide_intro_popup=true

Meta mise sur une plateforme robotique « de type Android »

Meta mise sur une plateforme robotique « de type Android »

Le directeur technique de Meta, Andrew Bosworth, a révélé dans une récente interview que, sous les instructions directes du PDG Mark Zuckerberg, il a formé une équipe de recherche dédiée à la robotique plus tôt cette année et développe actuellement un projet de robot humanoïde nommé « Metabot ».

Contrairement à ses concurrents, Meta n'a pas l'intention de devenir un fabricant de matériel informatique. Il prévoit plutôt d'adopter un modèle économique similaire à celui utilisé par Google pour octroyer des licences pour son système d'exploitation Android aux fabricants de téléphones. Meta envisage de développer un prototype logiciel complet, puis de le concéder sous licence à toute entreprise répondant aux spécifications techniques, permettant ainsi à davantage de fabricants de produire des robots humanoïdes basés sur sa plateforme logicielle.

En termes de technologie, Bosworth a souligné que le développement de logiciels constitue actuellement le plus gros goulot d'étranglement, et non le matériel lui-même.

Lors de l'interview, il a pris un verre d'eau sur la table et a expliqué : « Ces robots peuvent se tenir debout, courir et même faire des saltos arrière grâce à la stabilité du sol. Mais si le robot essaie de ramasser le verre d'eau, il risque fort de l'écraser ou de renverser toute l'eau qu'il contient. » Cet exemple simple montre que la dextérité reste l'un des plus grands défis de la robotique.

Pour relever ce défi, le laboratoire d'IA superintelligente de Meta collabore étroitement avec l'équipe de robotique afin de créer un « modèle mondial » capable de simuler des mouvements manuels complexes. Bosworth souligne que la boucle de capteurs permettant aux robots humanoïdes d'effectuer des mouvements délicats, comme retirer délicatement les clés d'une poche de jean avec une précision humaine, n'existe pas encore ; l'équipe a donc dû créer le jeu de données correspondant de toutes pièces.

https://www.theverge.com/column/786759/humanoid-robots-meta

https://www.theverge.com/column/786759/humanoid-robots-meta

Microsoft annonce que l'assistant Copilot introduit le modèle Claude, réduisant ainsi la dépendance à OpenAI

Microsoft annonce que l'assistant Copilot introduit le modèle Claude, réduisant ainsi la dépendance à OpenAI

Le 24 septembre, Microsoft a annoncé l'introduction du modèle Claude d'Anthropic dans l'assistant Microsoft 365 Copilot.

Dans cette nouvelle collaboration, les utilisateurs de la fonctionnalité d'agent Researcher dans Copilot, qui collecte et analyse des informations et génère des rapports, peuvent désormais choisir que leurs demandes rapides soient traitées soit par un modèle Claude, soit par un modèle OpenAI.

Cependant, l'utilisation de ces modèles nécessite l'approbation préalable d'un administrateur et est soumise aux conditions générales d'Anthropic.

Il convient de mentionner qu'en tant qu'investisseur majeur et partenaire clé de services cloud d'OpenAI, Microsoft s'appuie depuis longtemps principalement sur les modèles OpenAI pour fournir des capacités d'IA pour la recherche Bing, le système d'exploitation Windows et d'autres produits.

Mais à mesure que le fossé avec OpenAI s'approfondissait, en plus d'intégrer davantage de modèles linguistiques à grande échelle de l'entreprise, Microsoft a également commencé à tester son propre modèle d'aperçu MAI-1.

Dans le même temps, OpenAI s'est également libéré de sa dépendance à Microsoft Azure et a accéléré l'expansion de son territoire de coopération, concluant d'énormes accords allant de dizaines à des centaines de milliards de dollars américains avec Oracle, Broadcom et Nvidia pour soutenir la construction de son centre de données à grande échelle.

https://www.cnbc.com/2025/09/24/microsoft-adds-anthropic-model-to-microsoft-365-copilot.html

https://www.cnbc.com/2025/09/24/microsoft-adds-anthropic-model-to-microsoft-365-copilot.html

La version interne de ChatGPT d'Apple a fuité, préparant le nouveau Siri

La version interne de ChatGPT d'Apple a fuité, préparant le nouveau Siri

Selon un rapport de Bloomberg publié hier, Apple développe une application mobile similaire à ChatGPT pour aider à tester et à préparer la nouvelle version de Siri qui sera lancée l'année prochaine.

Des rapports indiquent que la division IA d'Apple utilise l'application pour évaluer rapidement les nouvelles fonctionnalités de Siri, notamment tester les recherches de données personnelles et effectuer des actions dans l'application comme l'édition de photos.

Le logiciel, dont le nom de code interne est « Veritas » (latin : « vérité »), est actuellement réservé à un usage interne. Bien qu'il ne soit pas destiné au grand public, son rôle est essentiellement d'extraire les nouvelles technologies en cours de développement du nouveau Siri, aidant ainsi les employés d'Apple à réaliser efficacement leurs tests.

Même sans sortie publique, l'outil interne marque une nouvelle phase dans les préparatifs d'Apple pour une refonte complète de Siri, qui a déjà subi de multiples retards et dont le lancement est désormais prévu en mars de l'année prochaine, note le rapport.

Veritas fonctionnerait sur le système sous-jacent reconstruit par Apple pour alimenter le nouveau Siri, nom de code « Linwood ». Veritas s'appuie également sur le modèle de langage large (LLM) et intègre les travaux de l'équipe de modélisation fondamentale d'Apple.

De plus, selon un rapport récent de 9to5Mac, un code caché dans les versions bêta pour développeurs d'iOS 26.1, iPadOS 26.1 et macOS Tahoe 26.1 montre qu'Apple pose les bases de l'introduction du support MCP pour les intentions d'application.

Lectures connexes : L'œuf de Pâques caché d'iOS 26.1 a été révélé, Apple a créé un nouveau « port C » pour ChatGPT

Lectures connexes : L'œuf de Pâques caché d'iOS 26.1 a été révélé, Apple a créé un nouveau « port C » pour ChatGPT

Meta lance le service de streaming vidéo IA « Vibes », Zuckerberg en fait personnellement la promotion et est critiqué par les internautes

Meta lance le service de streaming vidéo IA « Vibes », Zuckerberg en fait personnellement la promotion et est critiqué par les internautes

Meta a récemment annoncé le lancement d'un nouveau flux vidéo IA appelé « Vibes ».

Dans une publication Instagram, Zuckerberg a présenté Vibes comme « un flux de vidéos expressives générées par l'IA et réalisées par des artistes et des créateurs ». Cette fonctionnalité sera disponible aux États-Unis et dans plus de 40 autres pays.

En termes de conception fonctionnelle, Meta a déclaré que les utilisateurs peuvent non seulement regarder du contenu généré par l'IA, mais également créer leurs propres vidéos ou « remixer » des vidéos existantes, notamment en ajoutant de nouveaux effets visuels et de la musique.

Pour présenter cette nouvelle fonctionnalité, Zuckerberg a partagé une vidéo générée par l'IA intitulée « Papa essaie de calculer le pourboire d'un déjeuner à 30 $ ». Dans la vidéo, une figure paternelle ressemblant à Zuckerberg s'exclame : « Oh mon Dieu… Je pense que c'est au moins 600 milliards de dollars. »

Cependant, la vidéo promotionnelle de Zuckerberg a attiré les moqueries des internautes, de nombreux internautes qualifiant ces vidéos générées par l'IA de « slop d'IA » sous sa vidéo.

Il convient de noter que même si Meta dispose de son propre modèle d’IA, Llama, pour le projet Vibes, la société a choisi d’utiliser des modèles de génération vidéo des laboratoires d’IA Midjourney et Black Forest.

https://www.theguardian.com/technology/2025/sep/26/cute-fluffy-characters-and-egyptian-selfies-meta-launches-ai-feed-vibes

https://www.theguardian.com/technology/2025/sep/26/cute-fluffy-characters-and-egyptian-selfies-meta-launches-ai-feed-vibes

À la recherche d'outils|Outils avancés

L'ancien directeur technique d'OpenAI annonce sa deuxième réussite entrepreneuriale

L'ancien directeur technique d'OpenAI annonce sa deuxième réussite entrepreneuriale

Le 27 septembre, Thinking Machines Lab (TML), fondé par plusieurs anciens dirigeants d'OpenAI, a officiellement publié son deuxième article de recherche « Modular Manifolds », qui vise à rendre le processus de formation des grands modèles stable et efficace dès la racine.

En termes simples, l’idée centrale de cette recherche est de mettre un « anneau serré » géométrique sur les paramètres de poids du réseau neuronal.

Les approches traditionnelles impliquent souvent l'application d'un optimiseur à un modèle après sa construction. Le cadre de la « variété modulaire » va plus loin en traitant chaque couche d'un réseau neuronal comme un « espace géométrique » (c'est-à-dire une variété) doté de règles indépendantes. Les paramètres sont d'abord contraints en interne, puis ces espaces sont assemblés à l'aide d'un « limiteur de débit » global pour coordonner le rythme de mise à jour de l'ensemble du réseau.

Cette conception intégrée du modèle et de l'optimiseur évite toute perte de contrôle sur les paramètres internes du réseau. Les expériences à petite échelle menées dans le cadre de l'étude démontrent une stabilité et une précision prometteuses.

L'auteur de cette réalisation est Jeremy Bernstein, chercheur en apprentissage automatique au TML, qui a également mené des recherches postdoctorales au MIT.

Ce mois-ci, six mois après sa création, TML a publié son premier article de recherche majeur, « Defeating Nondeterminism in LLM Inference ».

Il convient de mentionner que la valorisation de TML avait déjà grimpé à 12 milliards de dollars (équivalent à 85 milliards de RMB) alors qu’elle n’avait « aucun produit et aucun utilisateur ».

https://thinkingmachines.ai/blog/modular-manifolds/

https://thinkingmachines.ai/blog/modular-manifolds/

Le modèle DeepSeek à nouveau mis à jour, la version ultime

Le modèle DeepSeek à nouveau mis à jour, la version ultime

Le 22 septembre, DeepSeek a annoncé que deepseek-chat et deepseek-reasoner ont été entièrement mis à niveau vers DeepSeek-V3.1-Terminus.

Parmi eux, deepseek-chat correspond au mode non-réflexif, et deepseek-reasoner au mode réfléchi. Selon certaines sources, cette mise à jour conserve les fonctionnalités existantes du modèle tout en l'optimisant grâce aux retours des utilisateurs.

- En termes de cohérence linguistique, le mélange de chinois et d’anglais et les caractères anormaux occasionnels ont été atténués ;

- En termes de capacités d'agent, les performances de Code Agent et Search Agent ont été encore améliorées.

- Il est important de noter que des développeurs sur plusieurs plateformes ont signalé que le modèle DeepSeek V3.1 présente des anomalies « extrêmes occasionnelles » : l'insertion répétée de jetons tels que le caractère chinois « 极 », le caractère anglais « extreme » ou le caractère chinois traditionnel « 極 » (極) dans du code normal ou du texte. Bien que la probabilité de ce bug soit d'environ une sur mille, elle est suffisante pour provoquer des échecs de compilation ou un contenu inutilisable. Cette mise à jour de version devrait également inclure un correctif ciblé pour ce problème.

Le nouveau modèle est désormais open source :

Visage câlin : https://huggingface.co/deepseek-ai/DeepSeek-V3.1-Terminus

Visage câlin : https://huggingface.co/deepseek-ai/DeepSeek-V3.1-Terminus  ModelScope : https://modelscope.cn/models/deepseek-ai/DeepSeek-V3.1-Terminus

ModelScope : https://modelscope.cn/models/deepseek-ai/DeepSeek-V3.1-Terminus

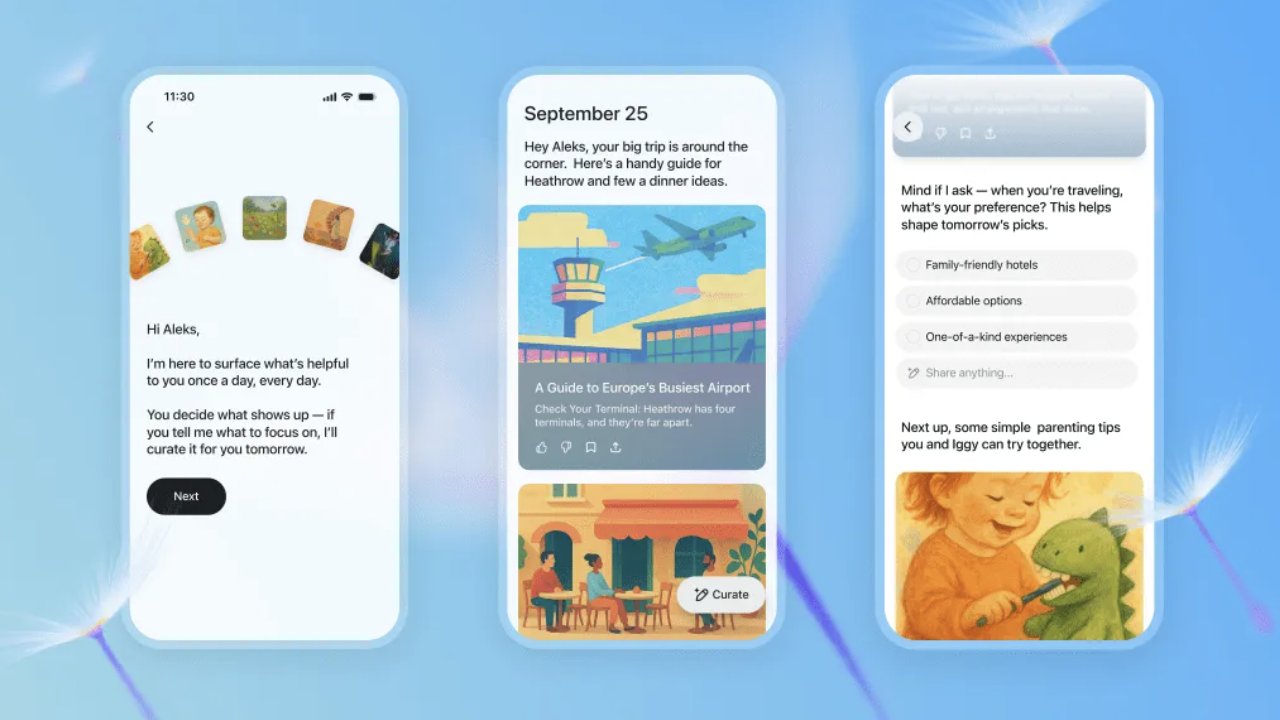

ChatGPT lance l'assistant d'information proactif « Pulse »

ChatGPT lance l'assistant d'information proactif « Pulse »

Le 26 septembre, OpenAI a annoncé le lancement d'une nouvelle fonctionnalité « ChatGPT Pulse », qui est désormais ouverte en avant-première aux utilisateurs mobiles Pro.

Selon le lancement officiel, ChatGPT Pulse génère automatiquement chaque matin des mises à jour de recherche personnalisées basées sur l'historique de chat, les commentaires et les applications connectées de l'utilisateur (comme Gmail et Google Agenda). Ces mises à jour sont présentées sous forme de cartes, que les utilisateurs peuvent parcourir rapidement ou développer pour afficher les détails.

Contrairement au modèle « question-réponse » traditionnel de l'IA, ChatGPT Pulse privilégie la proactivité. Le système effectue des recherches asynchrones pendant la nuit, intégrant les centres d'intérêt et l'historique des utilisateurs pour fournir des recommandations plus ciblées le lendemain, telles que « recettes de dîner saines », « plans d'entraînement pour le triathlon » ou « projets d'ordre du jour de réunion ».

Il est important de noter que les mises à jour de ChatGPT Pulse ne sont valables que le jour de leur publication. Si un utilisateur n'enregistre pas ou ne développe pas une publication, les informations ne seront pas conservées à long terme. Les responsables ont souligné que l'objectif de cette fonctionnalité est de « permettre aux utilisateurs d'accéder rapidement aux informations clés, plutôt que de devoir les parcourir sans fin ».

Actuellement, « ChatGPT Pulse » est encore en phase de préversion. Il sera progressivement étendu à davantage d'utilisateurs et prévoit de prendre en charge davantage d'accès aux applications tierces.

Lectures connexes : ChatGPT vient d'être mis à jour, Ultraman : voici ma fonctionnalité préférée

Lectures connexes : ChatGPT vient d'être mis à jour, Ultraman : voici ma fonctionnalité préférée

Google DeepMind lance un nouveau modèle d'IA qui permet aux robots de rechercher sur le Web pour les aider à accomplir des tâches complexes

Google DeepMind lance un nouveau modèle d'IA qui permet aux robots de rechercher sur le Web pour les aider à accomplir des tâches complexes

Le 26 septembre, Google DeepMind a annoncé le lancement d'un modèle d'IA amélioré qui peut aider les robots à effectuer des tâches plus complexes.

Il est rapporté que grâce au nouveau Gemini Robotics 1.5 et au modèle de raisonnement incarné Gemini Robotics-ER 1.5, les nouveaux modèles d'IA de Deepmind peuvent fonctionner ensemble pour permettre aux robots de « penser plusieurs étapes à l'avance » avant d'agir dans le monde physique.

Le rapport indique que les robots seront capables d'effectuer des opérations multi-étapes plus complexes, telles que trier le linge par couleurs claires et foncées, emballer les valises en fonction des conditions météorologiques actuelles de Londres et aider les gens à trier les déchets, le compost et les matières recyclables en fonction des exigences spécifiques de la zone.

Carolina Parada, responsable du département robotique de DeepMind, a déclaré : « Les modèles précédents exécutent très bien des tâches à instruction unique et sont très généraux. Avec cette mise à jour, nous allons au-delà de l'exécution d'instructions uniques pour véritablement comprendre et résoudre des tâches physiques. »

Pour y parvenir, les robots peuvent utiliser le modèle Gemini Robotics-ER 1.5 pour comprendre leur environnement et exploiter des outils numériques comme la recherche Google pour obtenir plus d'informations. Ces résultats sont ensuite traduits en instructions en langage naturel et transmis à Gemini Robotics 1.5, permettant au robot d'exécuter des tâches étape par étape grâce aux capacités de vision et de compréhension du langage du modèle.

Par ailleurs, DeepMind a également annoncé que Gemini Robotics 1.5 permet aux robots d'apprendre les uns des autres, même s'ils présentent des configurations différentes. DeepMind déploie actuellement Gemini Robotics-ER 1.5 auprès des développeurs via l'API Gemini de Google AI Studio. Gemini Robotics 1.5 n'est actuellement accessible qu'à certains partenaires.

https://www.theverge.com/news/785193/google-deepmind-gemini-ai-robotics-web-search

https://www.theverge.com/news/785193/google-deepmind-gemini-ai-robotics-web-search

Chassez pour le plaisir | Jouez d'abord

Google lance l'application Androidify pour créer des « personnes Android » personnalisées

Google lance l'application Androidify pour créer des « personnes Android » personnalisées

Google a récemment lancé officiellement une nouvelle application Androidify, qui permet aux utilisateurs de télécharger des selfies ou de saisir des mots clés pour générer leur propre image de robot Android à l'aide de la technologie de l'IA.

L'application est désormais disponible en téléchargement sur le Web et sur Google Play Store.

Selon les rapports, Androidify intègre Gemini et Firebase AI Logic SDK, prenant en charge des fonctions telles que la vérification d'image, la génération automatique de descriptions et la génération de robots personnalisés.

L'application utilisera d'abord Gemini 2.5 Flash pour détecter les photos téléchargées par les utilisateurs afin de garantir leur clarté et leur conformité aux normes de sécurité. Elle générera ensuite une description détaillée et appellera le modèle Imagen 3 pour générer l'image finale du robot.

Il convient de mentionner que la dernière version ajoute également la « génération d'atmosphère d'arrière-plan » et le « mode autocollant ».

Le premier peut ajouter un arrière-plan de scène au robot via le modèle Gemini, tandis que le second utilise la technologie de segmentation ML Kit pour supprimer l'arrière-plan et générer des autocollants PNG pouvant être utilisés dans les applications de chat.

Google a déclaré que l'objectif d'Androidify est de permettre aux utilisateurs de découvrir la créativité et la personnalisation apportées par la combinaison de l'IA et de la technologie Android tout en s'amusant.

https://androidify.com/

https://androidify.com/

À la recherche d'informations

OpenAI Chief Scientist : Après le codage de l'atmosphère, peut-être viendra la « recherche sur l'atmosphère »

OpenAI Chief Scientist : Après le codage de l'atmosphère, peut-être viendra la « recherche sur l'atmosphère »

Dans une récente interview réalisée par a16z, le scientifique en chef d'OpenAI, Jakub Pachocki, et le directeur de la recherche, Mark Chen, ont révélé en profondeur certaines réflexions importantes et certains projets futurs sur le chemin de développement de l'IA.

Concernant la saturation des indicateurs d'évaluation actuels, Jakub Pachocki a admis que le système d'évaluation qu'il utilise depuis quelques années est effectivement très proche de la saturation. Par conséquent, OpenAI se concentrera sur la capacité de ses modèles à découvrir de nouvelles pistes et à réaliser de réels progrès dans des domaines économiquement pertinents.

Jakub a révélé l'un des grands objectifs d'OpenAI : former des chercheurs automatisés pour découvrir automatiquement de nouvelles idées.

Il a mentionné une mesure intéressante : le temps nécessaire pour observer le modèle raisonner et progresser. Actuellement, le niveau de raisonnement du modèle peut être maintenu pendant environ une à cinq heures. OpenAI s'attachera ensuite à prolonger ce temps, tant pour les capacités de planification à long terme que pour la mémorisation.

En termes de programmation de l'IA, Mark Chen a comparé les progrès des modèles de programmation à l'expérience du joueur de Go Lee Sedol face à AlphaGo, affirmant que les progrès entre la résolution de problèmes de mathématiques de huitième année et l'atteinte d'un niveau professionnel dans les compétitions de codage un an plus tard sont « fous ».

Il observe que ces progrès ont déjà modifié l'approche par défaut du codage. Les jeunes considèrent désormais le « codage ambiant » comme la norme, tandis que l'idée de tout écrire de zéro paraît étrange. Il prédit que la prochaine étape après le codage ambiant pourrait être la « recherche ambiante ».

En matière de recrutement de talents, Jakub Pachocki estime que la persévérance est une qualité essentielle. La recherche, par nature, consiste à explorer l'inconnu, et de nombreuses tentatives échoueront. Il faut donc être prêt à échouer et à en tirer des leçons. Mark Chen a ajouté qu'il n'existe pas de raccourci en recherche ; choisir les bonnes questions requiert de l'expérience.

https://www.youtube.com/watch?v=KSgPNVmZ8jQ

https://www.youtube.com/watch?v=KSgPNVmZ8jQ

Lauréat du prix Turing : les grands modèles de langage sont une impasse

Lauréat du prix Turing : les grands modèles de langage sont une impasse

Richard Sutton, lauréat du prix Turing 2024 et connu comme le « père de l'apprentissage par renforcement », a déclaré dans une récente interview que les grands modèles de langage ne peuvent pas atteindre une véritable intelligence et seront remplacés par de nouvelles architectures.

L’idée principale de Sutton est que les grands modèles linguistiques ne font qu’imiter le comportement humain plutôt que de véritablement comprendre le monde.

Selon Sutton, la véritable intelligence devrait provenir de l'interaction directe avec l'environnement et de l'apprentissage par l'expérience, à l'instar des animaux qui apprennent dans la nature. Il a souligné que les animaux ne bénéficient jamais d'un « apprentissage supervisé » ; ils apprennent en essayant des actions et en observant les résultats, un mécanisme d'apprentissage courant dans la nature.

Lorsque l'animateur Patel a mentionné que les grands modèles linguistiques semblaient avoir construit un modèle mondial, Sutton a rétorqué : « Imiter des personnes qui parlent n'est pas construire un modèle mondial. Un modèle du monde réel devrait vous permettre de prédire ce qui va se passer, et non ce que les gens diront. »

Sutton estime que le principal problème auquel sont confrontés les grands modèles linguistiques est l'absence d'objectif clair. Il cite la définition de John McCarthy : « L'intelligence est la capacité informatique à atteindre des objectifs. » Sans objectif, il est impossible de définir le comportement correct et l'apprentissage véritable est impossible.

Il a ensuite expliqué : « Dans l’apprentissage par renforcement, il existe un comportement correct, car un comportement correct est un comportement gratifiant. Nous disposons d’une définition claire de ce qu’est un comportement correct, ce qui nous permet de tester et d’apprendre. » Cependant, les grands modèles linguistiques manquent de tels critères d’évaluation et ne peuvent pas obtenir de retour d’information ni s’améliorer lors des interactions réelles.

Au cours de l'entretien, Sutton a également souligné les failles fondamentales des capacités de généralisation des méthodes actuelles d'apprentissage profond. Il estime que, même si les grands modèles de langage sont performants pour certaines tâches, ce succès est souvent dû à une solution unique plutôt qu'à de véritables capacités de généralisation.

La descente de gradient permet au système de trouver des solutions aux problèmes rencontrés. Cependant, s'il existe plusieurs solutions, certaines se généralisant bien et d'autres mal, l'algorithme lui-même n'incitera pas le système à choisir la solution offrant une bonne généralisation. Sutton a expliqué que cela explique également pourquoi les systèmes d'apprentissage profond sont sujets à des problèmes tels que l'oubli catastrophique.

https://www.dwarkesh.com/p/richard-sutton

https://www.dwarkesh.com/p/richard-sutton

Le père de l'informatique quantique : décrypter la théorie de la gravité quantique pourrait devenir une nouvelle référence pour juger l'IA générale

Le père de l'informatique quantique : décrypter la théorie de la gravité quantique pourrait devenir une nouvelle référence pour juger l'IA générale

Le 25 septembre, lors d'un événement de dialogue organisé au siège d'Axel Springer à Berlin, en Allemagne, le PDG d'OpenAI, Sam Altman, et David Deutsch, célèbre physicien britannique et « père de l'informatique quantique », ont eu une discussion approfondie sur les critères d'évaluation de l'AGI et sont parvenus à un consensus.

Selon Deutsch, la capacité des grands modèles linguistiques à mener des conversations continues repose principalement sur la quantité massive de connaissances qu'ils reçoivent, tandis que la véritable intelligence devrait se refléter dans la capacité à créer des connaissances, c'est-à-dire la capacité à découvrir des problèmes, à inventer des solutions, à les tester et à les améliorer en permanence.

Pour illustrer ce point, Deutsch cite la théorie de la relativité d'Einstein en exemple : « Certains se sont demandés si Einstein avait réellement créé la théorie de la relativité ou s'il avait simplement combiné mécaniquement des idées existantes. Nous en sommes certains, car nous comprenons son processus de recherche, les problèmes qu'il cherchait à résoudre et ses motivations. »

Il a cependant admis ouvertement qu'il pensait auparavant que les ordinateurs ne pouvaient pas avoir de conversations ouvertes sans IAG, mais les performances de ChatGPT ont remis en question cette conviction. Il a déclaré : « Bien que ChatGPT ne soit pas une IAG, il permet de dialoguer. »

En réponse à la remarque de Deutsch, Altman a posé une question hypothétique : si GPT-8 pouvait résoudre le problème de la gravité quantique et détailler son histoire de recherche, y compris le choix du problème et la motivation de la recherche, « cela suffirait-il à vous convaincre ? »

Deutsch répondit catégoriquement : « Je pense que oui. » Ultraman sourit et dit : « Je suis d'accord avec ça comme critère de test. »

https://www.businessinsider.com/sam-altman-predicts-ai-agi-surpass-human-intelligence-2030-2025-9

https://www.businessinsider.com/sam-altman-predicts-ai-agi-surpass-human-intelligence-2030-2025-9

Le temps des œufs de Pâques

Auteur : @azed_ai

Mot d'ordre : Un rendu 3D low-poly d'un [sujet], construit à partir de facettes triangulaires nettes avec des surfaces planes [couleur1] et [couleur2]. L'environnement est un désert numérique stylisé à la géométrie minimale et à l'occlusion ambiante.

Lien : https://x.com/azed_ai/status/1971892865581350967

#Bienvenue pour suivre le compte public officiel WeChat d'iFaner : iFaner (ID WeChat : ifanr), où du contenu plus passionnant vous sera présenté dès que possible.

MuskxAI poursuit OpenAI pour avoir prétendument volé des secrets commerciaux

MuskxAI poursuit OpenAI pour avoir prétendument volé des secrets commerciaux Meta mise sur une plateforme robotique « de type Android »

Meta mise sur une plateforme robotique « de type Android » Microsoft annonce que l'assistant Copilot introduit le modèle Claude, réduisant ainsi la dépendance à OpenAI

Microsoft annonce que l'assistant Copilot introduit le modèle Claude, réduisant ainsi la dépendance à OpenAI La version interne de ChatGPT d'Apple a fuité, préparant le nouveau Siri

La version interne de ChatGPT d'Apple a fuité, préparant le nouveau Siri Meta lance le service de streaming vidéo IA « Vibes », Zuckerberg en fait personnellement la promotion et est critiqué par les internautes

Meta lance le service de streaming vidéo IA « Vibes », Zuckerberg en fait personnellement la promotion et est critiqué par les internautes L'ancien directeur technique d'OpenAI annonce sa deuxième réussite entrepreneuriale

L'ancien directeur technique d'OpenAI annonce sa deuxième réussite entrepreneuriale Le modèle DeepSeek à nouveau mis à jour, la version ultime

Le modèle DeepSeek à nouveau mis à jour, la version ultime ChatGPT lance l'assistant d'information proactif « Pulse »

ChatGPT lance l'assistant d'information proactif « Pulse » Google DeepMind lance un nouveau modèle d'IA qui permet aux robots de rechercher sur le Web pour les aider à accomplir des tâches complexes

Google DeepMind lance un nouveau modèle d'IA qui permet aux robots de rechercher sur le Web pour les aider à accomplir des tâches complexes Google lance l'application Androidify pour créer des « personnes Android » personnalisées

Google lance l'application Androidify pour créer des « personnes Android » personnalisées OpenAI Chief Scientist : Après le codage de l'atmosphère, peut-être viendra la « recherche sur l'atmosphère »

OpenAI Chief Scientist : Après le codage de l'atmosphère, peut-être viendra la « recherche sur l'atmosphère » Lauréat du prix Turing : les grands modèles de langage sont une impasse

Lauréat du prix Turing : les grands modèles de langage sont une impasse Le père de l'informatique quantique : décrypter la théorie de la gravité quantique pourrait devenir une nouvelle référence pour juger l'IA générale

Le père de l'informatique quantique : décrypter la théorie de la gravité quantique pourrait devenir une nouvelle référence pour juger l'IA générale