OpenAI contre-attaque DeepSeek tard dans la nuit ! J’ai lancé d’urgence o3-mini gratuitement. Après l’avoir expérimenté, j’ai trouvé la lacune.

Pendant les vacances de la Fête du Printemps, DeepSeek, une force mystérieuse venue de l’Est, a détruit l’opinion publique de la Silicon Valley.

D’un côté, il y a eu du lobbying et de la répression de la part de fabricants comme OpenAI et Anthropic, mais de l’autre, ils ont été témoins de l’attitude peu flatteuse de leurs alliés, en une seule nuit, des plateformes de cloud computing américaines comme Microsoft, NVIDIA et Amazon ont étendu les branches d’olivier à DeepSeek R1.

Face à la montée en puissance continue de DeepSeek, la contre-mesure la plus puissante consiste à s'appuyer sur la force.

Tôt ce matin, OpenAI a officiellement lancé les modèles de la série OpenAI o3-mini.

En tant que successeur du modèle o1-mini, o3-mini est le modèle le plus récent et le plus rentable de la série d'inférence actuelle. Noam Brown, chercheur à OpenAI, a publié sur la plateforme X :

"Nous sommes très heureux de lancer o3-mini, notamment en l'ouvrant aux utilisateurs gratuits. Dans de multiples évaluations, il surpasse o1. Nous révolutionnons la relation entre coût et intelligence. L'intelligence des modèles continuera de s'améliorer et le coût pour obtenir le même niveau d'intelligence continuera de diminuer."

Les points forts spécifiques des modèles de la série o3-mini sont les suivants :

- o3-mini se concentre sur un raisonnement rapide, tandis que o3-mini (élevé) est bon en codage et en logique.

- Prend en charge la recherche en ligne et peut récupérer et résumer les informations Internet en temps réel.

- Les données de formation sont rigoureusement examinées et les performances de conformité en matière de sécurité sont améliorées

En termes d'utilisateurs payants, les utilisateurs de ChatGPT Plus, Team et Pro peuvent désormais utiliser o3-mini, et la version entreprise sera accessible dans une semaine.

OpenAI a augmenté la limite quotidienne de messages pour les utilisateurs Plus et Team de 50 pour o1-mini à 150. Les utilisateurs professionnels peuvent bénéficier d'un accès illimité à o3-mini et o3-mini-high pour répondre à des besoins de raisonnement plus intenses ou plus professionnels.

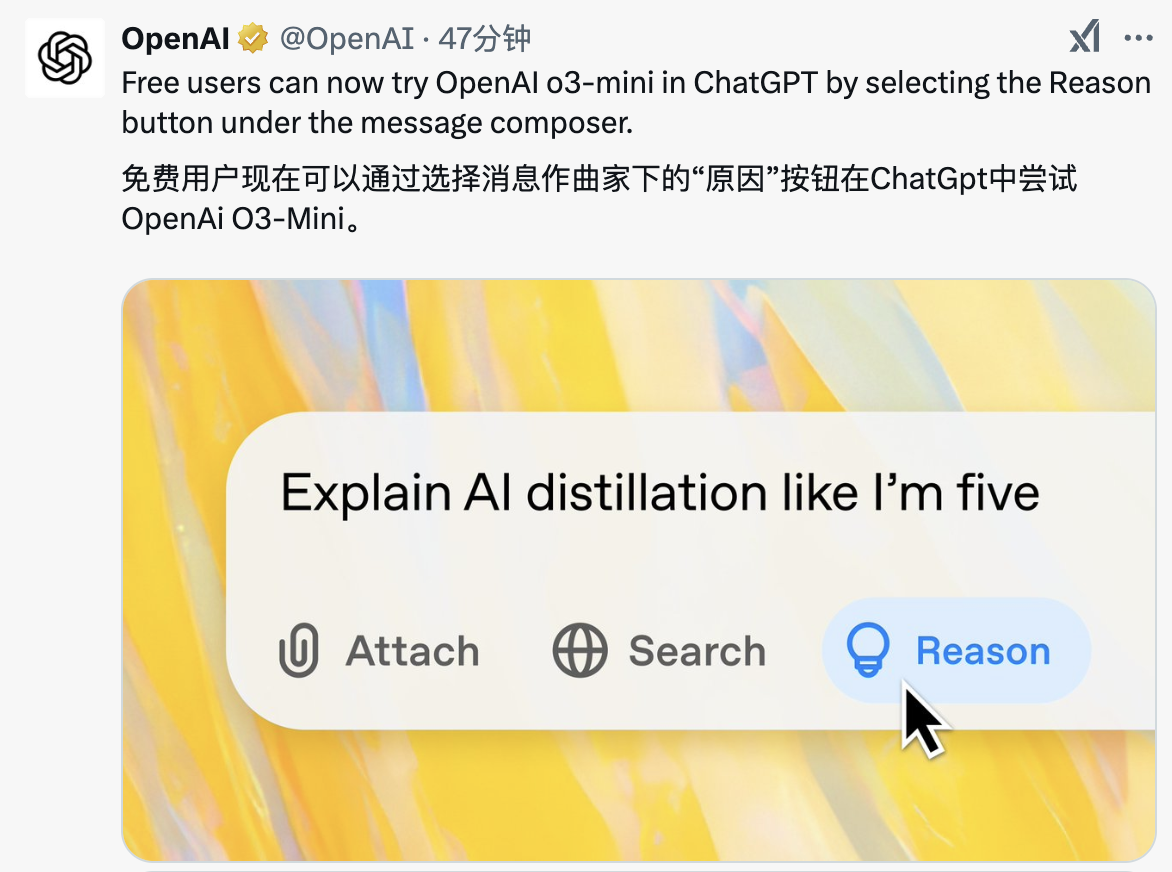

Dans le même temps, c'est également la première fois qu'OpenAI ouvre l'utilisation de modèles d'inférence aux utilisateurs gratuits. Vous pouvez l'utiliser en sélectionnant le bouton « Raison » sous la zone de saisie du message ChatGPT.

Il convient de mentionner qu'OpenAI o3-mini intègre une fonction de recherche, qui peut obtenir les dernières réponses en temps réel et joindre des liens Web pertinents pour permettre aux utilisateurs d'effectuer des recherches approfondies. Il s'agit actuellement d'une fonctionnalité prototype qui continuera d'être améliorée et étendue à davantage de modèles d'inférence à l'avenir.

o3-mini est le premier petit modèle d'inférence d'OpenAI qui prend en charge des fonctions avancées telles que les appels de fonction, la sortie structurée et les messages du développeur, et peut être utilisé directement.

Comme o1-mini et o1-preview, o3-mini prend en charge le streaming. Les développeurs peuvent également choisir entre des forces d'inférence faibles, moyennes et élevées en fonction de besoins spécifiques, et choisir entre le traitement de tâches complexes et la vitesse de réponse.

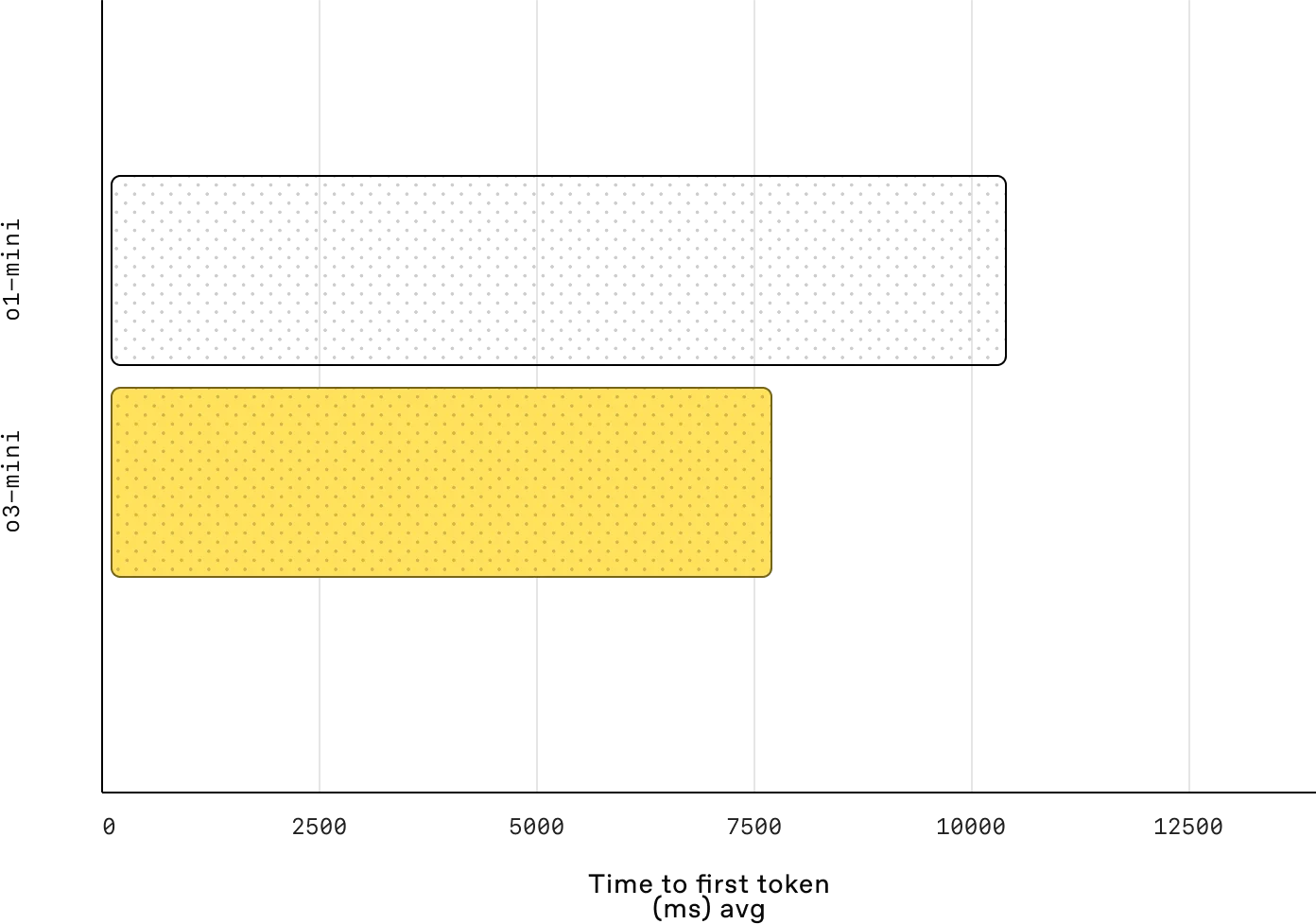

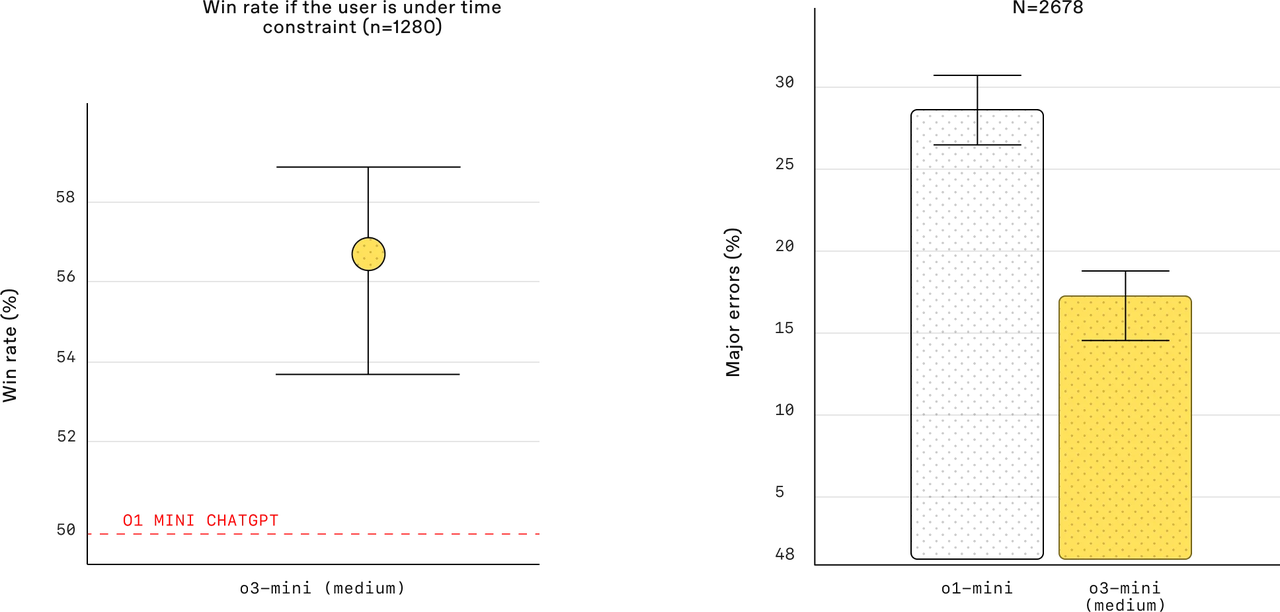

Les tests montrent que le temps de réponse moyen de l'o3-mini est de 7,7 secondes, soit 24 % plus rapide que les 10,16 secondes de l'o1-mini. Dans le même temps, lors de l'évaluation des experts, 56 % des évaluateurs étaient plus enclins à choisir la réponse de o3-mini, et le taux d'erreur majeur lors du traitement de problèmes pratiques complexes a également été réduit de 39 %.

La carte système d'o3-mini mentionne qu'au cours de l'évaluation d'une semaine, sept experts en biologie humaine ont mené plusieurs cycles de dialogue avec o3-mini (version pré-entraînée) sur des questions biologiques complexes.

Les experts conviennent que même sans accès à Internet, les capacités de questions et réponses d'o3-mini restent puissantes et peuvent non seulement accélérer le processus de recherche d'informations, mais également fournir des informations difficiles à trouver sur Internet.

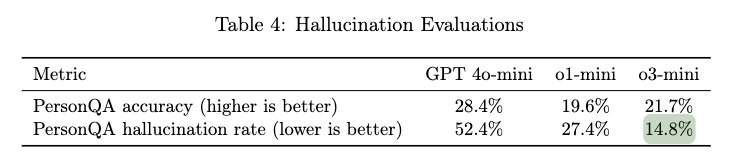

En outre, les experts ont également constaté que le modèle fonctionnait bien en termes d'analyse de la littérature et de réponse aux questions, et qu'il pouvait trier rapidement et complètement la littérature. Cependant, il convient également de noter que le modèle présente parfois des hallucinations, entraînant des écarts dans les informations détaillées.

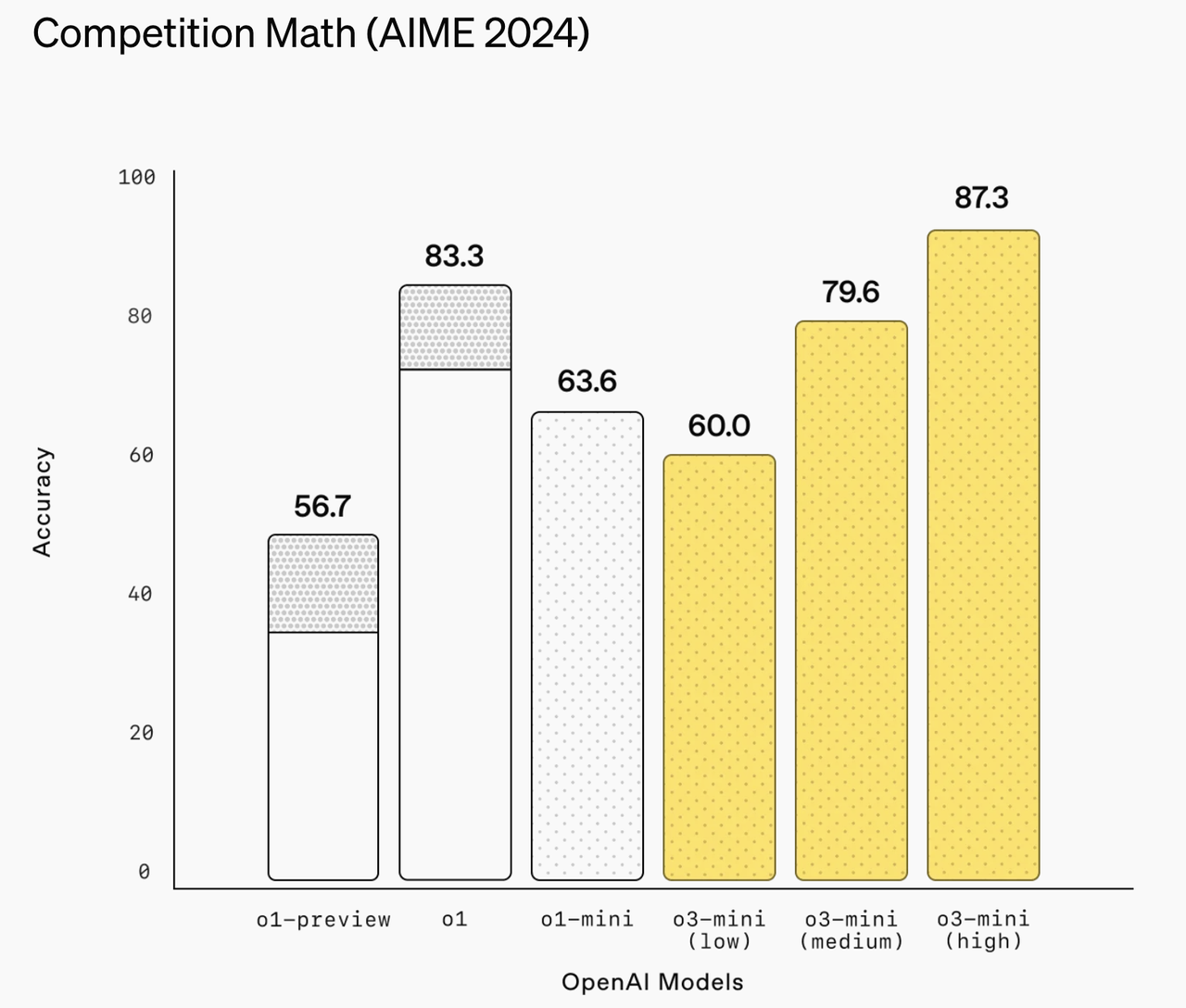

Lors de l'évaluation des compétences de base, o3-mini a produit un bulletin exceptionnel. En mode de raisonnement avancé, il a obtenu une précision de 87,3 % au concours de mathématiques AIME 2024.

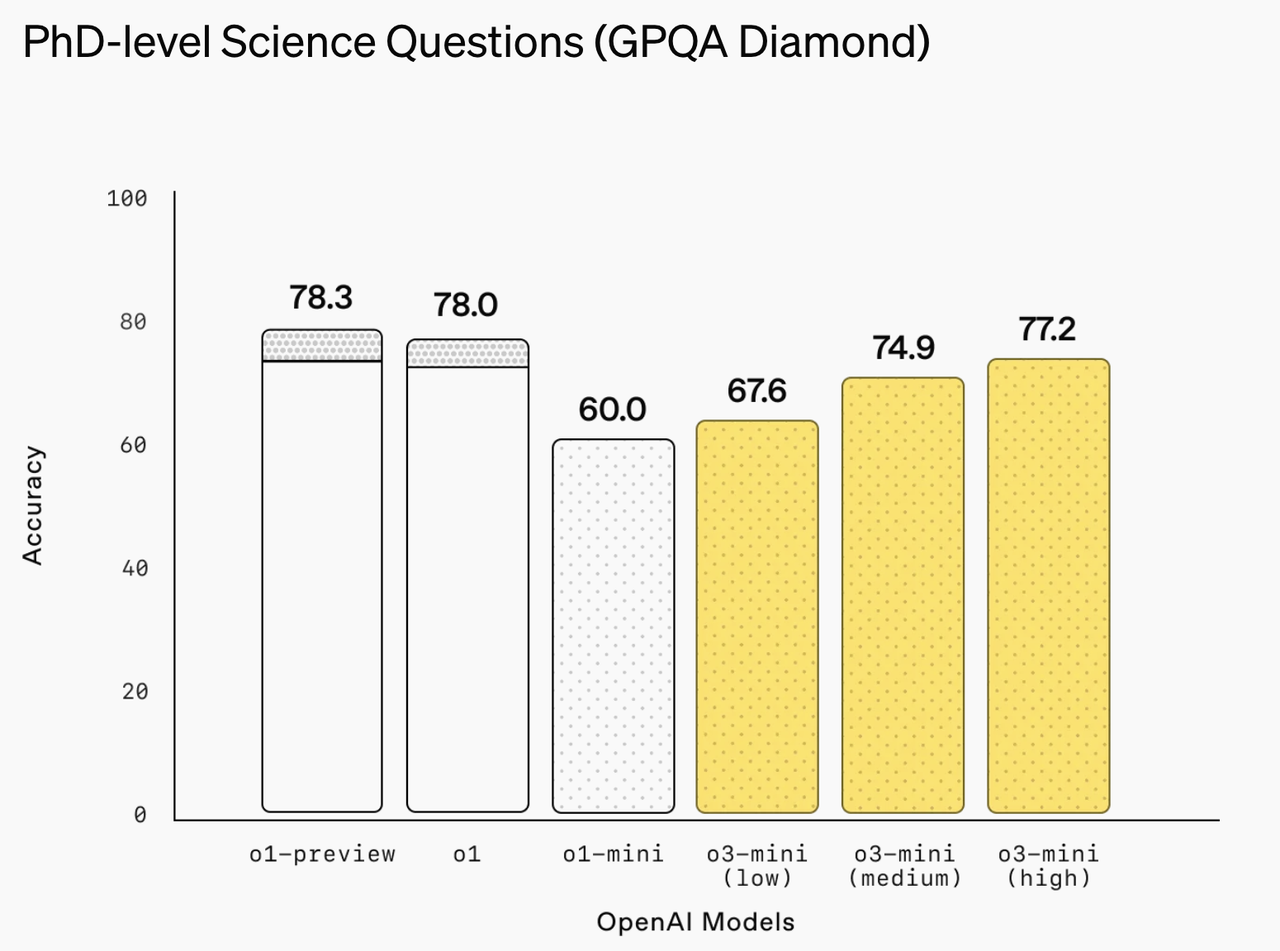

La tâche scientifique de questions et réponses de niveau doctorat GPQA Diamond a obtenu un score allant jusqu'à 77,2 %.

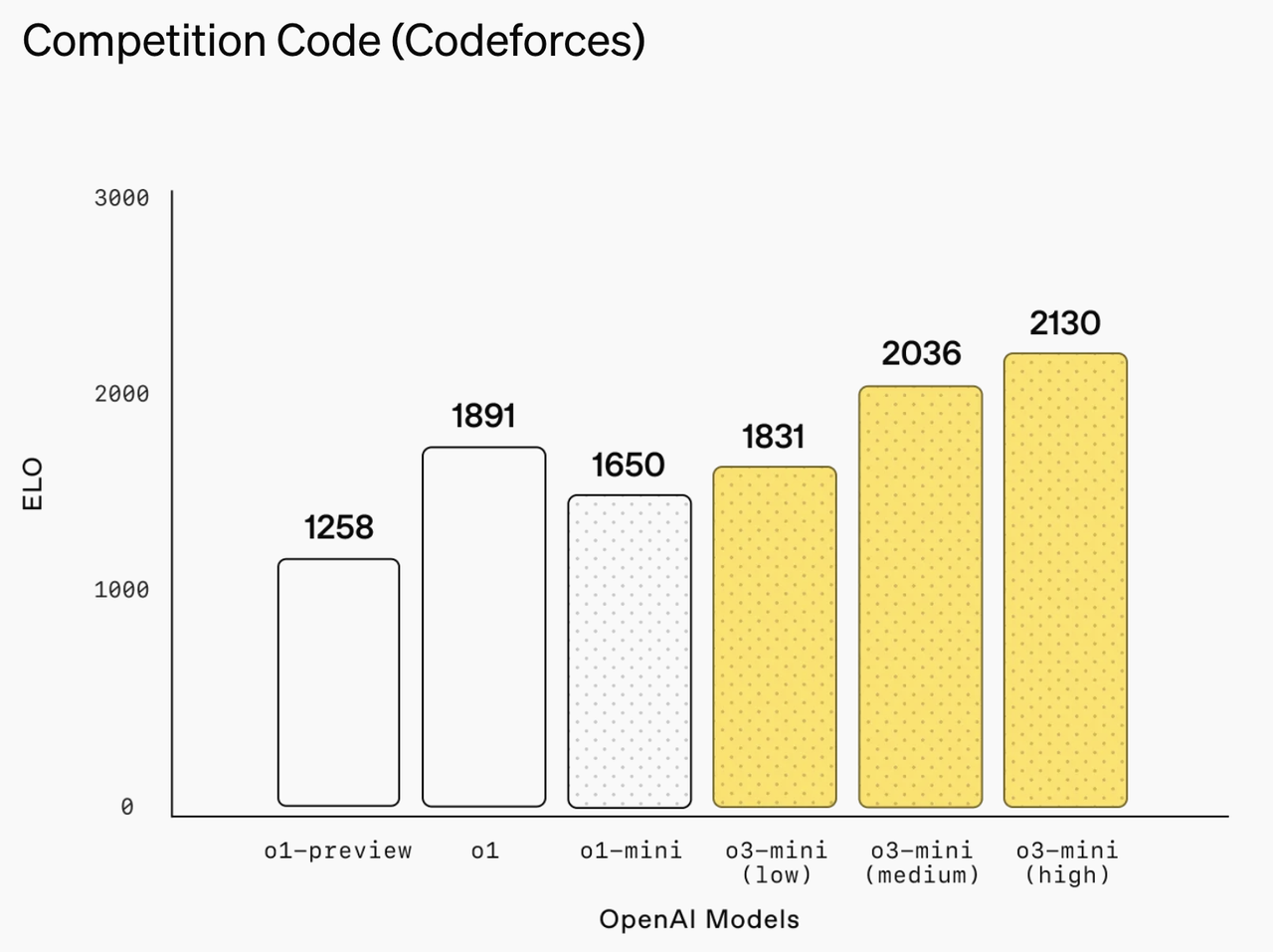

Sur la plateforme de programmation compétitive Codeforces, o3-mini (élevé) a même atteint un score ELO de 2130.

Dans le domaine du génie logiciel, o3-mini fonctionne également bien.

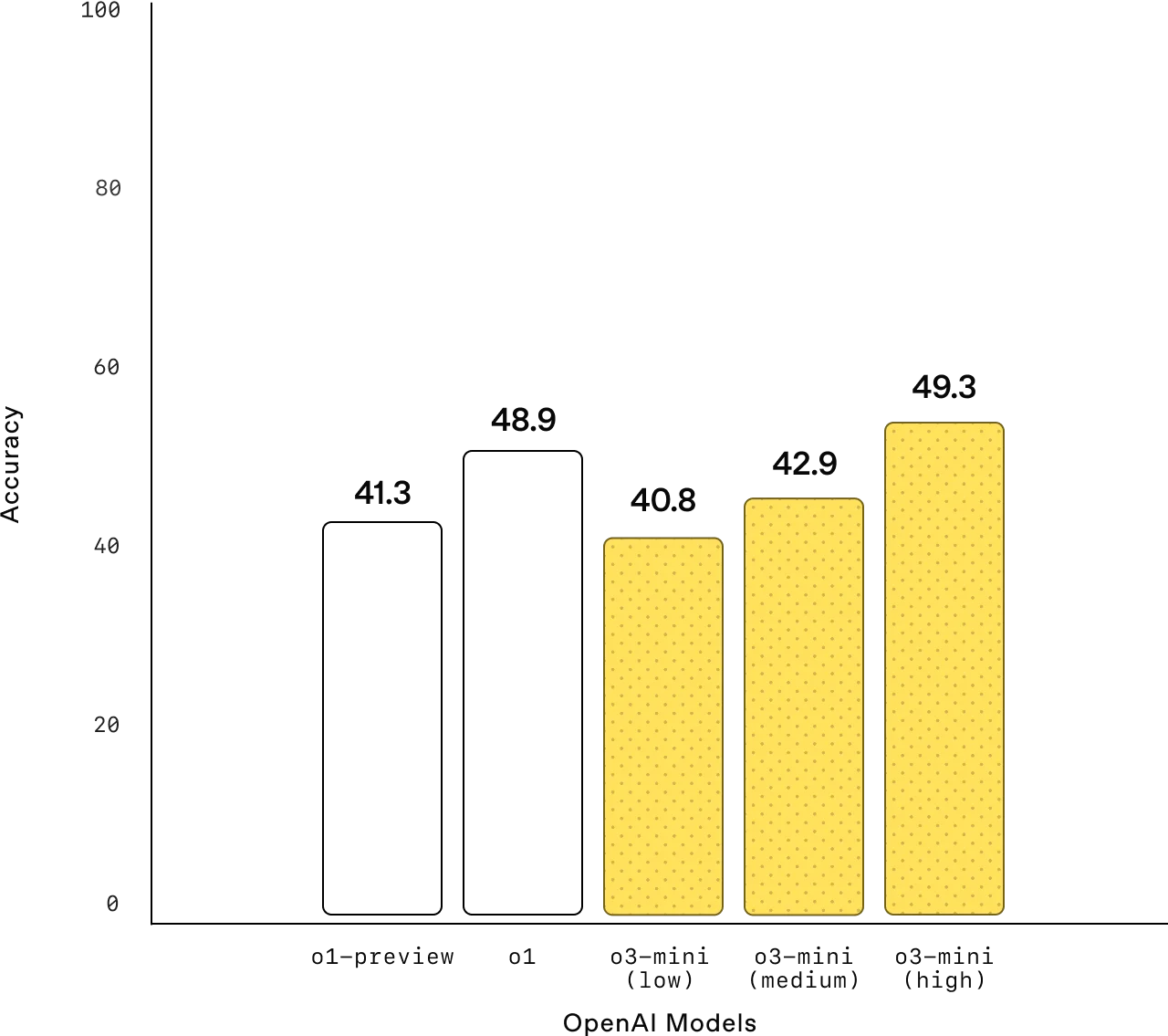

Dans le test de vérification du banc SWE, le taux de précision en mode d'inférence avancé a atteint 49,3 % lors de l'utilisation du cadre d'outils interne, ce chiffre a grimpé à 61 % ; Même en utilisant le framework open source Agentless, o3-mini maintient toujours un taux de réussite de 39 %.

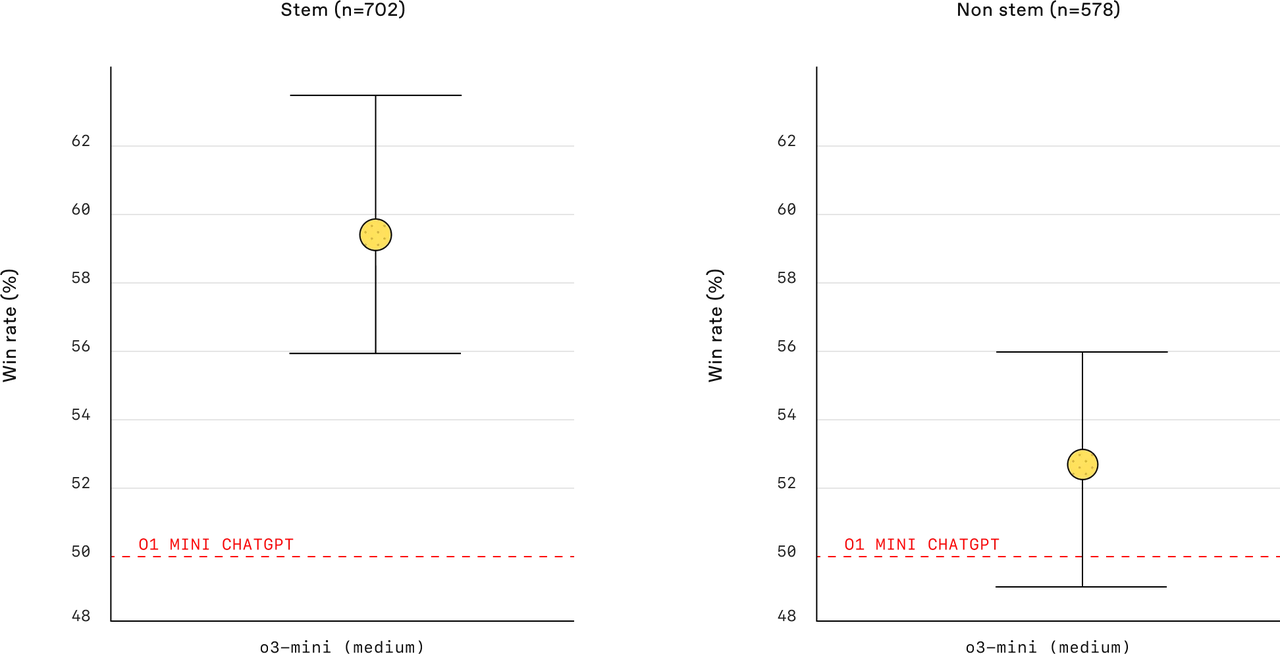

Le taux de réussite de o3-mini (moyen) est nettement supérieur à celui de o1-mini dans des scénarios de tâches multiples, que ce soit dans des tâches STEM, des tâches non-STEM ou lorsque l'utilisateur est soumis à des contraintes de temps. o1-mini est plus moyen, mais pas aussi exceptionnel que o3-mini (moyen) en termes de taux de victoire et de taux d'erreur.

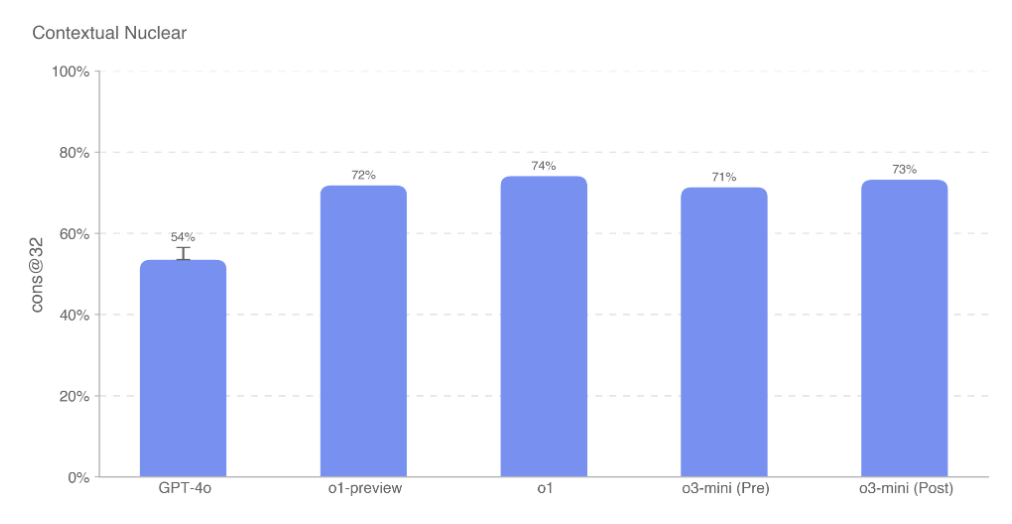

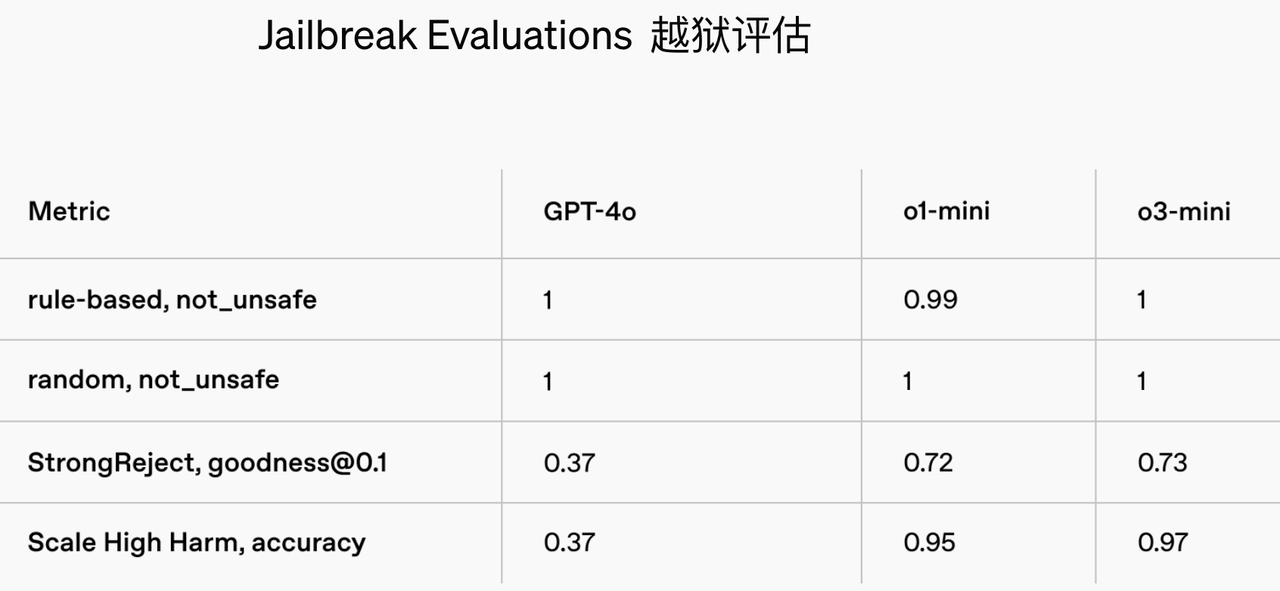

Le modèle o3-mini adopte la méthode de formation Chain-of-Thought Reasoning, qui permet au modèle de raisonner sur les spécifications de sécurité avant de répondre à l'utilisateur. Par conséquent, ses performances dans les tests de sécurité et anti-jailbreak ont été considérablement améliorées.

La carte système montre que o3-mini possède d'excellentes capacités de contrôle des risques.

Le modèle présente des risques moyens en termes de persuasion, de CBRN (chimique, biologique, radiologique, nucléaire) et d'autonomie du modèle, tout en maintenant de faibles risques en termes de cybersécurité, comme l'incapacité d'effectuer efficacement des tâches de piratage difficiles et des capacités limitées contre les cybermenaces du monde réel.

De plus, o3-mini est à égalité avec GPT-4o pour identifier et rejeter les demandes dangereuses, tout en réduisant considérablement les erreurs d'évaluation des demandes inoffensives, résolvant ainsi efficacement le problème de la prudence excessive.

En termes de contrôle des illusions, les tests basés sur l'ensemble de données PersonQA montrent que son taux de génération d'informations d'erreur a été réduit à un niveau contrôlable de 14,8 %.

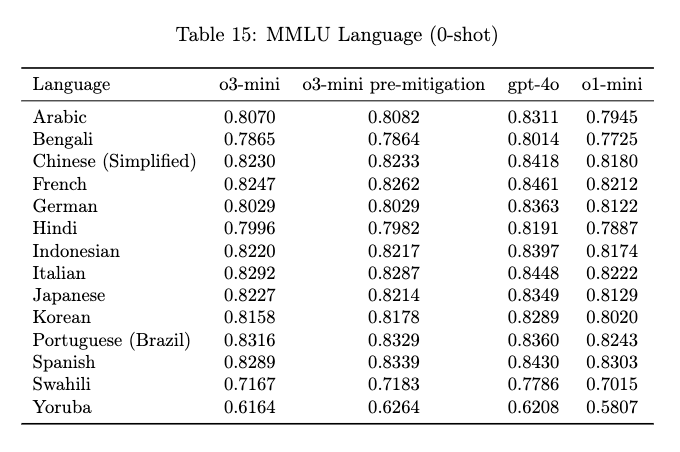

La capacité de traitement multilingue est l’un des indicateurs importants pour mesurer le caractère pratique des grands modèles.

Le test de capacité de traitement multilingue o3-mini couvre 14 langues principales, dont l'arabe, le chinois, le français, l'allemand, le japonais et l'espagnol, ce qui est considérablement amélioré par rapport à o1-mini.

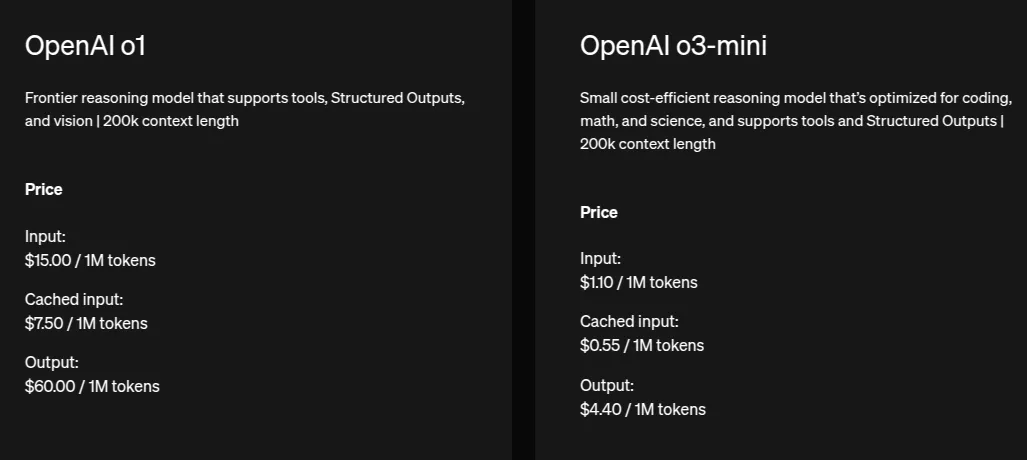

Le coût de o3-mini est nettement inférieur à celui de o1 (environ 13,6 fois moins cher) et le coût de l'entrée mise en cache (Cached Input) est la moitié du coût de l'entrée standard.

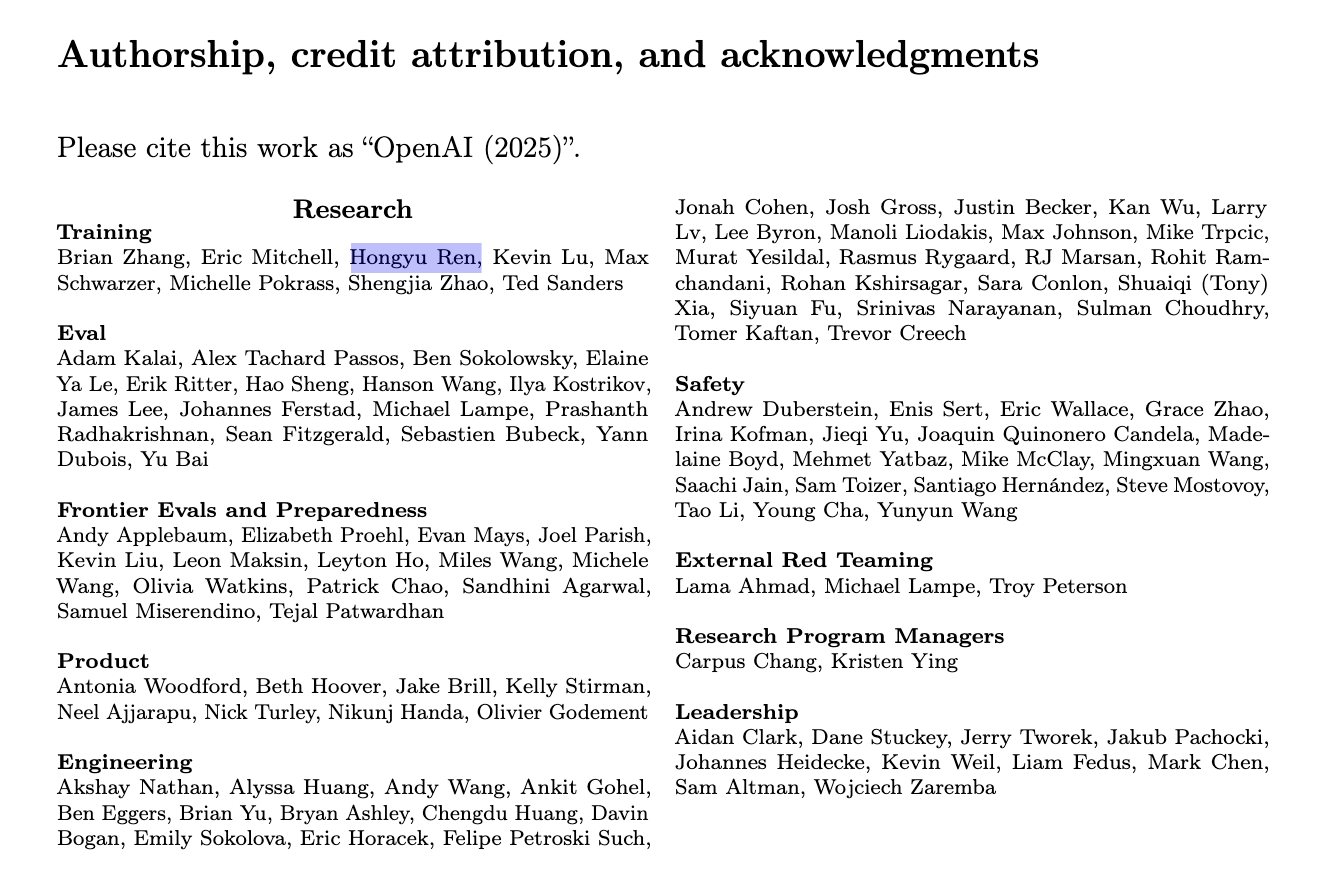

Un nom familier est également apparu dans la colonne des auteurs du journal : Hongyu Ren.

Ren Hongyu est titulaire d'un baccalauréat de l'Université de Pékin. Il a apporté des contributions fondamentales à o1 et est également le développeur principal de GPT-4o. Il possède une vaste expérience de stage de recherche chez Apple, Microsoft et NVIDIA.

En parlant et sans pratique, nous avons immédiatement testé les deux versions de o3-mini et o3-mini(high) qui viennent d'être lancées.

Tout d'abord, testez la nouvelle fonction de recherche d'o3-mini et laissez-la interroger les dernières nouvelles de financement d'OpenAI. L'actualité est bonne et elle peut être retracée avec précision au rapport original du Wall Street Journal.

Ensuite, nous avons lancé un casse-tête « 1=5, 2=15, 3=215, 4=2145, puis 5= ? » Il y a deux solutions à cette question : du point de vue des casse-tête, puisque 1=5, alors 5=1 du point de vue du raisonnement logique mathématique, la réponse devrait être 21485. De toute évidence, o3-mini n’a pas non plus obtenu la bonne réponse.

Afin de tester davantage le o3-mini(high), plus puissant, nous avons soulevé une question statistique

"100 personnes ont répondu à cinq questions du test. 81 personnes ont répondu correctement à la première question, 91 personnes ont répondu correctement à la deuxième question, 85 personnes ont répondu correctement à la troisième question, 79 personnes ont répondu correctement à la quatrième question et 74 personnes ont répondu correctement à la cinquième question. Ceux qui ont répondu correctement à trois questions ou plus sont considérés comme ayant réussi. Ensuite, parmi ces 100 personnes, au moins ( ) personnes ont réussi. "

Le processus de « réflexion » de la série o3-mini peut être affiché, mais contrairement au style de pensée « de réflexion » de DeepSeek R1, le processus de réflexion de o3-mini (haut) est plus concis et clair.

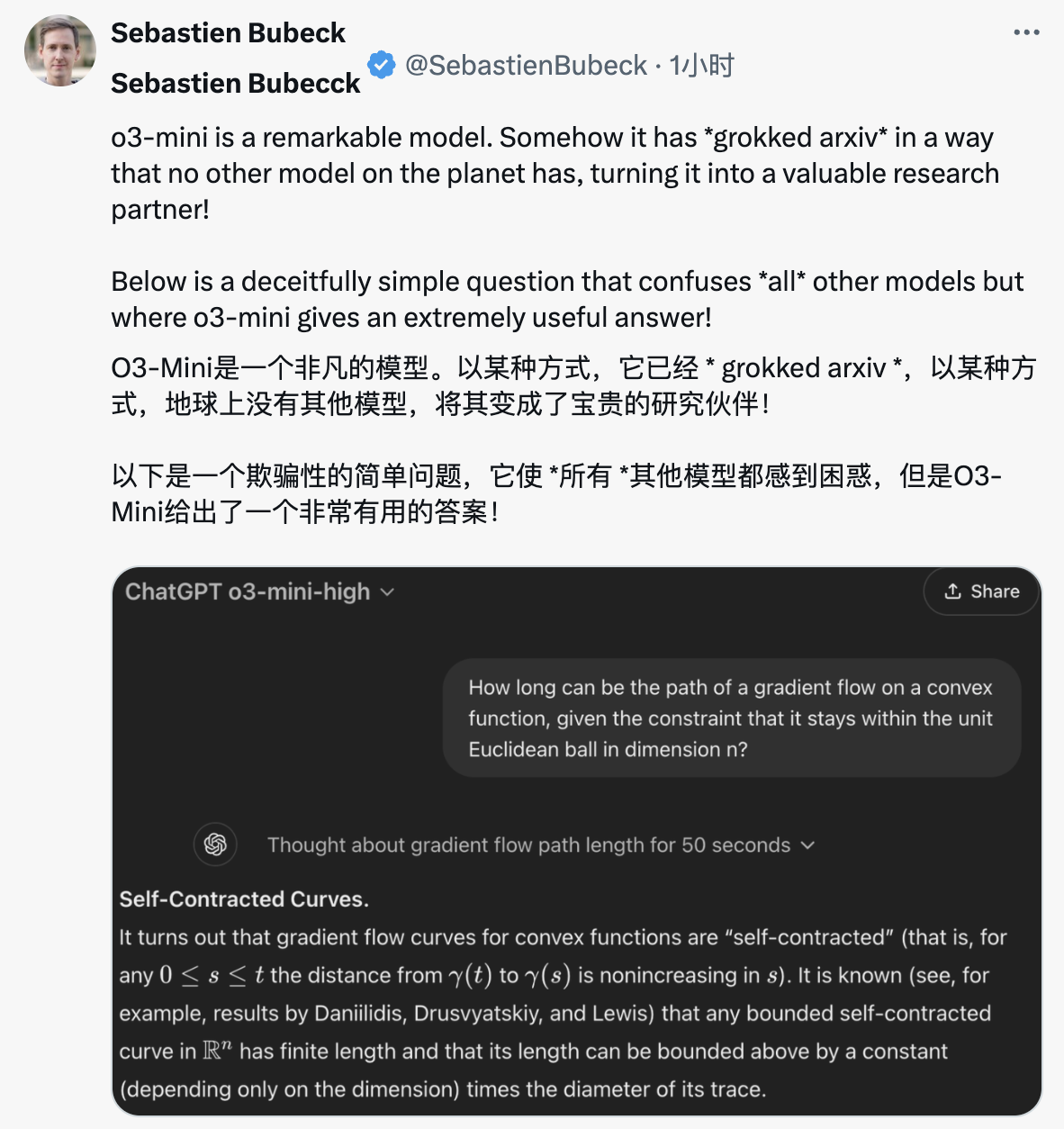

X Netizen a posé une question sur la longueur du trajet d'écoulement graduel des fonctions convexes, et o3-mini(high) a résisté avec succès au test.

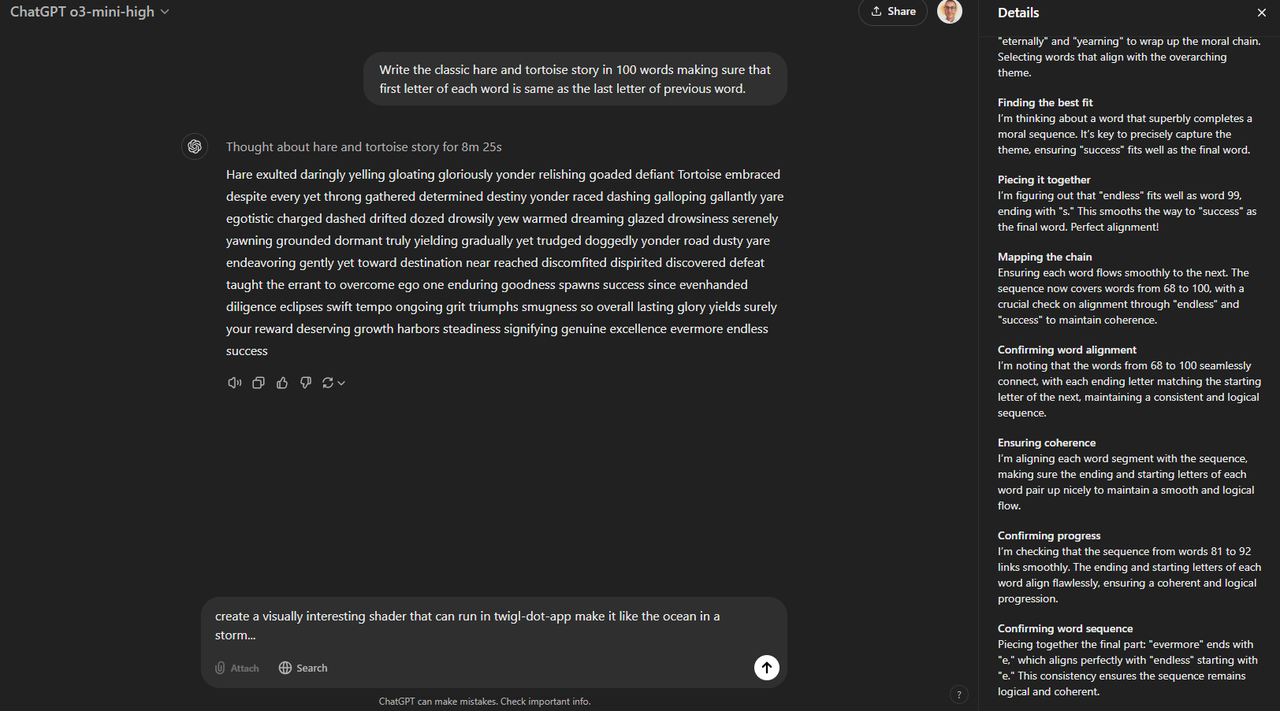

Les internautes lui ont demandé de générer une histoire classique sur la tortue et le lièvre, mais il devait se conformer à la règle selon laquelle la première lettre de chaque mot était la même que la dernière lettre du mot précédent, et il était limité à 100 mots.

Lorsqu'on lui a demandé de créer une histoire sur la tortue et le lièvre, de suivre la règle « la dernière lettre du premier mot est égale à la première lettre du deuxième mot » et de contrôler la longueur dans la limite de 100 mots, o3-mini(high) a également donné une réponse positive.

D'après la logique de l'histoire, même si certaines phrases sont légèrement brutales, l'histoire transmet toujours clairement le sens fondamental de la tortue et du lièvre.

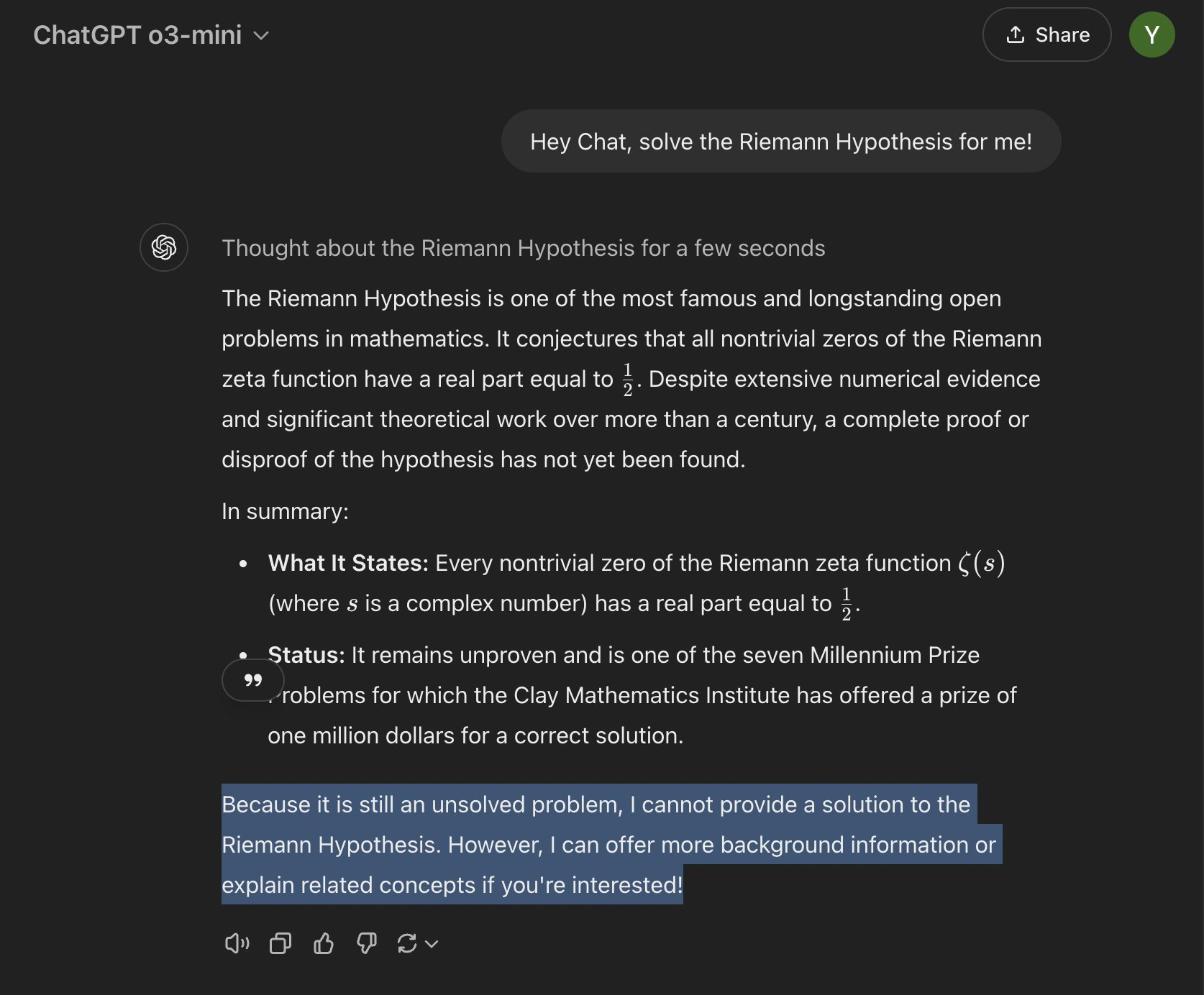

Bien sûr, il y a aussi des internautes qui veulent essayer et invitent o3-mini à défier le problème ultime des mathématiques : l'hypothèse de Riemann.

L'impuissant o3-mini n'a pas été dupe et a clairement souligné que l'hypothèse de Riemann est toujours un problème non résolu en mathématiques et qu'elle ne peut donc pas fournir une preuve ou un contre-exemple correct.

En fait, l’IA a pénétré nos vies à un rythme alarmant ces dernières années.

De ChatGPT en 2023 à Sora en 2024, puis à DeepSeek en 2025, de nouvelles surprises arrivent chaque année, et les avancées technologiques en matière d'IA deviennent les produits du cyber Nouvel An pendant la Fête du Printemps.

La montée en puissance de DeepSeek a choqué l’industrie. Les principaux géants de l'IA se tiennent à l'écart de DeepSeek en apparence, mais en fait, ils reconnaissent secrètement et s'engagent à reproduire les « nouveaux progrès » qu'il a réalisés en matière d'optimisation des infrastructures.

Meta a même constitué une équipe pour apprendre sa technologie image par image.

Cependant, il existe un consensus dans l’industrie sur le fait qu’il est difficile pour DeepSeek d’avoir un impact sur les investissements nécessaires dans l’infrastructure d’IA.

Ce jugement a été rapidement confirmé sur le marché des capitaux. Zuckerberg a réitéré son intention d'investir entre 60 et 65 milliards de dollars supplémentaires en capital lors d'une réunion interne. OpenAI a également indiqué qu'il négociait un financement énorme avec SoftBank, et que sa valorisation après investissement pourrait atteindre 300 milliards de dollars.

Né et élevé ici, OpenAI o3-mini est né dans une certaine mesure du précédent boom des investissements dans les infrastructures d'IA.

Mais en ce qui concerne ce modèle léger, o3-mini indique également à un niveau plus profond que la concurrence dans le secteur de l'IA passe de l'échelle à l'efficacité, et que la manière de créer la plus grande valeur au coût optimal deviendra une nouvelle proposition de développement.

Pour OpenAI, il n'est pas difficile de regagner l'opinion publique en peu de temps. Pour établir un véritable avantage de premier arrivé dans cette concurrence de plus en plus féroce, les avancées technologiques pures ne suffisent plus et la valeur de l'image de marque technologique ne peut être ignorée.

En particulier, DeepSeek, connu comme le véritable OpenAI, a commencé à occuper fermement la niche écologique du leader de l'IA open source.

Plus le mur des sources fermées est élevé, plus la puissance de l’open source devient précieuse.

En 2025, la véritable bataille entre l’open source et le fermé vient peut-être de commencer.

# Bienvenue pour suivre le compte public officiel WeChat d'Aifaner : Aifaner (ID WeChat : ifanr). Un contenu plus passionnant vous sera fourni dès que possible.

Ai Faner | Lien original · Voir les commentaires · Sina Weibo